專題:DeepSeek為何能震動全球AI圈

來源:玩亦可及

2025年1月20日,杭州深度求索人工智能基礎技術研究有限公司正式發布了其最新研發的高性能AI推理模型——DeepSeek R1。該模型在數學、代碼和自然語言推理等任務上表現卓越,性能直接對標OpenAI的o1正式版,同時以開源形式向全球開發者開放,並使用MIT協議開源,支持免費商用,無需申請授權,為LLM大模型開源世界又補給了滿滿一倉庫彈藥。

好巧不巧,以文本處理和輸出見長的另一家國內大模型公司——月之暗面,也發布了Kimi k1.5推理模型,同樣號稱比肩OpenAI o1。一個開源,一個閉源,國產大模型技術,似乎和世界頂級水平正在拉近。

擴展閱讀:

- 《思源筆記同時調用文心Ernie、Moonshot、DeepSeek、豆包大模型》

- 《AI自動撰寫WordPress文章的腳本,DeepSeek V3 10秒搞定》

DeepSeek R1的核心優勢

DeepSeek R1的最大亮點在於其通過強化學習(RL)技術顯著提升了模型的推理能力,且僅需極少量標註數據即可實現高效訓練。與OpenAI的o1相比,R1在多個基準測試中表現優異,同時價格僅為o1的幾十分之一,具有極高的性價比。

-

強化學習驅動的推理能力

R1在後訓練階段大規模應用了強化學習技術,無需依賴大量監督微調(SFT)數據,即可顯著提升模型的推理能力。這一創新方法不僅降低了訓練成本,還使模型在複雜任務中表現出色。

-

長鏈推理與模型蒸餾

R1採用了長鏈推理(Chain-of-Thought, CoT)技術,能夠逐步分解複雜問題,並通過多步驟邏輯推理解決問題。此外,R1支持模型蒸餾,開發者可以將其推理能力遷移到更小型的模型中,滿足特定場景需求。

-

開源與靈活的許可證

R1遵循MIT License開源協議,允許用戶自由使用、修改和商用。同時,DeepSeek還開源了R1-Zero和多個蒸餾後的小模型,進一步推動了AI技術的普及與創新。

性能評測對比

以下是DeepSeek R1與其他主流模型在多個基準測試中的表現對比:

| 模型 | AIME 2024 (%) | MATH-500 (%) | Codeforces Elo | MMLU (%) | GPQA Diamond (%) |

|---|---|---|---|---|---|

| DeepSeek R1 | 79.8 | 97.3 | 2029 | 90.8 | 71.5 |

| OpenAI o1-1217 | 78.5 | 96.8 | 2015 | 91.2 | 70.8 |

| DeepSeek-V3 | 68.7 | 89.4 | 1950 | 85.6 | 65.3 |

| Qwen2.5-32B | 55.5 | 72.6 | 1800 | 78.4 | 60.2 |

| Llama3-70B | 58.3 | 75.1 | 1825 | 79.8 | 61.5 |

數據來源:

R1系列模型及其蒸餾版本的性能表現

DeepSeek此次發布了R1-Zero、R1以及多個蒸餾後的小模型,以下是它們的性能對比:

|

模型 |

AIME 2024 (%) | MATH-500 (%) | LiveCodeBench (%) |

|---|---|---|---|

| DeepSeek R1-Zero | 71.0 | 89.7 | 55.2 |

| DeepSeek R1 | 79.8 | 97.3 | 57.2 |

| R1-Distill-Qwen-1.5B | 65.4 | 85.2 | 52.8 |

| R1-Distill-Qwen-7B | 68.9 | 88.6 | 54.3 |

| R1-Distill-Qwen-8B | 70.2 | 89.1 | 55.0 |

| R1-Distill-Qwen-14B | 72.6 | 90.5 | 56.1 |

| R1-Distill-Qwen-32B | 72.6 | 94.3 | 57.2 |

| R1-Distill-Llama-70B | 70.8 | 93.5 | 56.8 |

| Qwen2.5-32B (原始) | 55.5 | 72.6 | 45.0 |

| Llama3-70B (原始) | 58.3 | 75.1 | 47.5 |

數據來源:

從表中可以看出,R1蒸餾後的小模型在推理能力上顯著超越了原始的Qwen2.5和Llama模型,展現了R1推理模式的高效遷移性。

應用開發者的視角:DeepSeek R1與V3的本地部署與使用

1. DeepSeek R1蒸餾模型的本地部署

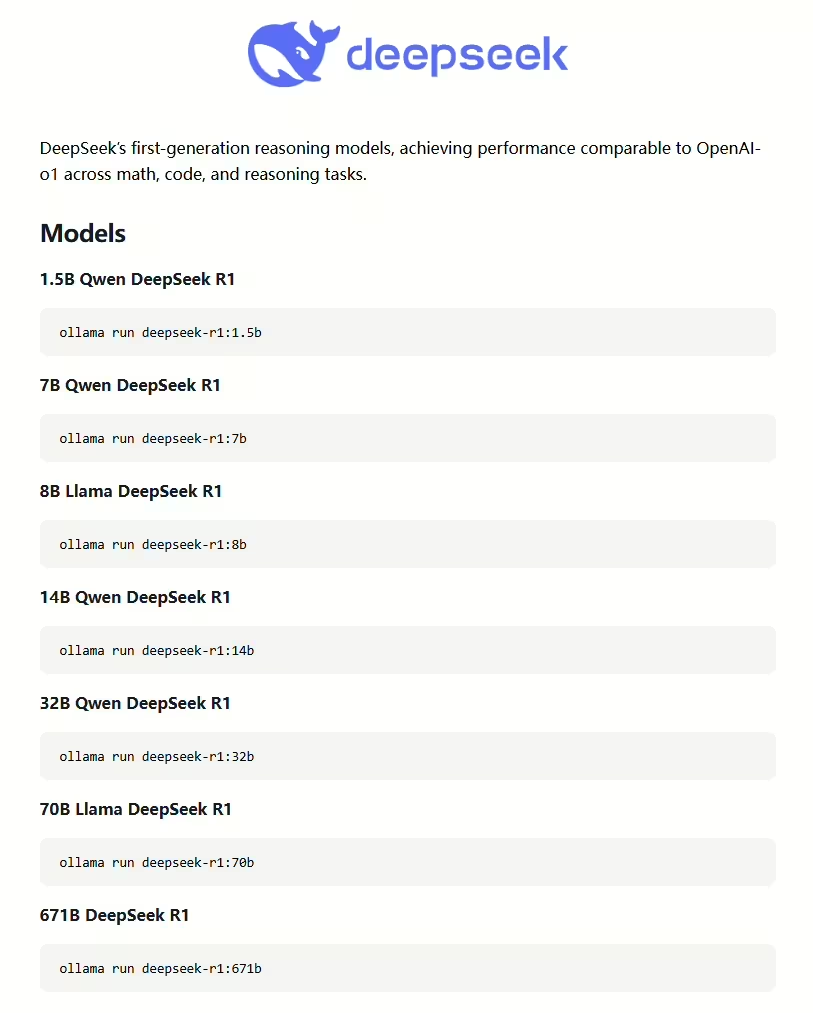

DeepSeek R1蒸餾出的1.5B、7B、8B、14B等小模型非常適合在本地部署,尤其適合資源有限的中小企業和開發者。以下是常用的部署工具和方法:

- 工具推薦:

- Ollama:一個開源的大型語言模型服務工具,支持多GPU配置、熱加載模型和與OpenAI兼容的API接口,適合快速部署和運行大規模預訓練語言模型。

- vLLM:支持FP8和BF16推理模式,適合高吞吐量的推理任務。

- LMDeploy:支持本地和雲部署,提供高效的FP8和BF16推理支持。

- TensorRT-LLM:支持INT4/8量化,適合需要極致性能的場景。

- SGLang:完全支持BF16和FP8推理模式,適合多令牌預測任務。

- 部署步驟:

- 從Hugging Face下載模型權重。

- 使用DeepSeek-Infer Demo進行權重轉換(如將FP8權重轉換為BF16)。

- 配置推理框架(如vLLM或LMDeploy),加載模型並啓動服務。

目前DeepSeek R1蒸餾出來的這6個小體積模型,已經上線到Ollama官網。已經在本機安裝Ollama的朋友,可以直接通過命令行工具,用ollama pull或ollama run命令下載和運行這些模型。我個人剛把原始版的Qwen2.5 7B刪除,安裝經過DeepSeek R1蒸餾過的Qwen 7B模型。我的7800XT顯卡有16GB顯存,FP8或INT8量化後,跑14B參數的模型應該也不是問題。

2. FP8與INT8量化方式

量化是降低模型顯存佔用和計算開銷的有效方法,以下是FP8和INT8量化的實現方式:

- FP8量化:

- E4M3與E5M2格式:FP8支持兩種格式,E4M3提供更精確的數值,E5M2提供更大的動態範圍。DeepSeek V3在訓練中採用了E4M3格式,以保持較高的數值精度。

- 量化流程:在輸入採用BF16,主權重採用FP32,量化到FP8。前向傳播時,累加後輸出為FP32,再轉換為BF16;反向傳播時,權重梯度以FP32更新,激活梯度轉換為BF16繼續傳播。

- INT8量化:

- 逐張量量化:對整個張量進行量化,使用一個scale表示。

- 逐行量化:對每一行或列進行量化,每行使用一個scale。

- 分組量化:將特定數量的元素分為一組,每組使用一個scale。

- 分塊量化:對特定區域進行量化,每塊使用一個scale。

3. DeepSeek R1與V3的應用場景對比

- DeepSeek R1:

- 適用場景:數學建模、代碼生成、複雜邏輯推理。

- 開發者使用:集成到智能客服、自動化決策系統中,提升複雜任務的解決效率。

- 內容創作者使用:用於生成邏輯嚴謹的技術文檔或學術論文。

- DeepSeek V3:

- 適用場景:自然語言處理、知識問答、內容創作。

- 開發者使用:用於智能客服、個性化推薦系統。

- 內容創作者使用:生成創意文案、新聞稿件或小說情節。

DeepSeek R1與月之暗面Kimi k1.5的對比

1. 設計與功能

- DeepSeek R1:

- 設計:基於強化學習(RL)驅動,專注於數學和代碼推理。

- 功能:支持長鏈推理(CoT)和模型蒸餾,適用於複雜邏輯任務。

- Kimi k1.5:

- 設計:多模態思考模型,支持視覺和文本的多模態推理。

- 功能:在數學、代碼和視覺任務上表現優異,適合多模態應用場景。

2. 參數與性能

- DeepSeek R1:660B參數,在AIME 2024和MATH-500上表現優於Kimi k1.5。

- Kimi k1.5:128K上下文窗口,在長文本和多模態任務上表現突出。

3. 優缺點與應用場景

- DeepSeek R1:

- 優點:推理能力強,開源生態完善。

- 缺點:對多模態任務支持有限。

- 應用場景:科研、技術開發、教育。

- Kimi k1.5:

- 優點:多模態能力強,適合複雜場景。

- 缺點:推理能力略遜於R1。

- 應用場景:視覺內容生成、多模態數據分析。

總結

DeepSeek R1的發布標誌着國產AI技術的又一次重大突破。其強大的推理能力、開源生態以及高性價比的API服務,為全球開發者和企業提供了全新的選擇。隨着R1及其蒸餾版本的廣泛應用,AI技術的普及與創新將迎來新的高潮。

責任編輯:何俊熹