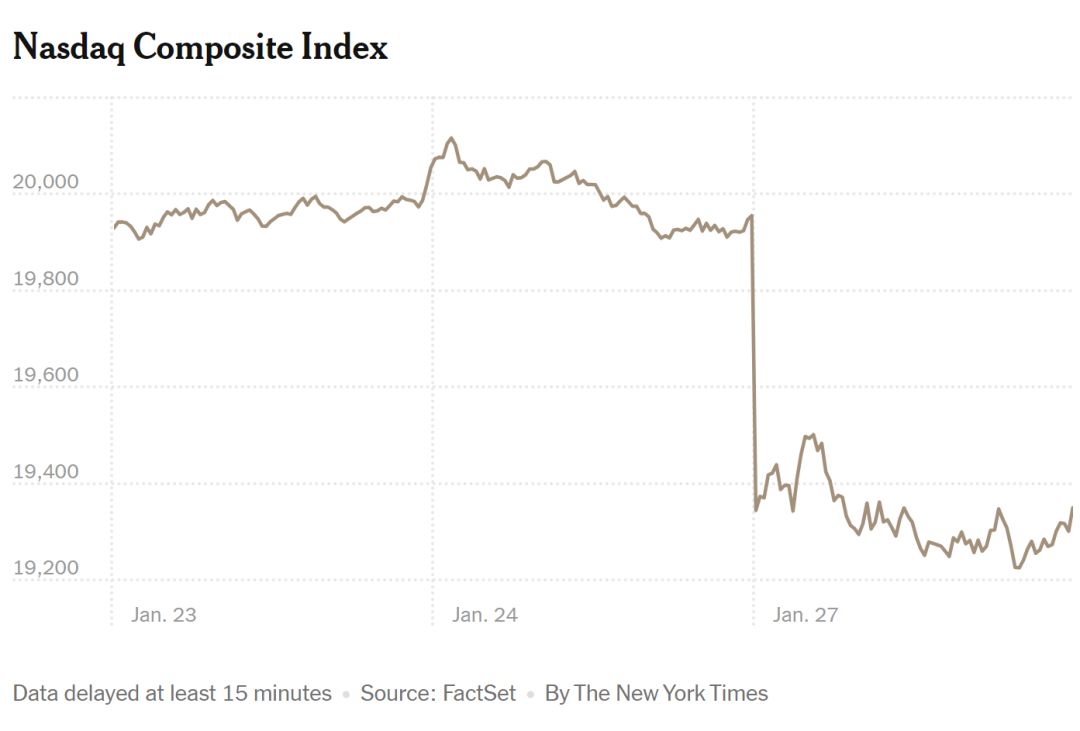

當地時間1月27日,受中國人工智能初創公司——深度求索公司(DeepSeek)衝擊,美國人工智能主題股票遭拋售,美國芯片巨頭英偉達(NVIDIA)股價歷史性暴跌,納斯達克綜合指數大幅下跌。

1月27日,納斯達克綜合指數大幅下跌 圖源:紐約時報

1月27日,納斯達克綜合指數大幅下跌 圖源:紐約時報截至當天收盤,英偉達公司股價下跌16.97%,市值一日內蒸發近6000億美元,創美國歷史上任何一家公司的單日最大市值損失。

DeepSeek衝擊美股

英偉達的暴跌對整個市場造成了衝擊,博通公司股價下跌17%,超威半導體公司(AMD)股價下跌6%,微軟股價下跌2%。此外,人工智能領域的衍生品,如電力供應商也受到重創。美國聯合能源公司股價下跌21%,Vistra的股價下跌29%。

市場分析認為,此次美國股市震盪的核心原因是DeepSeek的最新突破,動搖了美國科技行業的地位。2024年底,DeepSeek發布了新一代大語言模型V3,並宣佈開源。測試結果顯示,該模型在多項評測中表現優於主流開源模型,且具有成本優勢。

本月,DeepSeek在世界經濟論壇2025年年會開幕當天發布了最新開源模型R1,再次引發全球關注。

據介紹,R1模型在技術上實現了重要突破——用純深度學習方法讓AI自發湧現出推理能力,在數學、代碼、自然語言推理等任務上,性能比肩OpenAI的o1模型正式版,且訓練成本僅為560萬美元,遠低於美國科技巨頭的數億美元乃至數十億美元投入。

市場分析師認為,DeepSeek的模型推出如同一顆「震撼彈」,令市場對美國科技行業的競爭力產生疑慮,導致人工智能主題股票遭拋售。

安內克斯理財公司首席經濟學家雅各布森表示,人們真正感到詫異的是,像英偉達這樣的公司,被認為幾乎壟斷了人工智能生態系統中的所有芯片,但也許「護城河」並不像人們想象的那麼強大,這可能是其股價下跌的原因。

目前,DeepSeek開發的移動應用程序已超越OpenAI的ChatGPT,登頂蘋果手機應用商店美國區免費應用排行榜。(此前報道)

DeepSeek:性能卓越,用戶體驗佳

DeepSeek是一款由國內人工智能公司研發的大型語言模型,擁有強大的自然語言處理能力,能夠理解並回答問題,還能輔助寫代碼、整理資料和解決複雜的數學問題。

與OpenAI開發的ChatGPT相比,DeepSeek不僅率先實現了媲美OpenAI-o1模型的效果,還大幅降低了推理模型的成本。其新模型DeepSeek-R1以十分之一的成本達到了GPT-o1級別的表現,引發海外AI圈的廣泛討論。

北京郵電大學人工智能學院人機交互與認知工程實驗室主任劉偉介紹,DeepSeek最大的優勢在於算法的改進和優化,節省了算力和數據量。以前如果說OpenAI是「大力出奇跡」,如今DeepSeek則是「小力也可以出奇跡」——小的算力用新的方法也能創造奇蹟。

DeepSeek R1 API價格,圖源:DeepSeek

DeepSeek R1 API價格,圖源:DeepSeek南京大學人工智能學院教授俞揚表示,DeepSeek在算法上進行了相應的優化,使得訓練成本大幅降低。

開源:未來的發展方向?

DeepSeek採用了完全開源策略,不僅降低了用戶的使用門檻,還促進了AI開發者社區的協作生態。通過開源,DeepSeek吸引了大量開發者和研究人員的關注,推動了AI技術的發展。英偉達AI科學家Jim Fan稱讚DeepSeek是「真正開放的前沿研究,賦能所有人」。

當然,開源也面臨着保護知識產權和開源社區秩序維護等挑戰。

俞揚表示,開源只是一種商業模式,即便開源項目也擁有版權。開源與閉源之爭,實質上是不同商業模式在特定場景和時代背景下的有效性對比。

DeepSeek的成功被一些人視為中國技術理想主義的體現,甚至被外國人比喻為神祕的東方力量。

但從整個AI大模型產業來看,DeepSeek的成功或許代表了一種全新的發展方向——通過算法優化而非單純依賴算力和數據量來提升模型性能。這一方向也為AI大模型產業的發展提供了新的思路。