新智元報道

【新智元導讀】o3-mini深夜降臨,OpenAI終於亮出了最新的底牌。在Reddit AMA問答中,奧特曼深刻懺悔在開源AI上,自己站錯了隊。他表示,內部正在考慮開源策略,繼續研發模型,但OpenAI領先優勢不會像以前那麼大了。

當所有人還在驚歎DeepSeek的驚人實力時,OpenAI終於坐不住了。

昨夜凌晨,o3-mini緊急上線,在數學代碼等基準測試中刷新SOTA,重回王座。

最關鍵的是,免費用戶也可以體驗!

o3-mini實力可不是吹的,在‘人類最後一次考試’中,o3-mini(high)直接在準確率和校準誤差(Calibration Error)均是最優。

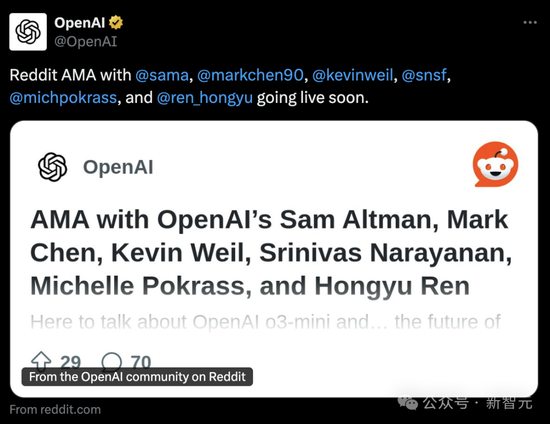

o3-mini上線幾小時後,OpenAI官方開啓了Reddit AMA大約1小時左右的在線問答。

奧特曼本人也上線,回答了網友們的一切問題。

主要精彩亮點有:

-

DeepSeek的確很優秀,我們也會繼續研發更好的模型,但領先優勢不會像以前那麼大了

-

比起幾年前,我現在更傾向於認為AI可能會出現快速突飛猛進

-

在開源權重AI模型這個問題上,我們站錯了隊

-

高級語音模式即將迎來更新,我們會直接稱它為GPT-5,而不是GPT-5o,目前還沒有具體的時間表。

除了奧特曼本人,首席研究官Mark Chen、首席產品官Kevin Weil、工程副總Srinivas Narayanan、API研究負責人Michelle Pokrass、研究負責人Hongyu Ren也一同在線,認真回答了網友們所有問題。

接下來,讓我們一起看看他們都說了什麼。

奧特曼深刻懺悔,在開源AI上站錯了隊

DeepSeek突然逆襲,或許是所有人都沒有想到的。

在AMA問答中,奧特曼本人也深深懺悔自己在開源AI上站錯了隊,不得不承認DeepSeek的強大優勢。

讓許多人驚歎不已的是,奧特曼竟然說出,OpenAI領先優勢不如以往。

以下所有,是我們匯總的奧特曼的經典回答。

Q:讓我們來談談本周的重大話題:Deepseek。顯然這是一個非常令人印象深刻的模型,我也知道它可能是在其他LLM的輸出基礎上訓練的。這會如何改變你們對未來模型的計劃?

奧特曼:它確實是一個非常好的模型!我們會開發出更好的模型,但我們不會像往年那樣保持那麼大的領先優勢了。

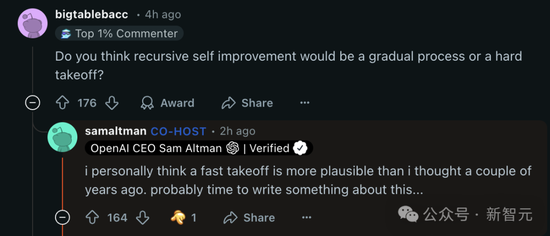

Q:你認為遞歸式自我改進會是一個漸進的過程,還是一個突然起飛的過程?

奧特曼:我個人認為,比起幾年前,我現在更傾向於認為AI可能會出現快速突飛猛進。可能是時候就這個話題寫點東西了...

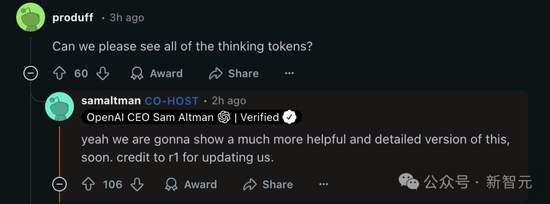

Q:我們能看到模型思考的所有token嗎?

奧特曼:是的,我們很快就會展示一個更有幫助、更詳細的版本。感謝R1提供的更新信息。

首席產品官Kevin Weil:我們正在努力展示比現在更多的內容——這將很快實現。至於是否展示所有內容還有待確定,展示所有思維鏈(CoT)會導致競爭對手的模型蒸餾,但我們也知道用戶(至少是高級用戶)想要看到這些,所以我們會找到一個合適的平衡點。

Q:滿血版o3什麼時候上線?

奧特曼:我估計會超過幾周,但不會超過幾個月。

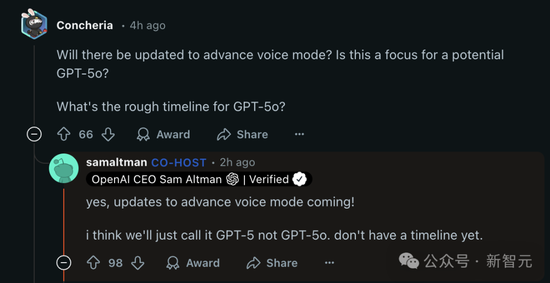

Q:語音模式會有更新嗎?這是否是潛在的GPT-5o關注的重點?GPT-5o的大致時間表是什麼?

奧特曼:是的,高級語音模式的更新即將到來!我想我們會直接稱它為GPT-5,而不是GPT-5o。目前還沒有具體的時間表。

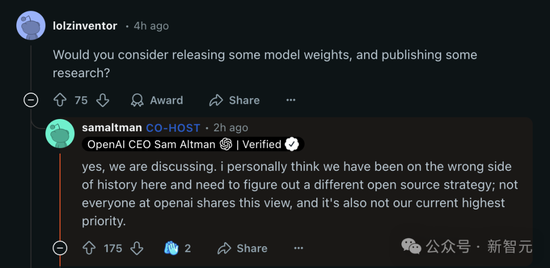

Q:你會考慮發布一些模型權重,並發表一些研究嗎?

奧特曼:是的,我們正在討論。我個人認為,在這個問題上我們站錯了隊,需要想出一個不同的開源策略;不是OpenAI的每個人都持有這種觀點,而且這也不是我們目前的最高優先級。

再來一個問題彈:

-

我們距離在常規Plus計劃中提供Operator還有多遠?

-

機器人部門的首要目標是什麼?

-

OpenAI如何看待更專業的芯片/TPU,比如Trillium、Cerebras等?OpenAI是否在關注這方面?

-

投資什麼來對沖AGI和ASI未來的風險?

-

你最難忘的假期是什麼?

奧特曼:

-

幾個月

-

先小規模生產一個真正優秀的機器人,從中學習經驗

-

GB200目前很難被超越!

-

一個好的選擇是提升自己的內在狀態——韌性、適應力、平靜、快樂等

-

很難選擇!但首先想到的兩個是:在東南亞揹包旅行或者非洲野生動物園之旅

Q:你是否計劃對Plus系列產品進行提價?

奧特曼:實際上我想逐漸減少。

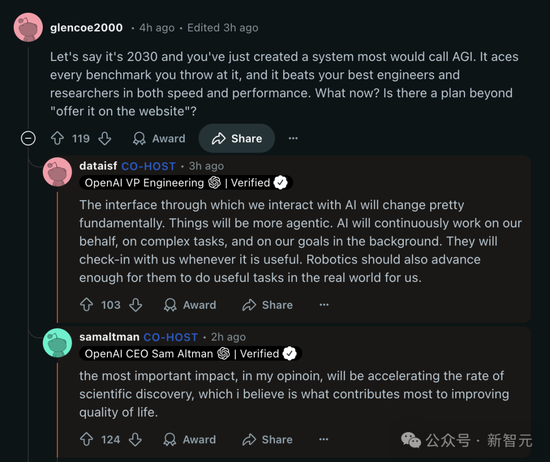

Q:假設現在是2030年,你們啱啱創造了一個大多數人會稱之為AGI的系統。它在所有測試基準上都表現出色,而且在速度和性能上都超過了你們最優秀的工程師和研究人員。接下來怎麼辦?除了‘把它放到網站上提供服務’之外,還有其他計劃嗎?

奧特曼:在我看來,最重要的影響將是加速科學發現的速度,我認為這是對提高生活質量貢獻最大的因素。

4o圖像生成,快來了

接下來,補充的是其他OpenAI成員的回應。

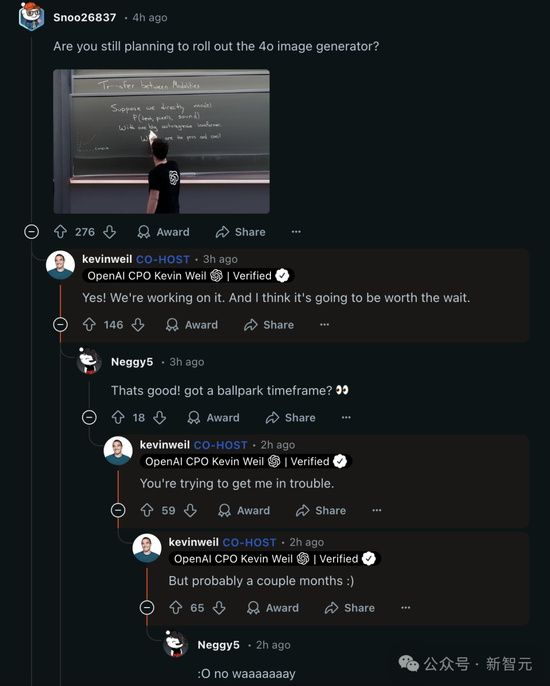

Q:你們還打算推出4o圖像生成器嗎?

首席產品官Kevin Weil:是的!我們正在努力。而且我認為等待是值得的。

Q:太好了!有大致的時間表嗎?

首席產品官Kevin Weil:你這是想讓我惹麻煩啊。可能幾個月吧。

還有一個類似的問題。

Q:我們什麼時候可以看到ChatGPT-5?

首席產品官Kevin Weil:就在o-17 micro和GPT-(π+1)之後不久。

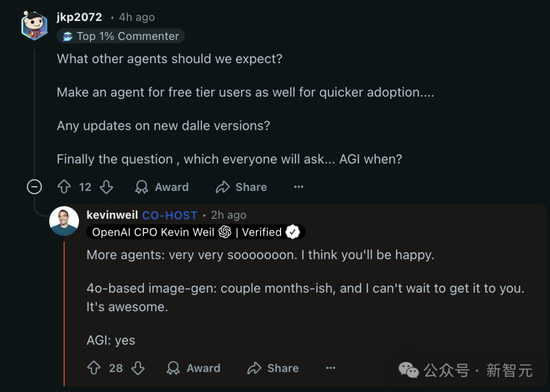

又是一個問題彈:

-

我們還可以期待什麼其他類型的智能體?

-

也為免費用戶提供一個智能體,這樣可以加快採用率...

-

關於新版DALL·E有什麼更新嗎?

-

最後一個問題,也是每個人都會問的...AGI什麼時候實現?

首席產品官Kevin Weil:

-

關於更多智能體:非常非常快就來了。我想你會滿意的。

-

基於4o的圖像生成:大約幾個月後,我迫不及待想讓你們用上。它很棒。

-

AGI:是的

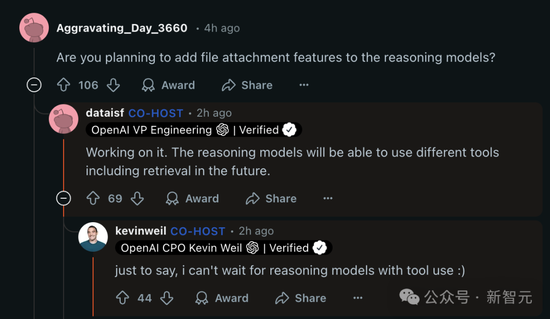

Q:你們是否計劃在推理模型中添加文件附件功能?

工程副總Srinivas Narayanan:正在開發中。未來推理模型將能夠使用不同的工具,包括檢索功能。

首席產品官Kevin Weil:只是想說,我迫不及待想看到能使用工具的推理模型了 :)

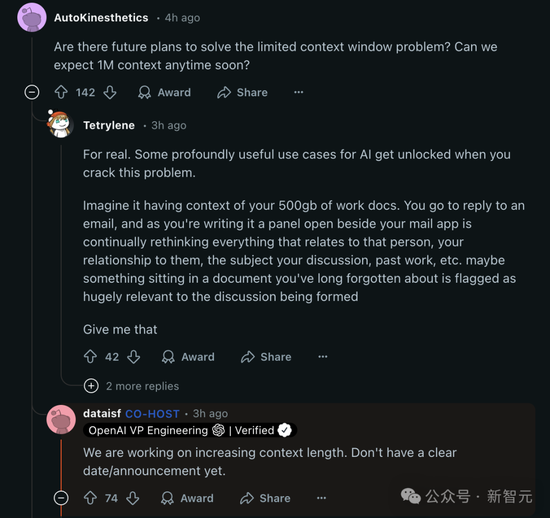

Q:真的。當你解決這個問題時,一些非常有用的AI應用場景就會被打開。想象一下,它能夠理解你500GB的工作文檔內容。

當你準備回覆一封郵件時,在你的郵件應用旁邊會打開一個面板,持續分析與這個人相關的所有信息,包括你們的關係、討論的主題、過去的工作等等。也許某個你早已遺忘的文檔中的內容會被標記出來,因為它與當前的討論非常相關。我太想要這個功能了。

工程副總Srinivas Narayanan:我們正在努力增加上下文長度。還沒有明確的日期/公告。

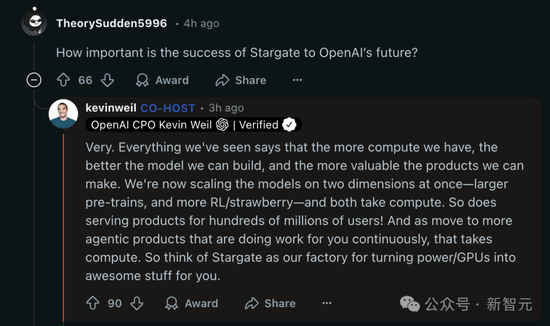

Q:‘星際之門’項目對於OpenAI未來來說,有多重要?

首席產品官Kevin Weil:非常重要。我們所看到的一切都表明,我們擁有的計算能力越多,就能構建越好的模型,也就能製造出越有價值的產品。

我們現在正在同時在兩個維度上擴展模型——更大規模的預訓練,以及更多的強化學習(RL)/‘草莓’訓練——這兩者都需要計算資源。

為數億用戶提供服務也需要計算資源!而且隨着我們轉向更多能持續為你工作的智能代理產品,這也需要計算資源。所以你可以把‘星際之門’看作是我們的工廠,將電力/GPU轉化為令人驚歎的產品的地方。

Q:在內部,你們現在用的是哪個模型?o4、o5還是o6?與o3相比,這些內部模型的智能程度提高了多少?

API研究負責人Michelle Pokrass:我們已經數不清了。

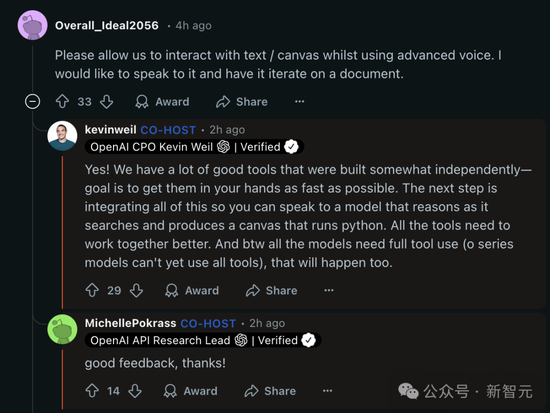

Q:請允許我們在使用高級語音功能的同時與文本/畫布進行交互。我希望能夠對着它說話,讓它對文檔進行迭代修改。

首席產品官Kevin Weil:是的!我們有很多不錯的工具是相對獨立開發的——目標是讓這些工具儘快交到你手中。

下一步是整合所有這些功能,這樣你就可以與一個模型對話,它在搜索的同時進行推理,並生成一個可以運行Python的畫布。所有工具都需要更好地協同工作。另外順便說一下,所有模型都需要完整的工具使用能力(o系列模型目前還不能使用所有工具),這個也會實現的。

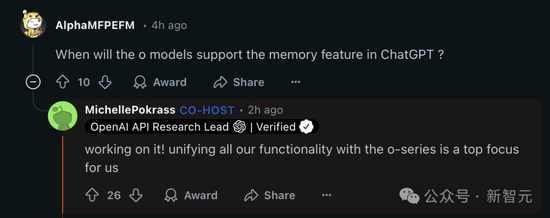

Q:o系列模型什麼時候會支持ChatGPT中的記憶功能?

API研究負責人Michelle Pokrass:正在開發中!將我們所有的功能與o系列模型統一起來是我們的首要任務。

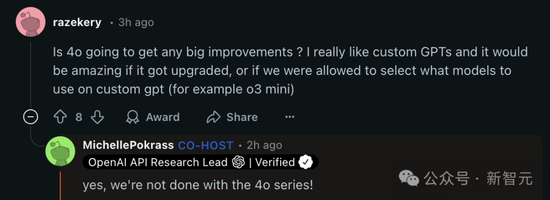

Q:4o是否會有重大改進?我真的很喜歡自定義GPT,如果它能夠升級就太棒了,或者如果我們能夠在自定義GPT中選擇使用什麼模型(比如o3 mini)就更好了。

API研究負責人Michelle Pokrass:是的,我們還沒有完成4o系列!

責任編輯:韋子蓉