中國聯通公衆號發文,日前,DeepSeek團隊宣佈將在「2月27日至3月3日」陸續開源5個代碼庫,這與中國聯通一直秉持的,開源普惠理念不謀而合。

DeepSeek官宣開源周,繼中國聯通於1月開源,元景「自適應慢思考」思維鏈大模型後,又針對DeepSeek系列模型進行了,「自適應慢思考」優化升級,平均可節省約30%的推理計算量,現已開源。

這也是目前業界首個對DeepSeek系列思維鏈模型做「自適應慢思考」優化升級的工作。

「以我為主,為我所用」的開放創新

元景思維鏈大模型具備多學科、多場景通用推理能力,且能在確保慢思考能力不打折的情況下,做到針對不同任務和難度的自適應慢思考,大幅降低了資源消耗,實現了大模型「慢思考」能力高性價比落地應用。

元景思維鏈大模型接入DeepSeek-R1並非簡單的「拿來主義」,而是「從其善,優其不善」,對DeepSeek-R1版本進行了調整,最大程度規避了其面對簡單問題「過度思考」的現象,使模型具備了「自適應」能力。

即在面向難度較高問題時使用慢思考模式生成長思維鏈,面向簡單問題時則傾向於生成簡潔的思維鏈,迅速準確的輸出相關答案。這樣避免了答案的冗餘、資源的浪費以及減少用戶等待時間,提升用戶體驗。

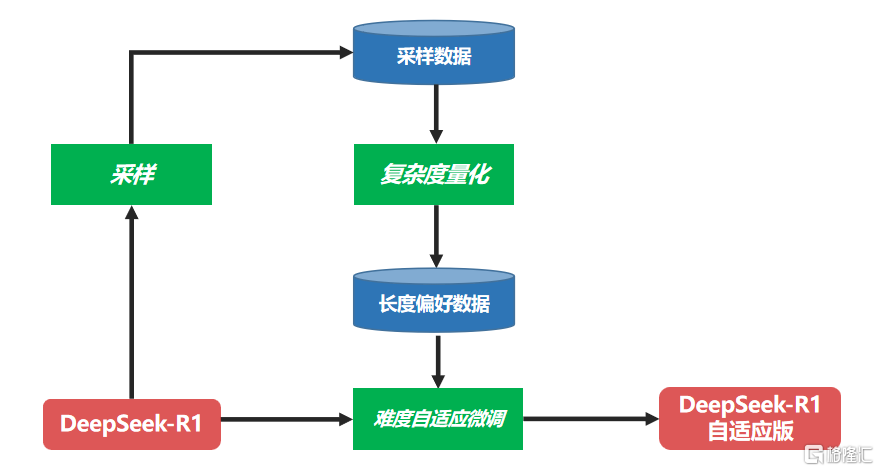

調整步驟完整分享

難度自適應微調:為實現模型推理的難度自適應,中國聯通利用DeepSeek-R1滿血版模型採樣生成數據,通過複雜度量化模塊構造長度偏好數據集,對於簡單問題從採樣答案中挑選長度較短的答案,對困難問題挑選長度較長的答案,使得答案長度與當前問題複雜度相匹配。

在此基礎上對DeepSeek-R1進行微調,使得微調後的模型具備對不同難度題目的自適應慢思考能力。具體改造流程如下圖所示。

自適應慢思考的DeepSeek-R1滿血版模型訓練流程圖

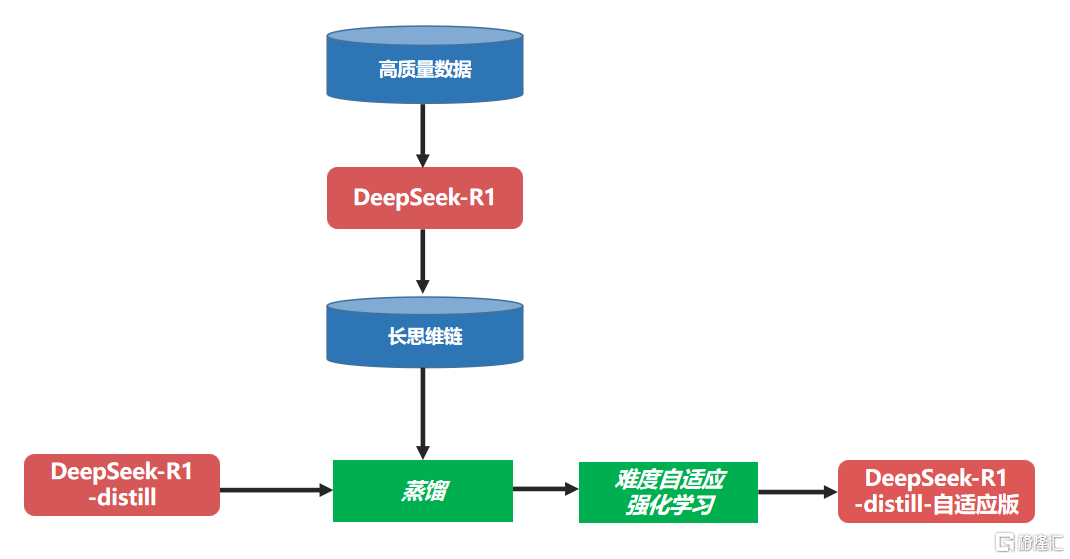

二次蒸餾:針對DeepSeek-R1的系列蒸餾模型,由於其使用的蒸餾數據來自訓練滿血版R1時使用的訓練數據,而非由性能更好的R1滿血版自身生成的數據,這會導致得到的蒸餾模型未能充分學習R1滿血版的能力,蒸餾效果大打折扣。

為解決這個問題,中國聯通使用了二次蒸餾的策略,即利用DeepSeek-R1滿血版將已積累的高質量數據轉化為包括深度思考過程的長思維鏈格式數據,在DeepSeek-R1蒸餾系列模型基礎上再進行一次微調,使模型具備更強的推理能力。

難度自適應強化學習:在對模型進行二次蒸餾後,中國聯通進一步借鑑DeepSeek-R1的構建思路,在GRPO算法基礎上提出了一種難度自適應強化學習算法DA-GRPO(Difficulty Adaptive GRPO),對二次蒸餾模型進行難度自適應的強化學習訓練,進一步提升其推理效果。除了使用傳統的基於規則的正確性獎勵、格式獎勵、語言一致性獎勵外,DA-GRPO還基於每個問題的複雜程度和生成答案的長度對獎勵得分進行校準。

具體而言,如果模型對一個簡單問題輸出較長的答案,則對獎勵分數進行相應的懲罰。同時,若模型對困難的問題輸出較長的答案,則給予其更高的獎勵分數,以鼓勵其進行更充分的思考。

這樣,通過提高樣本答案獎勵得分的區分度,使模型具備根據問題難度輸出相應長度答案的能力,在保證推理準確率的前提下顯著減少了答案冗餘和資源消耗,從而實現對不同難度問題的自適應慢思考。

自適應慢思考的DeepSeek-R1蒸餾版模型訓練流程圖

推理計算量節省約30%

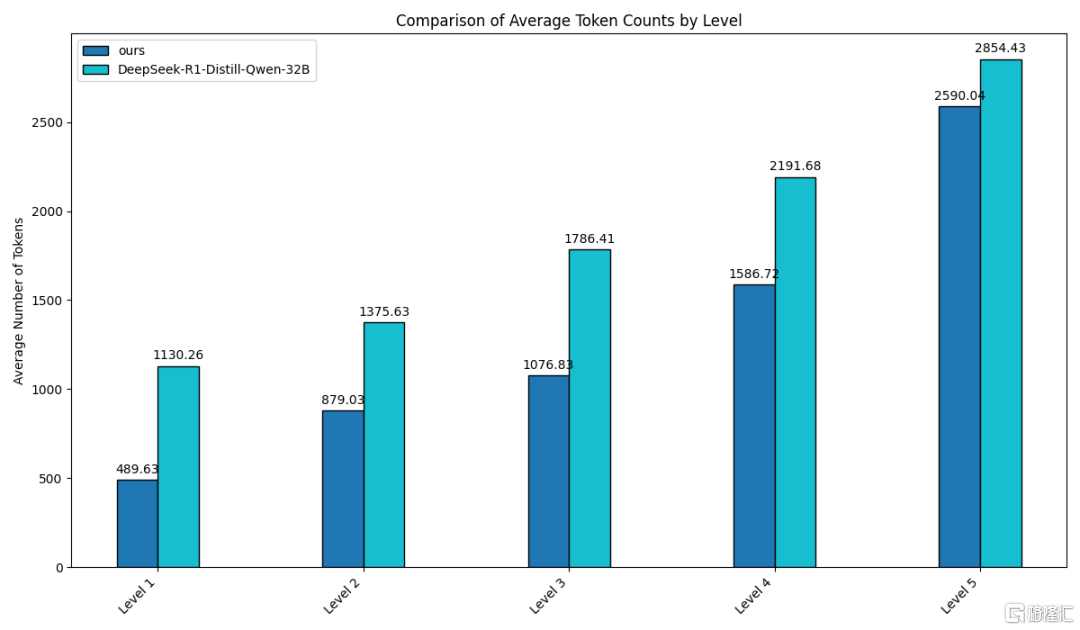

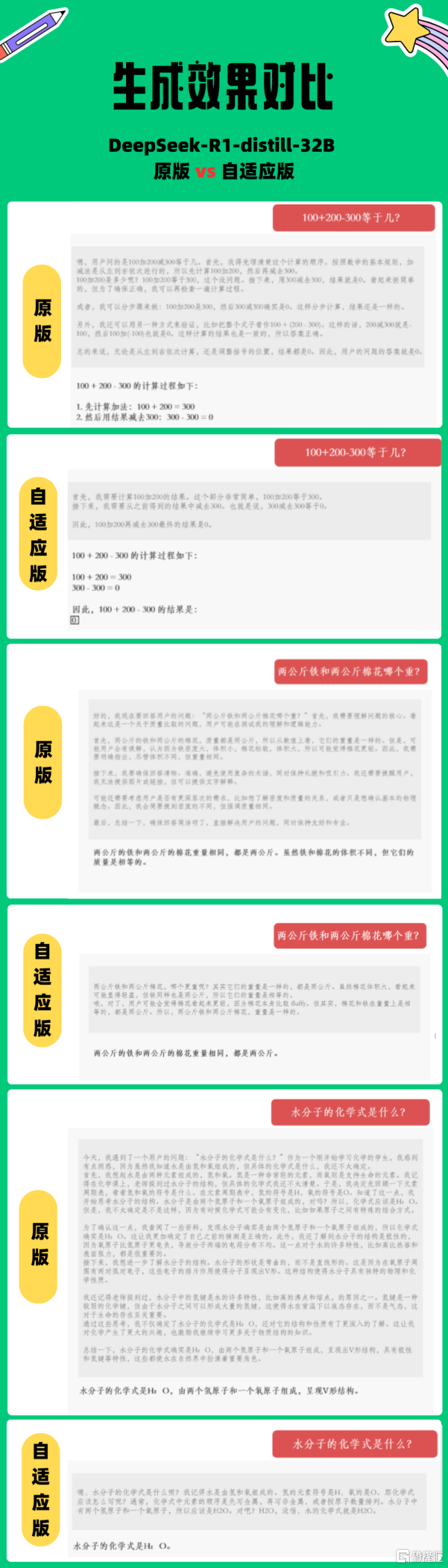

中國聯通以DeepSeek-R1-distill-32B模型為例,對上述方法的效果進行了驗證。

通過在數學任務測評集(MATH500)上對比以及具體實驗可以看到,經過難度自適應改造後的模型在不同難度等級問題上生成的回答長度較原版均明顯下降,並且對於最高難度(Level 5)輸出的回答長度降幅最大,體現了模型對不同難度等級問題具備自適應慢思考能力。

經過測評,這種創新的自適應慢思考方法,平均可節省約30%的推理計算量,冗餘輸出大幅減少,用戶體驗得到有效提升。

回答長度對比:原版DeepSeek-R1-distill-32B(淺藍)vs自適應版(深藍)

除了通過對DeepSeek-R1模型進行自適應慢思考優化升級外,中國聯通還在緊鑼密鼓推進對DeepSeek-R1系列模型的能力邊界量化和安全價值觀增強等相關工作的探索。

未來,中國聯通將持續與以DeepSeek為代表的先進開源模型深度融合,不斷升級元景基礎模型能力和MaaS平台功能,貫徹開源普惠理念,推進算力普惠、模型普惠、應用普惠,以先進數智水平賦能社會千行百業。

目前,自適應慢思考版的DeepSeek-R1-distill-32B已在GitHub、魔搭、始智等社區全面開源,地址如下:

GitHub:https://github.com/UnicomAI/Unichat-DeepSeek-R1-distill-32B

魔搭:https://www.modelscope.cn/UnicomAI/Unichat-DeepSeek-R1-distill-32B

始智:https://wisemodel.cn/models/UnicomAI/Unichat-DeepSeek-R1-distill-32B