突然宣佈!暫停DeepSeek API服務

專題:DeepSeek爲何能震動全球AI圈

【導讀】DeepSeek一天能賺多少錢?官方突然揭祕!潞晨科技暫停DeepSeek API服務

中國基金報記者 泰勒

大家好,一起關注一下關於DeepSeek的最新消息!

DeepSeek首次披露:理論成本利潤率545%

當市場以爲DeepSeek的開源周內容發佈完畢之後,3月1日,DeepSeek宣佈了“One More Thing”,突然揭祕V3/R1推理系統,公開了大規模部署成本和收益。

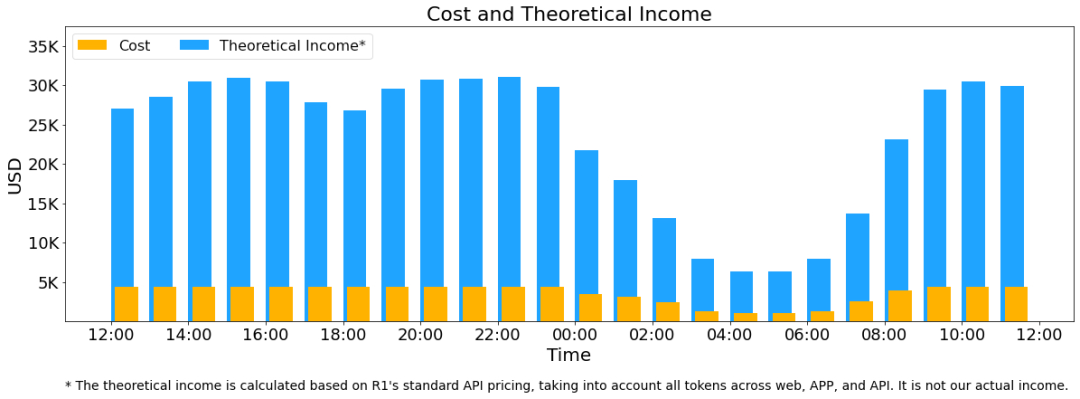

根據《DeepSeek-V3/R1推理系統概覽》的文章,假定GPU租賃成本爲2美元/小時,總成本爲87072美元/天;如果所有tokens全部按照DeepSeek R1的定價計算,理論上一天的總收入爲562027美元/天,成本利潤率爲545%。

據官方披露,DeepSeek-V3/R1推理系統的優化目標是:更大的吞吐,更低的延遲。

爲了實現這兩個目標,DeepSeek使用大規模跨節點專家並行(Expert Parallelism / EP)。首先EP使得batch size大大增加,從而提高GPU矩陣乘法的效率,提高吞吐。其次EP使得專家分散在不同的GPU上,每個 GPU 只需要計算很少的專家(因此更少的訪存需求),從而降低延遲。

但EP同時也增加了系統的複雜性。複雜性主要體現在兩個方面:

EP引入跨節點的傳輸。爲了優化吞吐,需要設計合適的計算流程使得傳輸和計算可以同步進行。

EP涉及多個節點,因此天然需要Data Parallelism(DP),不同的DP之間需要進行負載均衡。

因此,DeepSeek介紹瞭如何使用EP增大batch size,如何隱藏傳輸的耗時,如何進行負載均衡。

大規模跨節點專家並行(Expert Parallelism / EP)

由於DeepSeek-V3/R1的專家數量衆多,並且每層256個專家中僅激活其中8個。模型的高度稀疏性決定了必須採用很大的overall batch size,才能給每個專家提供足夠的expert batch size,從而實現更大的吞吐、更低的延時。需要大規模跨節點專家並行(Expert Parallelism / EP)。

採用多機多卡間的專家並行策略來達到以下目的:

Prefill:路由專家EP32、MLA和共享專家DP32,一個部署單元是4節點,32個冗餘路由專家,每張卡9個路由專家和1個共享專家。

Decode:路由專家EP144、MLA和共享專家DP144,一個部署單元是18 節點,32個冗餘路由專家,每張卡2個路由專家和1個共享專家。

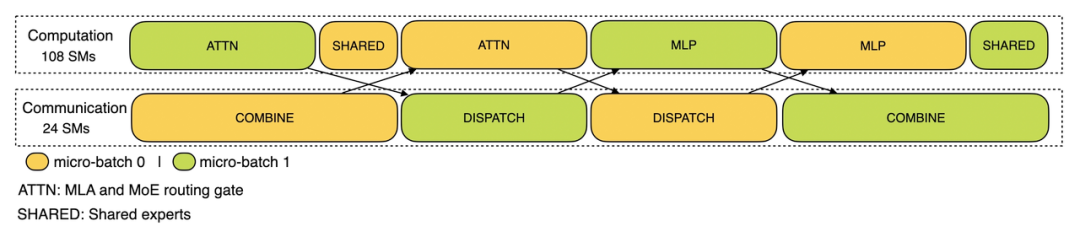

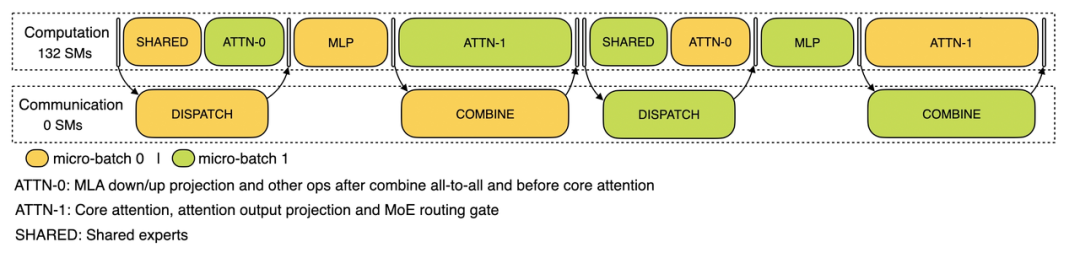

計算通信重疊

多機多卡的專家並行會引入比較大的通信開銷,所以使用了雙batch重疊來掩蓋通信開銷,提高整體吞吐。

對於prefill階段,兩個batch的計算和通信交錯進行,一個batch在進行計算的時候可以去掩蓋另一個batch的通信開銷;

對於decode階段,不同階段的執行時間有所差別,所以把attention部分拆成了兩個stage,共計5個stage的流水線來實現計算和通信的重疊。

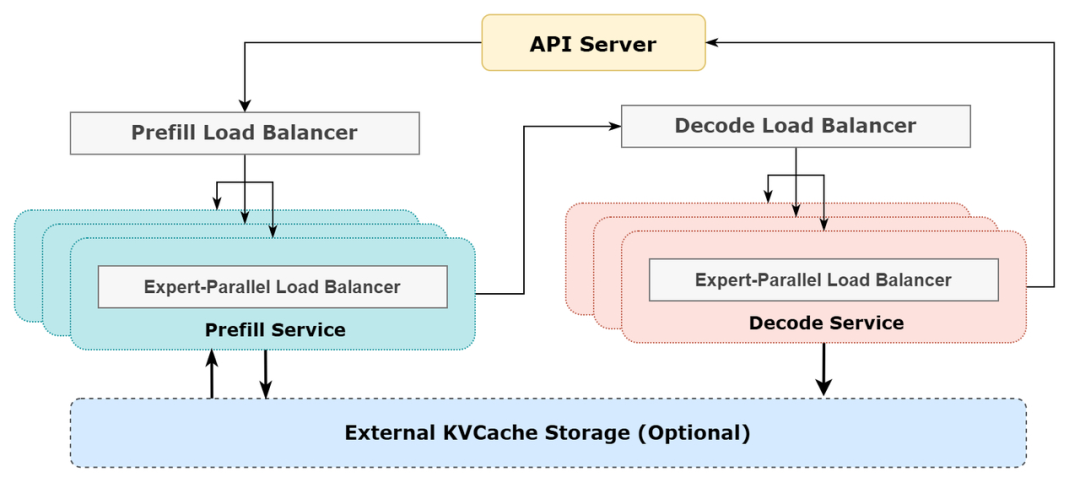

儘可能地負載均衡

由於採用了很大規模的並行(包括數據並行和專家並行),如果某個GPU的計算或通信負載過重,將成爲性能瓶頸,拖慢整個系統;同時其他GPU因爲等待而空轉,造成整體利用率下降。因此需要儘可能地爲每個GPU分配均衡的計算負載、通信負載。

-

PrefillLoadBalancer

-

核心問題:不同數據並行(DP)實例上的請求個數、長度不同,導致core-attention計算量、dispatch發送量也不同。

-

優化目標:各GPU的計算量儘量相同(core-attention計算負載均衡)、輸入的token數量也儘量相同(dispatch發送量負載均衡),避免部分GPU處理時間過長。

-

DecodeLoadBalancer

-

核心問題:不同數據並行(DP)實例上的請求數量、長度不同,導致core-attention計算量(與KVCache佔用量相關)、dispatch發送量不同。

-

優化目標:各GPU的KVCache佔用量儘量相同(core-attention計算負載均衡)、請求數量儘量相同(dispatch發送量負載均衡)。

-

Expert-ParallelLoadBalancer

-

核心問題:對於給定MoE模型,存在一些天然的高負載專家(expert),導致不同GPU的專家計算負載不均衡。

-

優化目標:每個GPU上的專家計算量均衡(即最小化所有GPU的dispatch接收量的最大值)。

線上系統的實際統計數據

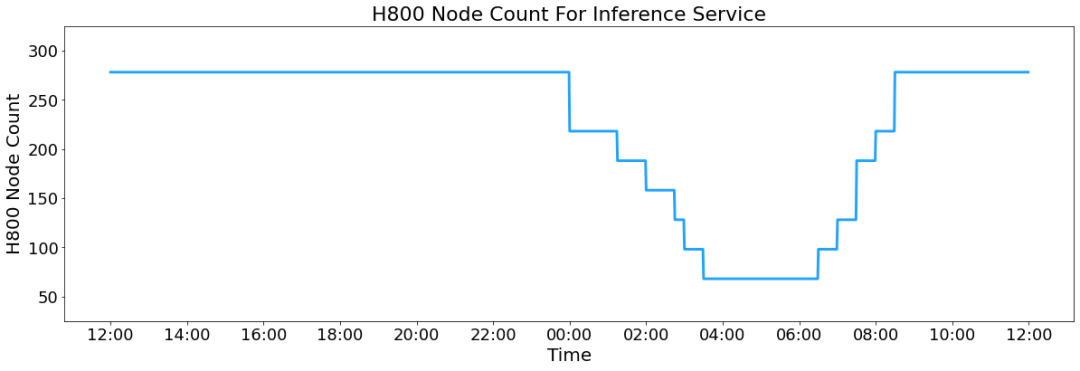

DeepSeekV3和R1的所有服務均使用H800GPU,使用和訓練一致的精度,即矩陣計算和dispatch傳輸採用和訓練一致的FP8格式,core-attention計算和combine傳輸採用和訓練一致的BF16,最大程度保證了服務效果。

另外,由於白天的服務負荷高,晚上的服務負荷低,因此實現了一套機制,在白天負荷高的時候,用所有節點部署推理服務。晚上負荷低的時候,減少推理節點,以用來做研究和訓練。在最近的24小時裏(北京時間2025/02/27 12:00至2025/02/28 12:00),DeepSeek-V3和R1推理服務佔用節點總和,峯值佔用爲278個節點,平均佔用226.75個節點(每個節點爲8個H800GPU)。假定GPU租賃成本爲2美金/小時,總成本爲87072美元/天。

在24小時統計時段內,DeepSeek-V3和R1:

輸入token總數爲608B,其中342Btokens(56.3%)命中KVCache硬盤緩存。

輸出token總數爲168B。平均輸出速率爲20~22tps,平均每輸出一個token的KVCache長度是4989。

平均每臺H800的吞吐量爲:對於prefill任務,輸入吞吐約73.7ktokens/s(含緩存命中);對於decode任務,輸出吞吐約14.8ktokens/s。

以上統計包括了網頁、APP和API的所有負載。如果所有tokens全部按照DeepSeek-R1的定價計算,理論上一天的總收入爲562027美元,成本利潤率爲545%。當然實際上沒有這麼多收入,因爲V3的定價更低,同時收費服務只佔了一部分,另外夜間還會有折扣。

有網友將DeepSeek與OpenAI進行對比,表示:“‘成本利潤率545%’,等一下,所以你是說我被OpenAI搶劫了?”

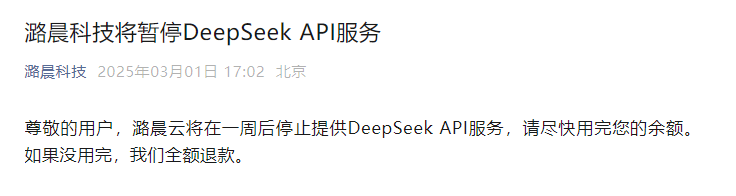

潞晨科技暫停DeepSeek API服務

就在DeepSeek披露大規模部署成本和收益之後,潞晨科技突然宣佈:“尊敬的用戶,潞晨雲將在一週後停止提供DeepSeek API服務,請儘快用完您的餘額。如果沒用完,我們全額退款。”

此前2月4日晚間,華爲計算微信公衆號發文表示,DeepSeek-R1系列模型的開源,因其出色的性能和低廉的開發成本,已引發全球的熱切討論和關注。潞晨科技攜手升騰,聯合發佈基於升騰算力的DeepSeek-R1系列推理API,及雲鏡像服務。

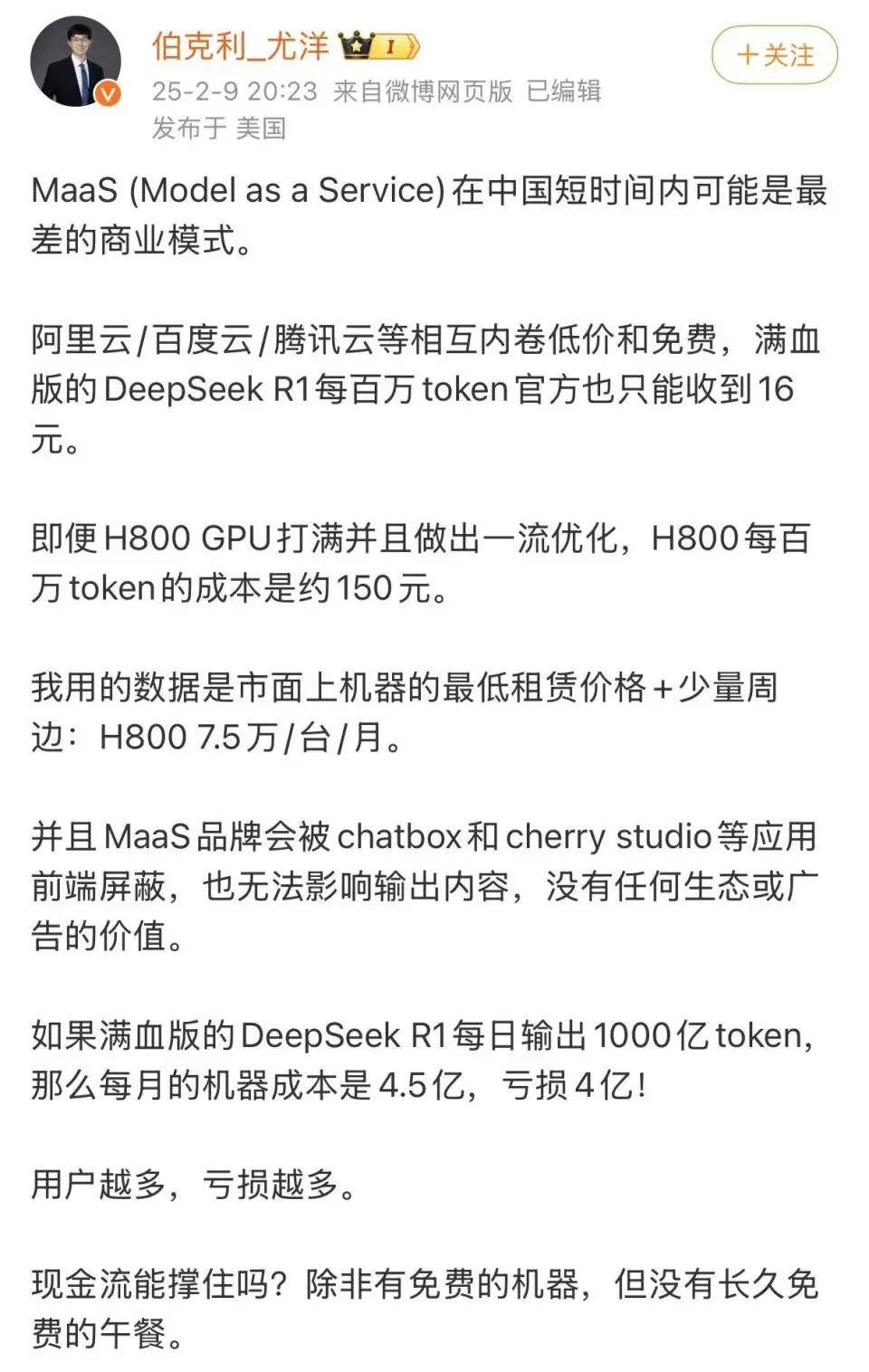

但近期潞晨科技CEO尤洋指出,滿血版DeepSeek-R1每百萬token(輸出)定價16元,如果每日輸出1000億token,一個月算下來接入方企業可獲得4800萬元收入。據他測算,完成1000億token的輸出,需要約4000臺搭載H800的機器,以目前H800的市價或者折舊來計算,每月僅機器成本就達4.5億元,因此企業方可能面臨每月4億元的虧損,“用戶越多,服務成本越高,虧損越多”。

3月1日下午4點,潞晨科技CEO尤洋發文回應DeepSeek公佈的理論成本利潤率。

公開資料顯示,潞晨科技是一家致力於“解放AI生產力”的全球性企業,團隊核心成員來自美國加州大學伯克利分校,斯坦福大學,清華大學,北京大學等國內外知名高校。主營業務包括分佈式軟件系統,大規模人工智能平臺,以及企業級雲計算解決方案。公司旨在打造一個開源低成本AI大模型開發系統Colossal-AI,作爲深度學習框架的內核,幫助企業最大化人工智能訓練效率的同時最小化人工智能的訓練成本。

校對:紀元

編輯:嘉穎

審覈:許聞

責任編輯:石秀珍 SF183

免責聲明:投資有風險,本文並非投資建議,以上內容不應被視為任何金融產品的購買或出售要約、建議或邀請,作者或其他用戶的任何相關討論、評論或帖子也不應被視為此類內容。本文僅供一般參考,不考慮您的個人投資目標、財務狀況或需求。TTM對信息的準確性和完整性不承擔任何責任或保證,投資者應自行研究並在投資前尋求專業建議。

熱議股票

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10