最近,AI領域的媒體頭條几乎被DeepSeek和Manus佔據,投資人和業內意見領袖忙着為這兩家公司勾畫「從芯片到終端」的上下游藍圖。而在大洋彼岸,另一場風暴正在醞釀——一家之前鮮少被中文媒體提及的新興公司,悄然在國際巨頭的夾縫中撕開一道口子。它既不做大模型,也不造機器人,甚至三個創始人都不是技術背景,然而這家公司在短短三年內讓微軟、OpenAI和英偉達同時成為自己的客戶、盟友與賭注。

這家公司名為CoreWeave。本月它正式向納斯達克遞交招股書,計劃募資40億美元,估值或超350億美元。而在此之前,其與OpenAI 簽訂了為期五年、價值 119 億美元的協議,根據該協議,CoreWeave 將為 OpenAI 提供人工智能基礎設施,成為後者逐漸擺脫微軟控制的關鍵一環。此外,CoreWeave手握超過25萬張英偉達的GPU,英偉達不僅是其核心供應商,更是其戰略股東之一。據CoreWeave招股說明書披露,2024年其營收達19.15億美元,按年激增736.6%,未履約合同金額高達151億美元。

如果成功上市,CoreWeave將成為首個以「顛覆者」身份挑戰傳統雲計算巨頭的GPU雲計算提供商,並自我定位為AI Hyperscaler(超大規模AI算力供應商)。

然而,高速增長的背後,是對英偉達GPU的高度依賴、被大客戶微軟的業績綁架,以及沉重的債務壓力。如今,AWS、Google、Microsoft等雲計算巨頭紛紛自研芯片,削弱對英偉達的依賴,而DeepSeek等低成本算力方案的崛起,正在重塑AI算力市場格局。在這樣的大環境下,CoreWeave能否藉助英偉達的優勢構建自己的AI算力帝國,還是會在市場競爭、客戶流失、供應鏈風險和債務重壓下轟然倒地?

這不僅關乎CoreWeave的未來,也將深刻影響全球AI算力市場乃至整個AI行業的走向。在微軟、OpenAI與英偉達越發複雜的三角關係中,CoreWeave究竟能否顛覆算力格局,實現逆襲,還是最終淪為大廠博弈和資本運作的犧牲品?

出身草莽從挖礦玩家到AI基建狂人

與光鮮的AI研發背景公司不同,CoreWeave的故事則充滿草莽色彩。前面提到CoreWeave的三個創始人Michael Intrator、Brian Venturo和Brannin McBee都不是技術出身,他們對什麼比較熟——金融,具體來說,大宗商品交易。衆所周知,比特幣的熱潮如同當年加州的淘金熱,掀起了全球範圍的逐利狂潮,2017年,比特幣從1000美元漲到接近20000美元。

CoreWeave「三兄弟」也是當年比特幣狂熱大軍中的一員。據Brian Venturo回憶,2016年他們購入了第一塊GPU,並在以太坊網絡上成功挖出第一個區塊,這一經歷讓他們踏入了區塊鏈挖礦領域。隨着挖礦業務的逐步發展,他們在2017年正式將這一副業轉型為公司運營,創立了Atlantic Crypto公司,兩年後將其改名為CoreWeave。

CoreWeave的三個創始人:Michael Intrator、Brian Venturo和Brannin McBee

來源:CoreWeave

彼時,以太坊等數字貨幣的挖礦市場處於高速增長期,GPU礦機需求旺盛,CoreWeave憑藉其大規模的GPU集羣積累了大量的計算資源,很快就發展成為以太坊一哥,擁有50000個GPU,佔據了以太坊網絡算力的1%以上。

然而,2018年的幣價崩盤讓無數礦場破產,也讓當時的CoreWeave收入暴跌七成,生死存亡之際,他們嗅到另一條生路——AI訓練所需的GPU與礦機硬件高度重合,還有娛樂和生命科學等幾個計算量要求比較大的領域可以做備選,當時的AI啱啱起步,算力爭奪並不激烈,這時候市場上堆積了大量破產礦工的GPU,收購這些GPU並不貴。

2019年,CoreWeave果斷砍掉挖礦業務,將其原本用於挖礦的GPU集羣重新配置,主要投向AI雲計算和高性能計算,並開始向企業客戶提供雲端算力租賃服務。這時候不得不提促成CoreWeave這次轉型的關鍵籌碼英偉達,後者正急於擴大CUDA生態的商業版圖,而CoreWeave承諾批量採購GPU並專注AI任務,雙方迅速結成同盟。

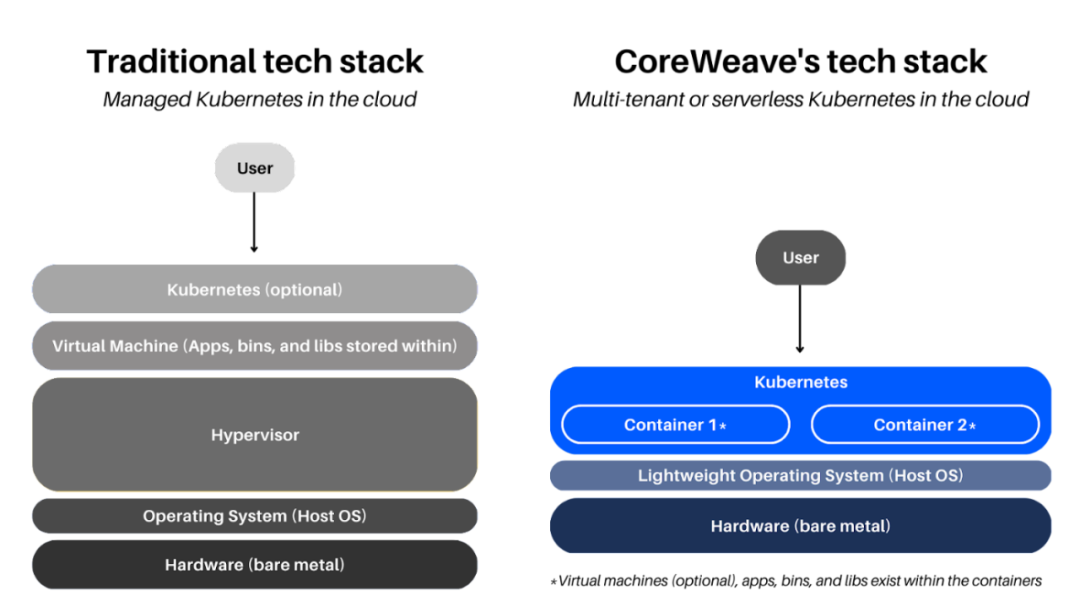

原本是「雪中送炭」的合作在ChatGPT爆發後迎來質變,2022年11月ChatGPT的橫空出世徹底改變了CoreWeave,也是英偉達的命運爆發。2023年起,全球AI實驗室陷入算力飢渴,而傳統雲廠商的通用服務器難以滿足需求——AWS的GPU實例需要多層虛擬化調度,性能損耗高達15%;Azure的自研芯片Maia尚在襁褓。對算力的需求一下將英偉達推到風口浪尖上,也包括CoreWeave,到處是要買他們服務的人。

CoreWeave順勢推出「裸金屬GPU(Bare Metal GPU)」服務,繞過虛擬化層,直接將物理GPU服務器租賃給客戶。相較傳統的雲端虛擬GPU實例,該模式不僅提供更強大的計算性能和更低的延遲,還賦予用戶對硬件資源的完整掌控。2023年,CoreWeave與英偉達建立深度合作關係,成為A100、H100等高端GPU的核心雲端供應商之一。

CoreWeave此時則研製出自己的殺手鐧,通過GPU集羣和自研軟件棧構建,優化AI訓練與推理效率,將英偉達GPU的算力利用率榨取到極致,2023年MLPerf基準測試顯示,CoreWeave聯合英偉達和Inflection AI,利用3,584塊H100,用時不到11分鐘就能訓練出GPT-3 175B模型,訓練速度領先第2名29倍。

傳統與CoreWeave 基礎設施比較

來源:CoreWeave官網

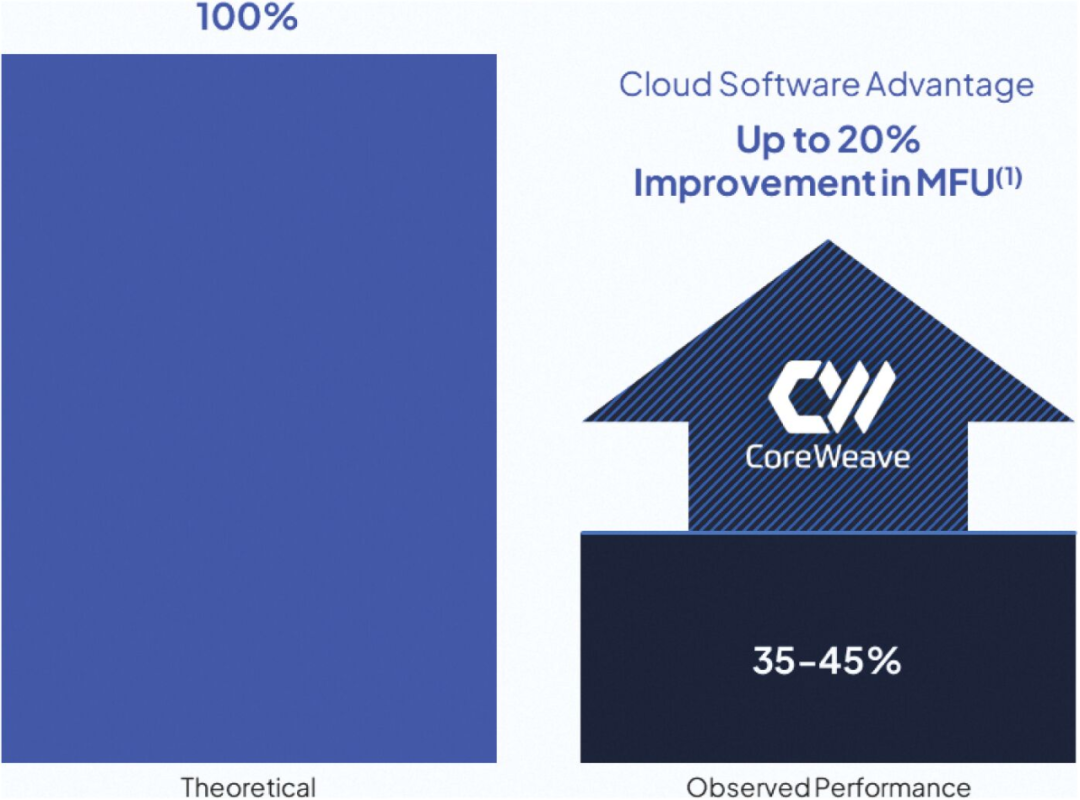

CoreWeave認為,運行AI工作負載的典型GPU的計算效率在峯值理論性能的35%到45%之間,這也是大部分雲計算大廠的平均水平,若能將效率缺口從約35%縮小至理論上的100%,將大幅釋放AI基礎設施的性能潛力,從而推動AI整體質量的蝶變。所以後來CoreWeave在技術上的一系列舉措,無論其自研的SUNK 協調系統還是 Tensorizer 優化工具,都圍繞着最大限度地提高客戶的 GPU 利用率進行,CoreWeave招股書表明,已經比大廠的GPU 利用率提升了20%。

來源:CoreWeave招股說明書

在商業模式上,CoreWeave則以「GPU即服務」(GPUaaS)模式或「人工智能即服務」(AIaaS)模式為核心,結合按需計費和預付款機制,為客戶提供靈活性與長期算力保障。前者客戶按小時或實例使用時長付費,適用於短期需求,後者收取客戶的15%-25%作為預付款,面對需要長期算力保障的大型用戶。

目前CoreWeave的大型客戶包括微軟(一家貢獻62%)、英偉達、Meta、IBM、Mistral和Cohere等,此外,CoreWeave的算力服務也逐步滲透到金融、製藥等高性能計算需求較高的行業。例如,華爾街量化交易公司Jane Street,以及多個生物製藥企業,均依賴CoreWeave的算力支持其模型訓練和數據分析。

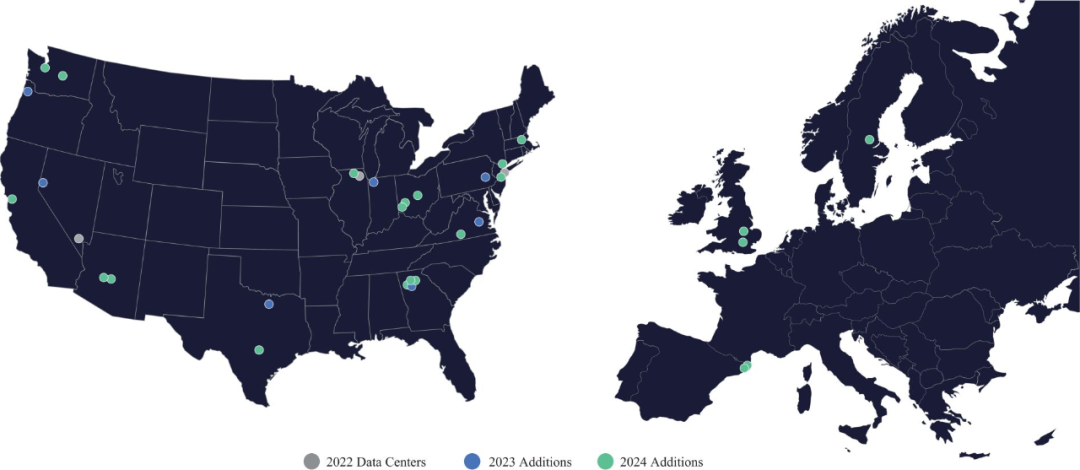

2024年,CoreWeave營收達到19.15億美元,按年增長736.6%,顯示出極強的市場需求。同年,CoreWeave運營的GPU數量超過25萬張,並管理着32座數據中心,覆蓋全球多個區域,以提供低延遲、高吞吐的算力支持。

在2025年,CoreWeave計劃進一步擴大數據中心網絡,新增10座數據中心,對於AI算力供應商而言,數據中心的擴張不僅代表着計算能力的提升,也直接影響客戶的服務質量和算力成本,隨着全球AI訓練任務的規模不斷增長,數據中心的算力密度成為企業競爭的關鍵要素。此外CoreWeave總簽約電力達1.3GW,將提供長期可持續的能源支持。

Coreweave從數字基礎設施提供商Core Scientific租用了16兆瓦的數據中心空間

來源:https://www.datacenterdynamics.com/en/news/coreweave-to-lease-16mw-of-data-center-space-from-cryptominer-core-scientific/

時勢造英雄從幕後角色被推向AI算力革命前線

CoreWeave從「悶聲發大財」到備受市場矚目,表面是一個新興GPU雲計算供應商的出圈案例,實質則折射出近半年來AI算力市場格局的動盪與變革。

過去十多年,雲計算市場由幾大巨頭主導,它們掌控全球大部分算力資源,並依託強大的基礎設施優勢建立競爭壁壘。AI興起後,這些巨頭與英偉達及大模型企業緊密合作,共同推動產業發展,使市場規模迅速擴大,企業市值也屢創新高。

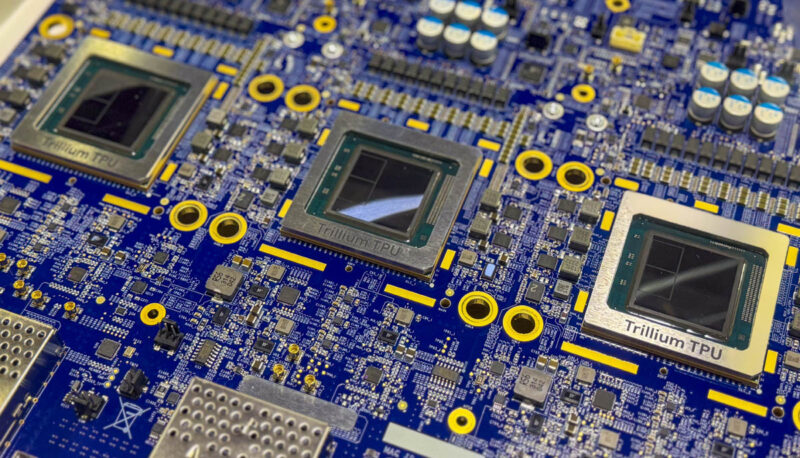

然而,隨着AI算力需求從爆發式增長轉向長期化,傳統雲廠商開始加速構建自有AI生態,削弱對英偉達的依賴。AWS推出Bedrock平台,並自研Inferentia和Trainium芯片;Google則從Gemini大模型到Trillium TPU芯片全面走向自研。該趨勢不僅挑戰了英偉達與頭部AI企業的原有生態關係,也讓算力市場的競爭進一步加劇。

Google Trillium TPU芯片:Google Cloud TPU V6e Trillium 3

來源:Servethehome,Google

微軟與OpenAI從緊密合作走向競爭的轉變更為典型。微軟持有OpenAI約49%的股權,並享有高達75%的利潤分成,原本在技術和資本層面深度綁定,關係看似穩固。然而,如今雙方正在逐步疏遠,並彼此加大防備力度。據報道,OpenAI拒絕向微軟透露核心技術,而微軟則在2024年啓動自研大模型項目「MAI」,並從著名獨角獸公司Inflection AI大規模挖角,包括聯合創始人Mustafa Suleyman,他隨後出任微軟AI總負責人,直接向微軟CEO彙報。

進入2025年,隨着特朗普上任啓動「星際之門計劃」(Stargate Project),OpenAI加速推動自身算力獨立化,比如與Oracle和Crusoe合作,在得克薩斯州阿比林市建設新的計算中心,預計到2030年,該項目或將滿足OpenAI 75%的算力需求。

位於得克薩斯州的阿比林數據中心

來源:Crusoe

CoreWeave正是利用這一點,將自己定位為「中立」的算力提供商,專注於基礎設施層面的GPU算力,既不傾向微軟,也不傾向於像OpenAI這樣的AI模型公司。理論上,它可以成為所有AI公司值得信賴的算力合作伙伴,而無需擔心被雲廠商兼競爭對手挖走市場。

這種中立性,讓CoreWeave可以「兩頭做生意」,一方面,它在去年與微軟達成了一份高達170億美元的長期合同,為其提供2023年至2030年的GPU服務器租賃服務;另一方面,今年CoreWeave又與OpenAI達成近119億美元的五年期合作協議,並計劃進一步入股。類似的大廠客戶還有Meta和Mistral,在競爭激烈的AI算力市場,CoreWeave反倒左右逢源起來。

我們知道,CoreWeave能夠快速崛起,更離不開與英偉達的深度合作。由於CoreWeave作為英偉達戰略上深度綁定的合作伙伴,包括約6%的股權,可以優先獲得最新的GPU資源,如Blackwell架構的GPU,不僅如此,雙方還在技術支持和資源整合方面進行深度協作,這種合作包括英偉達為CoreWeave提供定製版CUDA、專用優化芯片,甚至專屬的軟件堆棧,確保終端客戶能夠充分發揮每個GPU的最大效能。

衆所周知,英偉達的A100、H100 GPU是訓練大模型的關鍵硬件資源,至今仍面臨供不應求的問題,客戶往往需要等待很長時間。微軟CEO Satya Nadella就曾坦言,之所以使用CoreWeave的產品,實則是因為「來不及了」,需要「緊急獲取足夠的數據中心資源」。平心而論,租用服務確實要比購買硬件要划算得多,利用CoreWeave提供的雲基礎設施,可以比自行購買、部署和管理GPU更具成本效益,特別是應對短期或波動性需求。

值得一提的是,GPU雲服務提供商這個角色不只是CoreWeave獨有的,它的直接競爭對手Lambda Labs亦與英偉達保持密切合作關係,英偉達也投資了這家公司,另外像Cerebras Systems、Nebius Group、Vultr、Paperspace、Vast.ai等公司都是這個賽道的知名玩家。

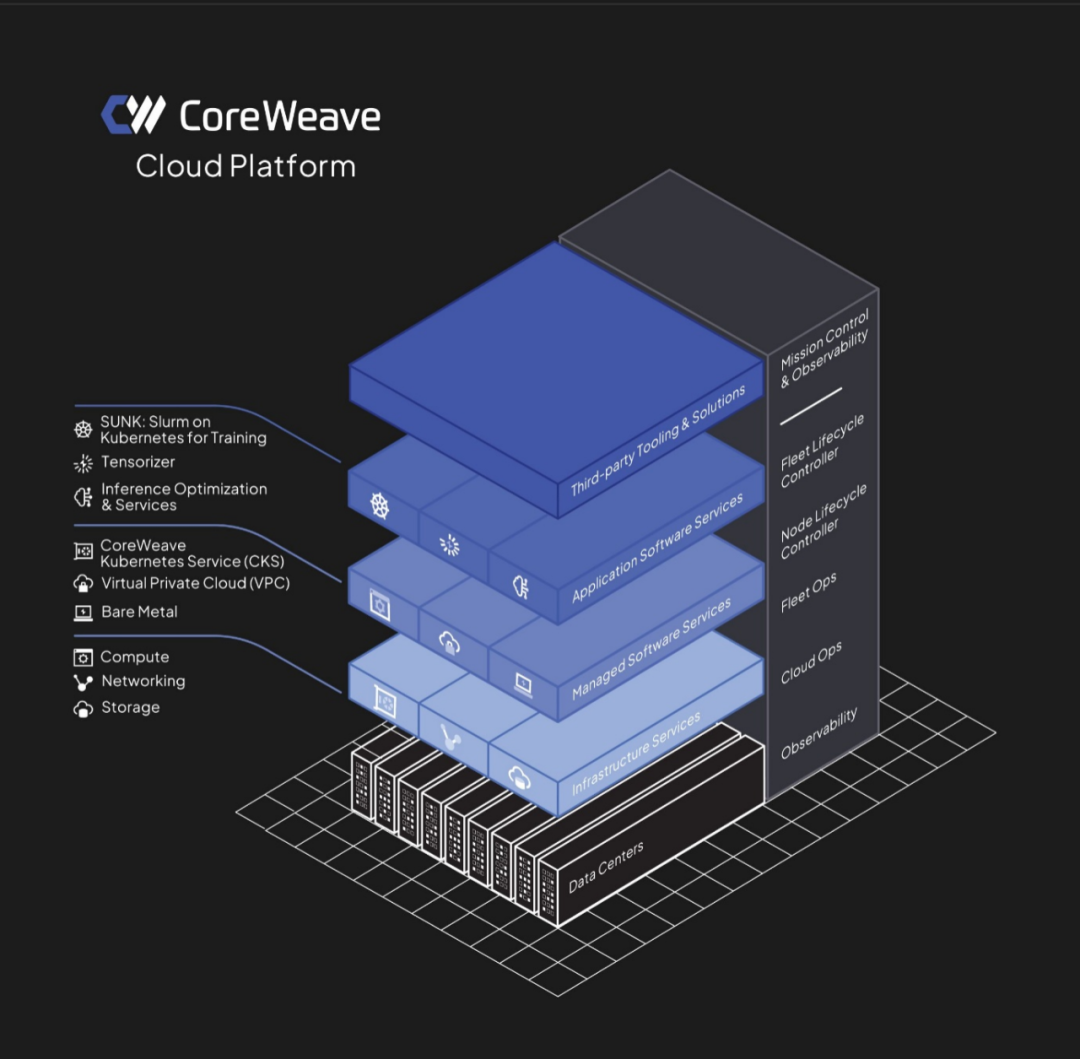

CoreWeave創始人Brannin將GPU雲服務比作一個精心編排的大型舞台表演。他強調,CoreWeave的雲平台遠非簡單地提供GPU訪問,而是一個複雜而精密的系統,這個系統就像一位經驗豐富的舞台導演,協調和管理着龐大的資源和設備網絡。

CoreWeave提供接入GPU服務完整的雲平台架構

來源:CoreWeave招股說明書

高歌猛進的背後被埋藏了多顆「不定時炸彈」

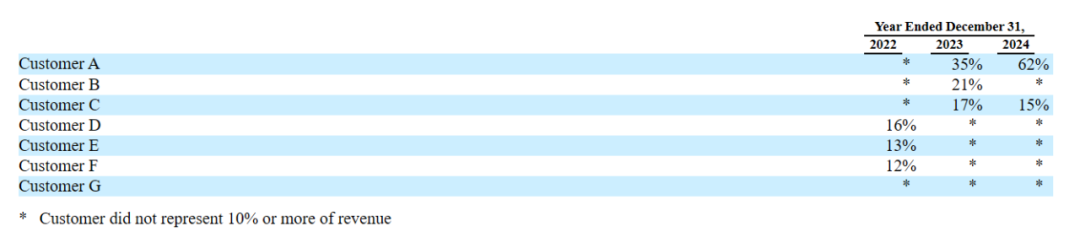

細心的讀者可能會發現,我們在講述CoreWeave上下游鏈條的時候,提到上游供應幾乎全部受到英偉達的影響,而下游賣給微軟的銷售則佔其總收入62%,還有一個它未提及名字的客戶,兩個客戶加起來佔總收入的77%,很明顯,依賴性非常強。

2022-2024年CoreWeave收入佔比超過10%的主要客戶列表

來源:CoreWeave招股說明書

讓所有人擔心的事還是發生了。就在CoreWeave向SEC遞交s1文件(招股書)的同一時間,CoreWeave最大客戶微軟,已撤回部分合作承諾。據英國《金融時報》3月6日報道,由於交貨問題和錯過最後期限,微軟已撤回了(withdraw)部分協議,「這些問題影響了微軟對CoreWeave的信心。」

知情人士最近則表示,微軟將選擇不行使近120億美元的選擇權,拒絕從CoreWeave那裏購買更多的數據中心容量,此舉為CoreWeave順利上市蒙上了一層陰影。客觀說,CoreWeave交貨問題並非僅僅是它自己控制供應鏈不佳造成的,今年10月,英偉達創始人兼首席執行官黃仁勳承認,其Blackwell芯片存在「設計缺陷」,導致延遲向客戶發貨。

另據《金融時報》報道,這與微軟今年的戰略調整有關。Satya Nadella最近表示,微軟人工智能基礎設施存在「過度建設(overbuild)」。我們看到CoreWeave與OpenAI簽訂了119億美元的協議,如果微軟過去是給OpenAI下單,而現在OpenAI直接進貨,微軟本身的MAI實際不需要那麼多算力,況且微軟現在本身還是OpenAI的股東,意味着OpenAI的採購也會影響到資本回報,這可能就是Satya Nadella所說的「過度建設」,也就是重複下單。

我們再回過來看CoreWeave,一旦影響到營收佔比62%-77%的大客戶變動,都會對CoreWeave構成重大沖擊。CoreWeave已與英偉達達成明確的採購協議,當前庫存已超25萬張GPU,並計劃今年進一步擴充。如果大客戶出現風吹草動,而其他客戶的租賃需求無法填補這一缺口,那麼這些高端GPU將面臨與傳統商品相同的困境——庫存積壓,進而影響資金迴流與運營效率。

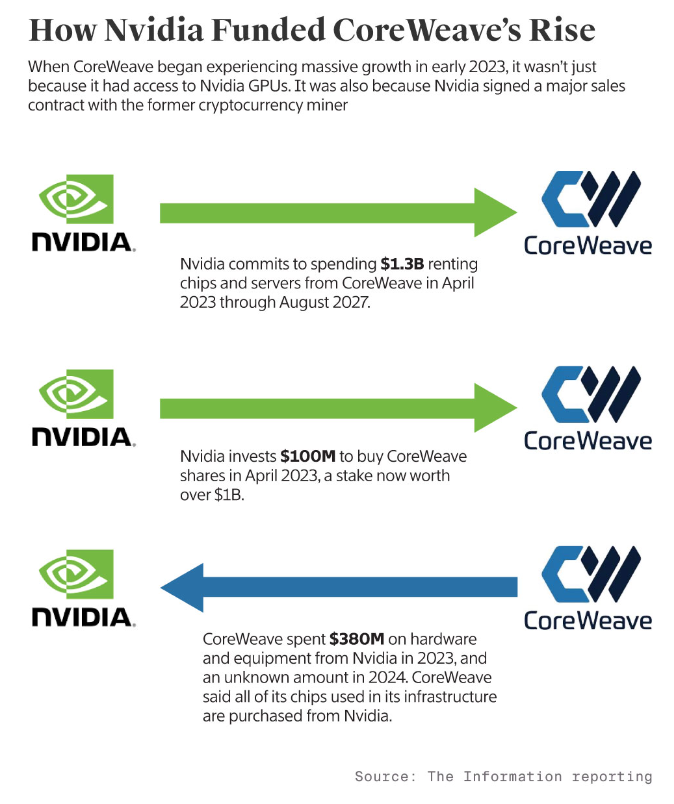

這裏蘊藏着更嚴重的危機在於,CoreWeave的GPU儲備、基礎設施包括數據中心建設所需的資金大部分都來自借貸。據美國科技媒體information報道,在招股說明書中沒有顯名的第二大客戶正是英偉達,去年貢獻了15%的營收,約合2.87億美元。

目前英偉達與CoreWeave正在進行代號為「魚鷹計劃」的合作,2023年初,英偉達向CoreWeave股權投資1億美元,並承諾在四年內向CoreWeave支付13億美元,租回自己生產的芯片,那麼2.87億美元收入可以算這13億美元的一部分,而CoreWeave在2023年當年就花費了3.8億美元來購置英偉達的硬件和設備,換句話說,單就這筆交易而言,CoreWeave顯然是買虧了,2024年之後雖沒有公開信息,我們推測只多不少,那麼CoreWeave在這方面的綜合成本很可能大於收入。我們不禁要問,CoreWeave為什麼要和英偉達繞這麼大一圈卻做虧本買賣?

英偉達是怎麼投資CoreWeave增長的,來源:The Information

說到底,英偉達以至微軟、OpenAI最終還是會買單的,也許它們認為巨大的資金成本和不確定性結果,短期很難向股東交代,而是讓CoreWeave這樣深度綁定的合作伙伴先衝在前面。

我們看到,要實現CoreWeave規劃的核心競爭力,需要巨大的重資產投入。據公開媒體報道,CoreWeave在數據中心承諾做出很多投資計劃,如它計劃投資超過10億美元,將美國新澤西的一座實驗室大樓改造成數據中心;與Blue Owl、Chirisa和PowerHouse合作的50億美元項目的一部分;承諾在英國的數據中心投資超過10億英鎊;承諾在歐洲的數據中心再投資22億美元;承諾在美國弗吉尼亞州投資6億美元的數據中心項目等等。

CoreWeave全球數據中心網絡,來源:CoreWeave招股說明書

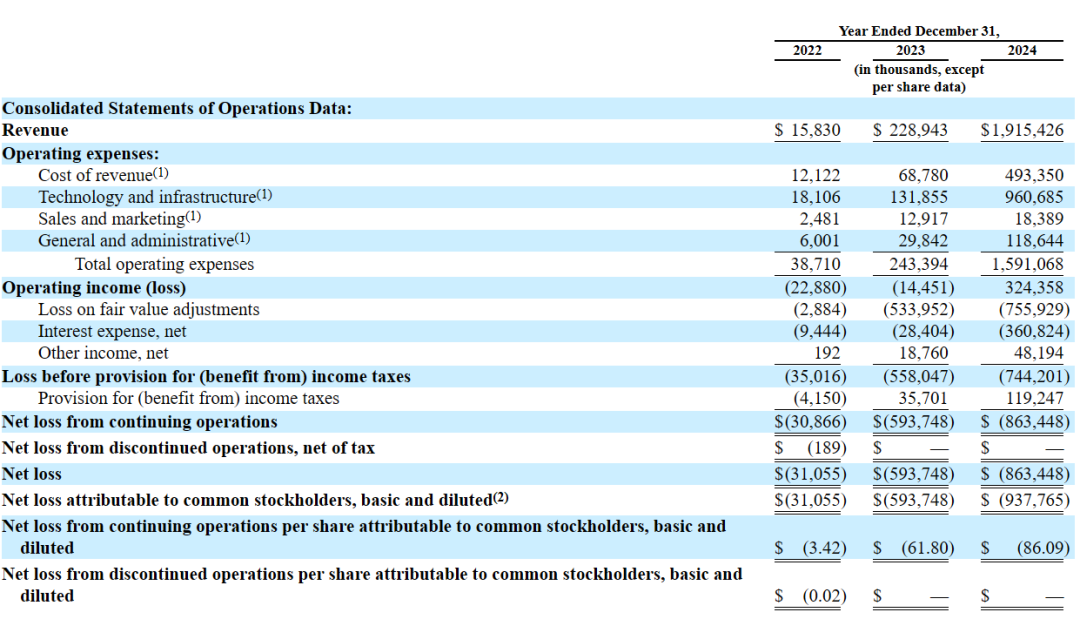

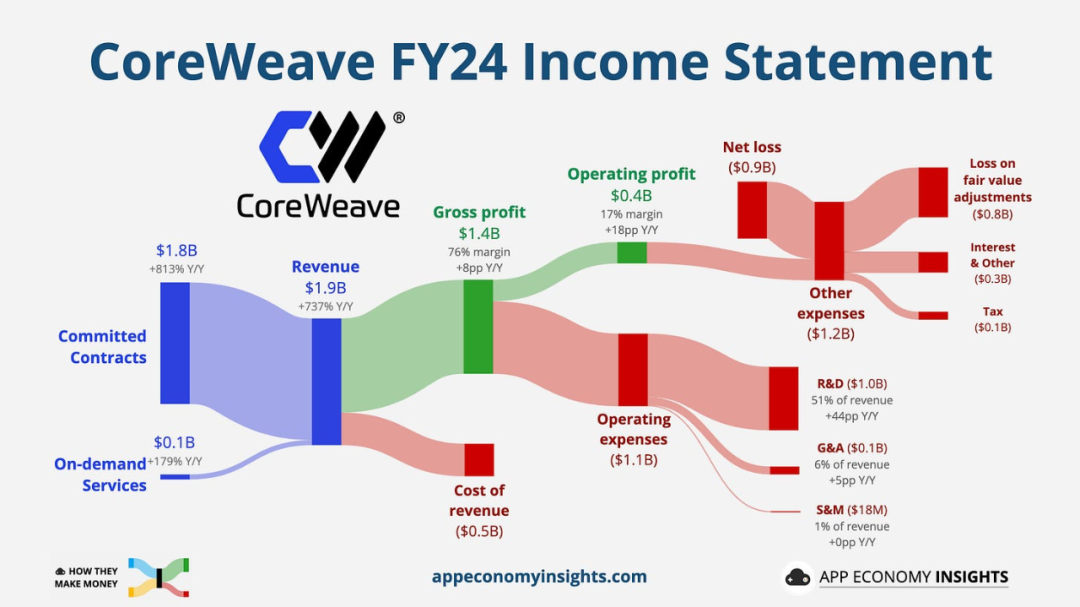

且不說這樣佈局是否合理,CoreWeave重資產投入從哪裏來?我們從損益表可以看出,2024年營收約為19.15億美元,運營成本(Operating expenses)則高達15.9億美元,收入增長736.36%的背後,成本也增長了654%,最後導致去年淨虧損(Net loss)8.63億美元。

來源:CoreWeave招股說明書

Coreweave2024財年收入情況

來源:App Economy Insight

CoreWeave招股說明書表明,2024年其已簽約1.3千兆瓦(GW)的運算容量,並轉化為大約360兆瓦的運算能力。據美國科技媒體下一代平台(The Next Platform)主編Timothy Prickett Morgan估算,CoreWeave中GPU的估計價值約為75億美元,將這些GPU轉化為系統需要大約150億美元的資本支出。

隨着GPU數量的持續增長,並承諾達到簽約的總計算能力,150億美元只是當前的資本支出,並未涵蓋未來幾年可能持續攀升的成本。這意味着,CoreWeave每年仍需不斷追加投資,以滿足算力擴張需求並履行長期承諾。

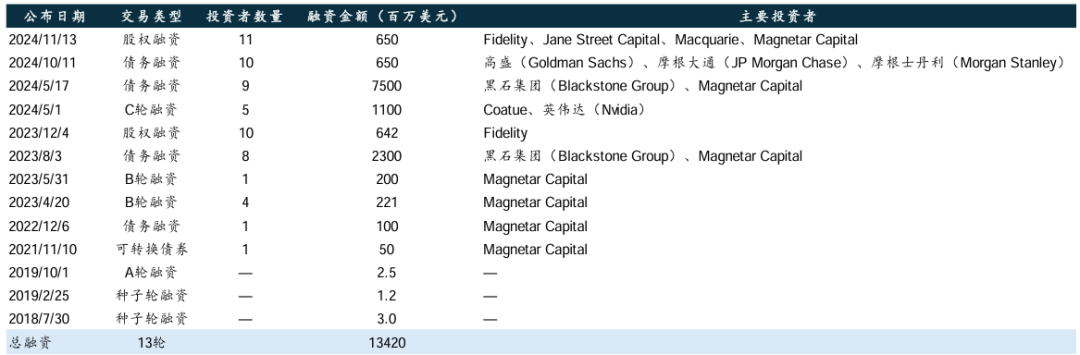

而這150億美元恰好與CoreWeave歷次孖展總金額145億美元基本能夠對應,CoreWeave招股說明書表示,「我們通過12輪股權和債權孖展籌集了145億美元」,實際上這145億美元大部分都是債權孖展,CoreWeave將其整合進入兩個DDTL(遞延稅項貸款,Delayed Draw Term Loan facilities),我們分別來看:

DDTL1.0主要來自私密股權資產管理公司黑石集團和對沖基金Magnetar Capital在2023年的借貸,總共23億美元,2023和2024年平均年利率分別為14.12%、14.11%,再加上其它成本,根據科技博主Edward Zitron的推測,每年至少支付8.92億美元的利息,預計到2028年3月還完。

很快又來了DDTL2.0,這次是在2024年,由黑石和Magnetar Capital牽頭,完成了76億美元的貸款,後面高盛(Goldman Sachs)、摩根大通(JP Morgan Chase)和摩根斯坦利(Morgan Stanley)等頂級投行也有參與,又借出了6.5億,作為DDTL的補充,總共達到82.5億美元的債務。DDTL2.0的年利率稍低一些,為10.53%,根據Edward Zitron的推測,每年則至少支付7.6億美元的利息。

我們將這兩個債務相加,每年至少要有16.52億美元用於還債,去年的總收入不過19.15億美元。比較殘酷的是,這幾家投行之所以把利率訂到那麼高,或許他們並不指望CoreWeave能夠還到2028年或者更久,而是以更快速度在AI算力爆發之際收回一部分本金。

CoreWeave孖展歷史(不完全統計)

來源:華泰證券、CoreWeave招股書、Crunchbase

而英偉達並沒有參與到發債的陣營中,它應該有過類似的計算,比較有意思的是,在2023年DDTL1.0的時候,英偉達曾提出用H100 GPU作為借貸的抵押品,因為在當時GPU是硬通貨,獲得較高的市場價值。然而今天英偉達H100 GPU的價格從2023年的8美元/小時一路下跌,最低到1美元/小時,摩爾定律仍然起作用。

然而,CoreWeave借貸是真金白銀,並沒有摩爾定律,除非聯儲局降息。

這還沒有提及DeepSeek。上個月被世人有更多了解的DeepSeek通過算法創新和工程優化顯著降低了大模型的算力成本,其核心技術包括混合專家(MoE)架構、定製化AI芯片設計(如稀疏計算單元和高帶寬內存架構)、FP8混合精度計算、稀疏化技術以及數據蒸餾等,有效減少了訓練和推理所需的計算資源,同時優化了模型效率。

我們看到,DeepSeek的低算力成本模式可能進一步削弱CoreWeave的市場競爭力。目前,在英偉達與CoreWeave體系下,無論是OpenAI、Mistral等大客戶,還是中小客戶,主要仍依賴GPU雲供應商以高價租賃英偉達的算力服務。若DeepSeek的低成本方案進一步普及,可能促使全球中小客戶轉向DeepSeek主導的開源生態,又佔據CoreWeave的一部分市場發展空間,迫使其調整定價策略或拓展增值服務,以維持競爭力,如此則進一步推高成本或減少收入。

若行業轉向輕量化AI架構,將引發GPU估值重估—抵押品減值—孖展能力下降的連鎖反應,直接衝擊微軟、Meta等依賴英偉達GPU算力的企業,除非它們能及時調整方向,而CoreWeave這類高度依賴GPU的公司則更難找到生存空間。

一旦危機爆發,龐大的債務積壓與產業連鎖反應,或將導致估值數百億美元的CoreWeave轟然倒塌,並波及整個上下游生態。因此,CoreWeave如今的賭注在於,既然自己已深度捆綁大廠生態,現實大廠也會豪賭其未來,後者的資產畢竟比幾十億負債的規模要大得多——這裏不是Web3的世界。

CoreWeave能否從「魷魚遊戲」中全身而退?

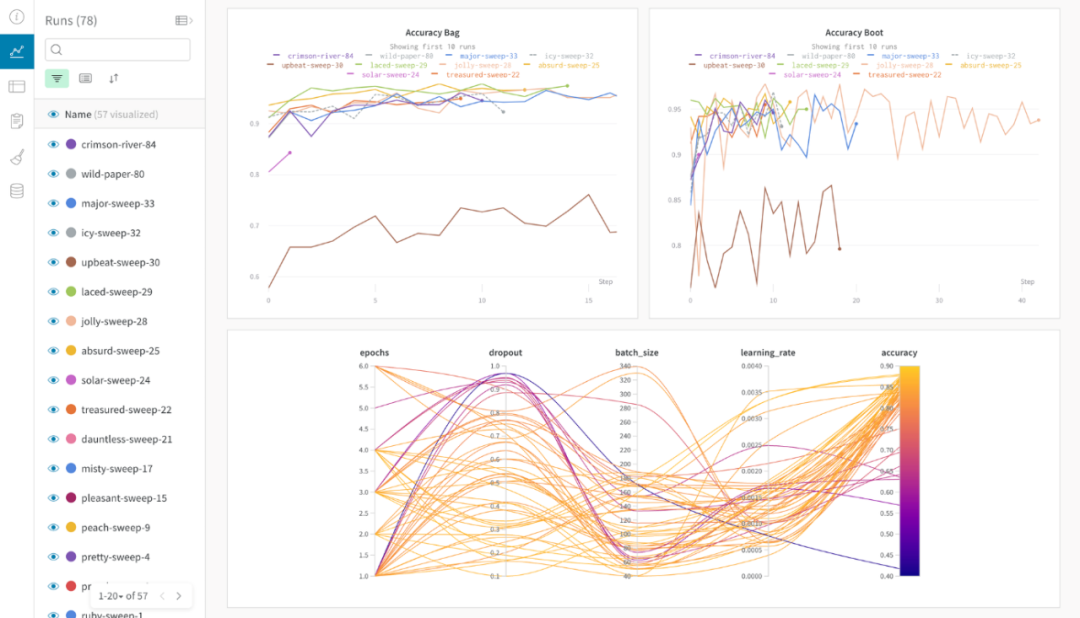

2025年3月4日,在上市前敏感時期以及資金緊張情況下,CoreWeave仍擬斥資17億美元收購AI開發平台Weights & Biases(W&B)。

W&B成立於2018年,專注於 MLOps 和 LLMOps,為 AI 模型的構建、訓練和部署提供工具支持。核心產品是一整套AI模型開發與管理工具,幫助科研人員和工程師更高效地進行模型訓練、監控性能,並優化工作流程。

我們看到,一方面,這筆交易有助於CoreWeave整合自身的硬件優勢與W&B的軟件能力,從單一的GPU供應商轉型為全棧式AI雲平台提供商,超越單純的GPU雲服務;另一方面,CoreWeave即刻獲得接觸W&B龐大的百萬級AI工程師用戶生態系統的機會,在市場上產生更強的影響力和更正面的評價,兩方面都可能給CoreWeave帶來更多的想象空間。

W&B For TWIML Listeners

來源:Weights & Biases(W&B)網站

目前CoreWeave的未來,仍掌握在自己手中,未來既取決於自己,也取決於整個AI算力市場的持續演變。未來,無論是英偉達與大廠的競爭格局,以DeepSeek為代表的輕量化AI的攻城略池,CoreWeave自身成本壓力的加劇、GPU價格的驟降,以及資本市場的信心波動,都可能讓這場豪賭變得極端危險。在AI算力演進的新時代,CoreWeave能否成功從生存遊戲中突圍,還是成為科技變革的犧牲品,或許很快就會有答案。