Sam Altman親自發文:GPT-2之後首次開源,開發者狂歡倒計時

劃重點:

1️⃣ OpenAI宣佈將發布開源大模型(open-weight),這是自GPT-2後首次開源

2️⃣ 新模型主打強推理能力,Sam Altman直言「要讓它變得非常、非常優秀」

3️⃣ 開發者可提前參與反饋,舊金山、歐洲、亞太線下活動即將啓動

4️⃣ 安全是核心:已啓動對抗性微調等專項測試,絕不發布高風險模型

OpenAI CEO Sam Altman啱啱發文扔出一枚「核彈」:「我們計劃在未來幾個月內發布一款強大的開源大模型」。

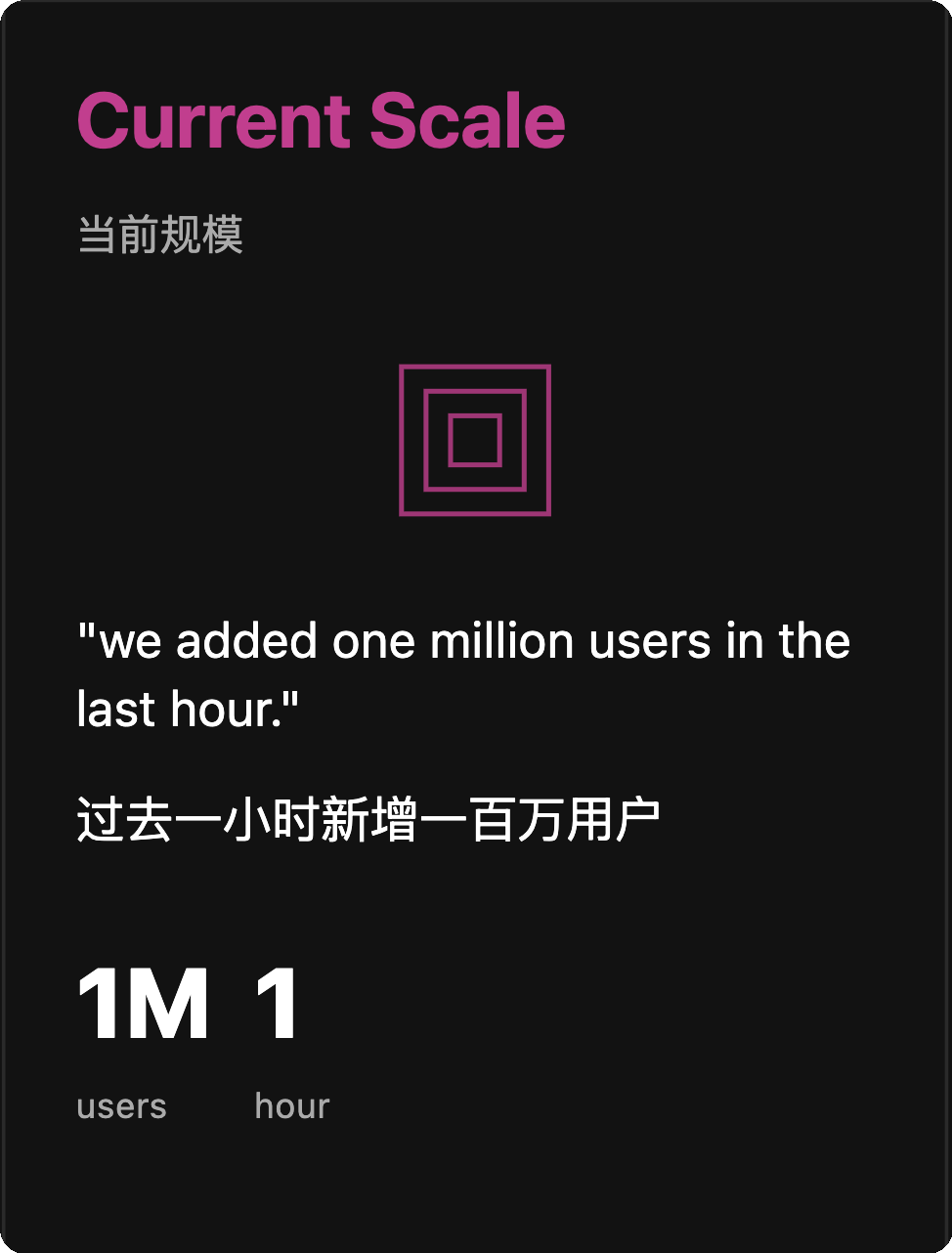

距離ChatGPT引爆全球已過去26個月,那是Altman親眼見證過的最瘋狂的現象級傳播事件之一,當時OpenAI在短短五天內就吸引到了一百萬用戶

而就在啱啱過去的一個小時裏,OpenAI又新增了一百萬用戶

Altman認證「史上最瘋狂傳播時刻」,而這次OpenAI選擇迴歸開源初心——這是自2019年GPT-2之後,OpenAI首次開源語言模型

為什麼現在開源?

Altman「坦誠」:早想做了,但優先級一直排不上。如今時機成熟,團隊認為「這件事變得重要起來」,這裏必須要瘋狂@DeepSeek了😁

新模型兩大特點:

• 開源(open-weight)

• 強化推理能力

雖然未透露具體參數,但官方連用兩個「very」強調目標:「要讓它成為非常、非常優秀的模型」

開發者注意!

OpenAI已啓動全球預熱:

1️⃣ 舊金山首發線下活動

2️⃣ 歐洲、亞太場次接棒

3️⃣ 提前註冊通道開放(文末鏈接)

目的是收集反饋,並讓開發者提前體驗原型。官方明確喊話:想看看大公司和政府如何自主部署模型。

安全牌打滿

從預訓練到發布,OpenAI祭出三重防護:

🔒 沿用自研的「Preparedness Framework」評估框架

🔒 重點研究開源模型特有風險(如對抗性微調)

🔒 內測+第三方專家雙保險

Altman斬釘截鐵:「絕不發布可能造成災難性風險的模型」。

說人話版總結:

OpenAI這次開源,既是向開發者遞橄欖枝,也是給行業喂定心丸——「開源與安全可以兼得」。至於模型到底多強?評論區聊聊你的期待!

附:官方反饋鏈接

https://openai.com/open-model-feedback

全文:

山姆·奧特曼 (Sam Altman)

OpenAI

26個月前 ChatGPT 剛發布時,那是我親眼見證過的最瘋狂的現象級傳播事件之一,當時我們在短短五天內就吸引到了一百萬用戶。 而就在啱啱過去的一個小時裏,我們又新增了一百萬用戶

長話短說: 我們很高興將在未來幾個月內發布一款具備推理能力的、強大的新型開源權重語言模型。我們希望與開發者們交流,探討如何讓這款模型發揮最大作用:https://openai.com/open-model-feedback 我們非常期待能將它打造成一個非常、非常出色的模型!

我們正計劃發布自 GPT-2 以來的首個開源權重語言模型。

這件事我們已經考慮了很久,但此前有其他更優先的事項。現在我們覺得是時候(或者說,認為很重要)來做這件事了。

在發布之前,我們會像對待其他任何模型一樣,依據我們的安全準備框架 (Preparedness Framework) 對該模型進行評估。並且,考慮到我們知道這款模型在發布後可能會被修改,我們還會做額外的工作。 我們還有一些決策尚未最終確定,因此我們將舉辦開發者活動來收集反饋,並在後續讓大家試用早期原型。活動將在幾周後於舊金山 (SF) 啓動,隨後會在歐洲和亞太地區 (APAC) 舉辦。如果您有興趣參加,請通過上方鏈接報名。 我們很期待看到開發者們會創造出什麼,以及那些傾向於自行部署運行模型的大型企業和政府機構將如何使用它。

安全是我們開發這款開源權重模型的核心關注點,貫穿從預訓練到發布的整個過程。 儘管開源模型帶來了獨特的挑戰,但我們會遵循我們的安全準備框架,並且不會發布我們認為可能構成災難性風險的模型。 我們尤其專注於研究對抗性微調 (adversarial fine-tuning) 以及其他開源模型特有的風險。與所有模型的發布一樣,在公開發布之前,我們正在進行廣泛的安全測試,這包括內部測試以及與值得信賴的第三方專家合作進行的測試。