新智元報道

編輯:編輯部 NZYH

【新智元導讀】滿血版o3和o4-mini深夜登場,首次將圖像推理融入思維鏈,還會自主調用工具,60秒內破解複雜難題。尤其是,o3以十倍o1算力刷新編程、數學、視覺推理SOTA,接近「天才水平」。此外,OpenAI還開源了編程神器Codex CLI,一夜爆火。

不出所料,滿血版o3真的來了。

啱啱,OpenAI聯創Greg Brockman和首席研究官Mark Chen帶隊,開啓了20分鐘線上直播。

這次不僅有o3,還有下一代推理模型o4-mini。它們首次實現了「用圖像思考」,堪稱視覺推理的巔峯之作。

如同AI智能體,兩款模型在不到1分鐘內,自主判斷並組合運用ChatGPT內置工具,生成了詳盡周全的答案。

其中包括,搜索網頁、用Python分析上傳的文件及數據、對視覺輸入進行深度推理,乃至生成圖像。

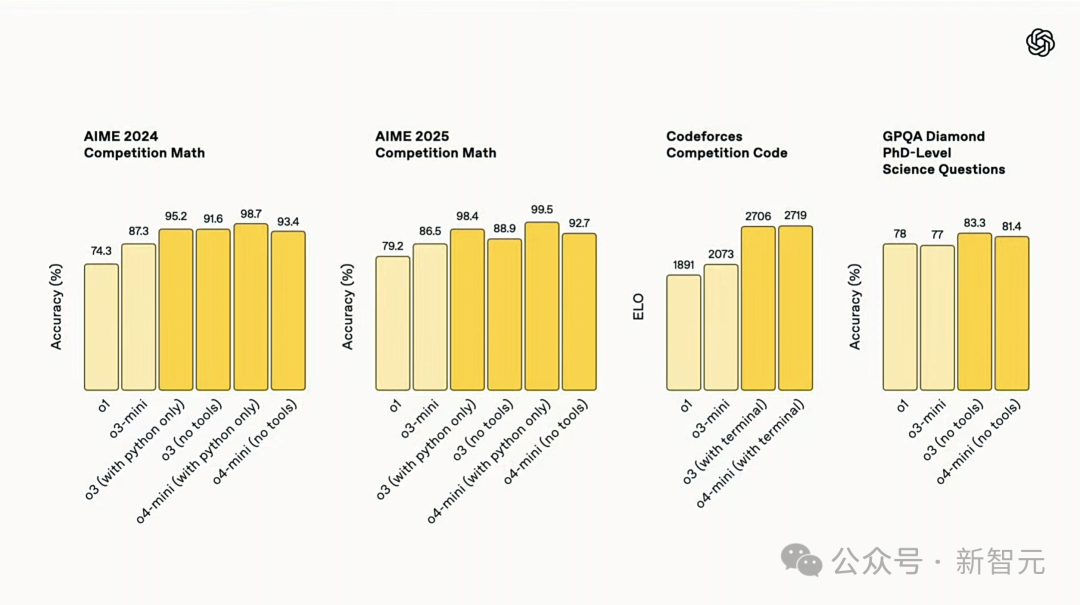

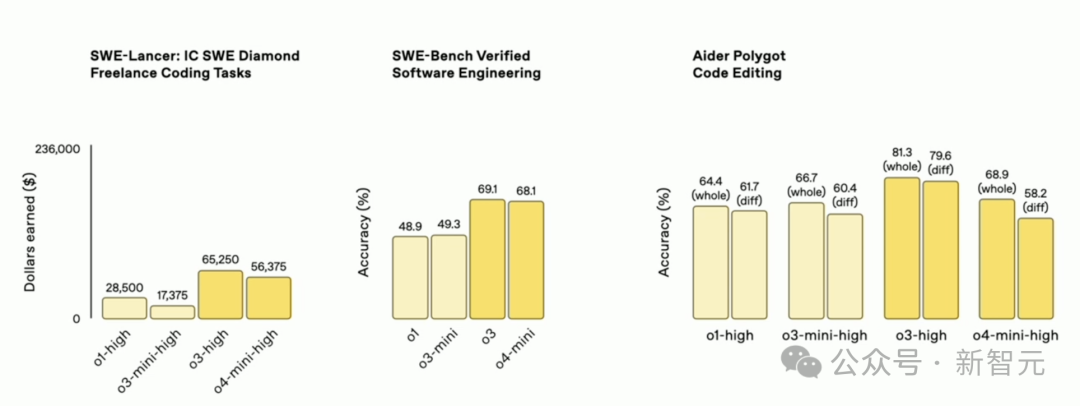

在Codeforces、SWE-bench、MMMU等基準測試中,o3刷新SOTA,不論是在編程、數學、科學,還是在視覺感知領域都樹立了新標杆。

尤其是,對於圖像、圖表、圖形分析,o3表現尤為突出,能夠深入挖掘視覺輸入的細節。

|

|

在Codeforces中,新模型得分均超2700分,在全球參賽者中排名前200名

用奧特曼的話來說,「接近或達到天才水平」。

不過,這個智力的代價是,需要投入o1十倍以上的算力。

相較於滿血版o3,o4-mini則以小巧高效、高性價比的特點脫穎而出。

在AIME 2025測試中,o4-mini配合Python解釋器取得了99.5%高分,幾乎完美拿下了這項基準測試。

而且,在數學、編程、視覺任務,以及非STEM領域,它的性能均優於o3-mini。

此外,o4-mini支持遠超o3的使用額度,是高併發場景最優選。

總而言之,o3和o4-mini都非常擅長編碼,由此OpenAI還開源了一個可在終端運行的輕量級編程 AI 智能體——Codex CLI。

|

|

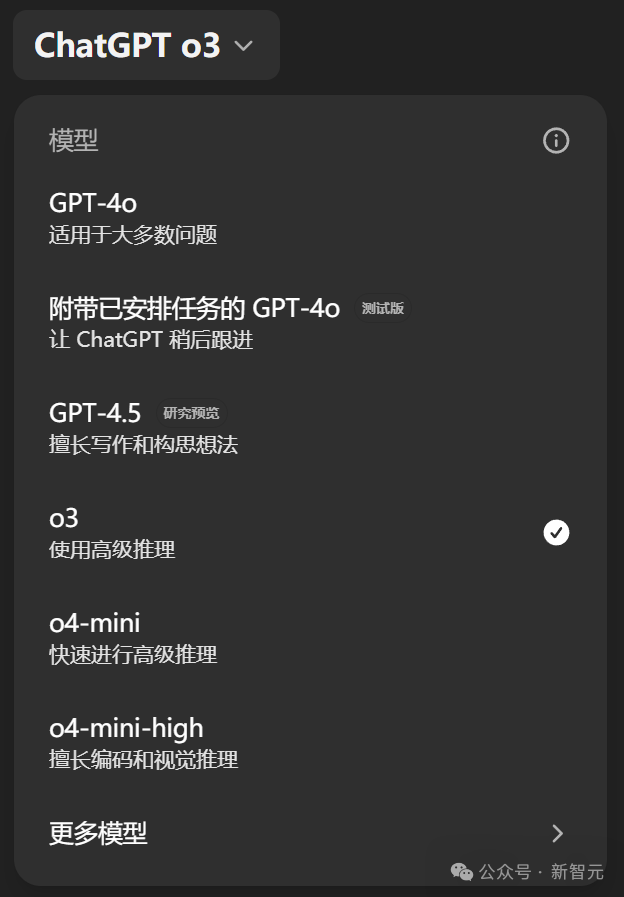

從今天起,ChatGPT Plus、Pro和Team用戶將第一時間體驗到o3、o4‑mini和o4‑mini‑high,它們將取代o1、o3‑mini和o3‑mini‑high。

同時,這兩款模型也將通過Chat Completions API和Responses API,向所有開發者提供。

推理模型,首次會用工具了

直播演示中,Greg先上了一個價值——有些模型就像是質的飛躍,GPT-4是其中之一,今天o3/o4-mini同樣是。

他表示,o3讓他和OpenAI的同事見到了AI大模型能完成「從未見到的事」,比如,它自己就提出了一個很棒的系統架構想法。

這兩款模型真正令人驚訝的地方,它們不僅僅是模型,更是一個「AI系統」。

它們跟之前那些推理模型最大的區別,就是首次被用來訓練各種工具。它們會在CoT中使用這些工具來解決難題。

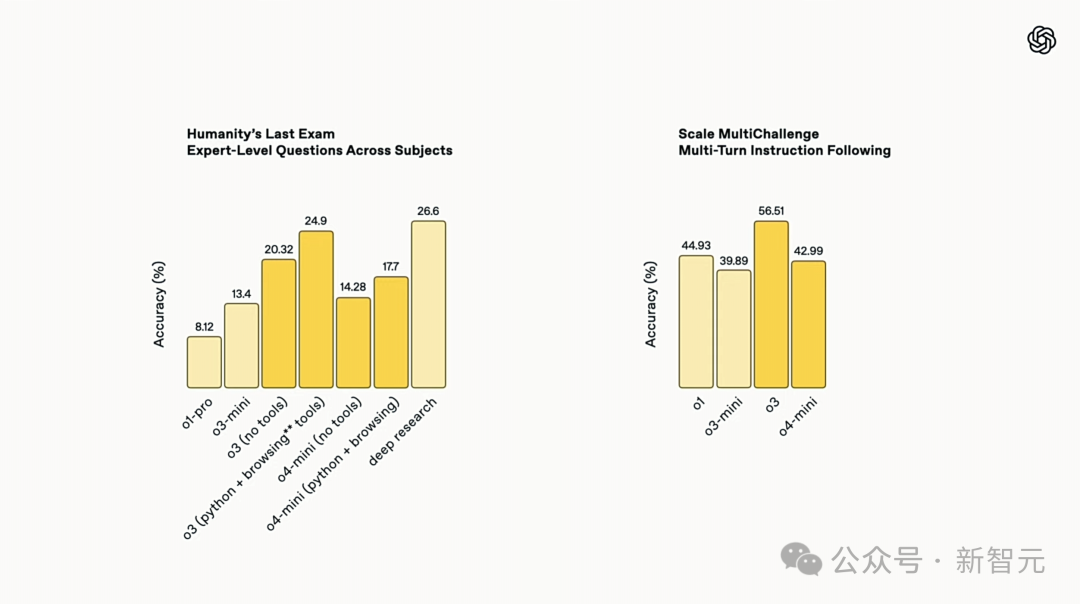

人類最後考試中,o3模型足以媲美Deep Research表現,而且速率更快

為了攻克了一個複雜難題,o3曾連續使用約600次工具調用。它們一次性生成的代碼片段,真正在代碼庫發揮效用。

Greg表示,自己最珍視的一點,就是它們的軟件工程能力:它們不僅能編寫一次性的代碼,而且能真正在真實的代碼庫中工作!

比如,它在瀏覽OpenAI代碼庫方面,就比Greg做得更好。這就是它極其有用的地方。

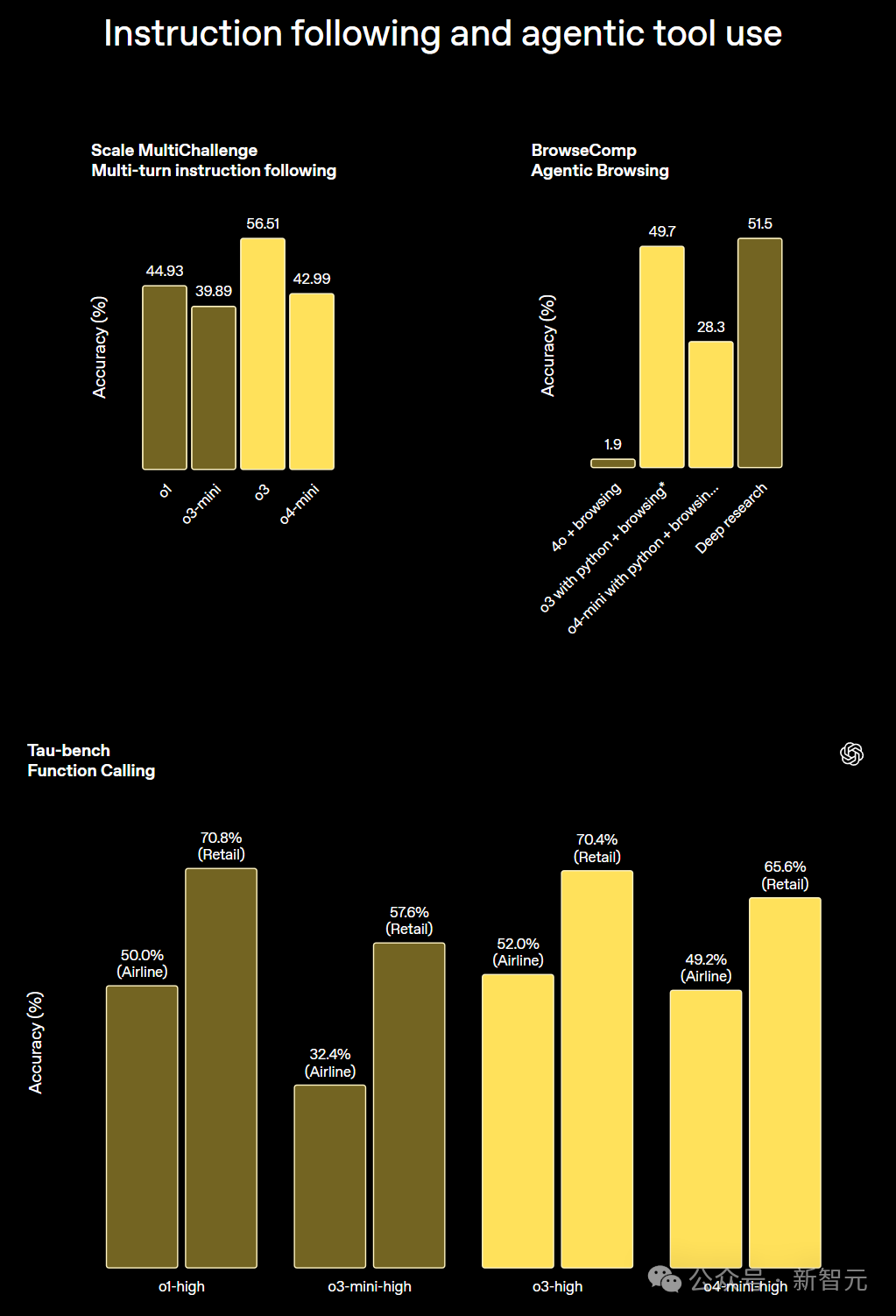

而且,在指令跟隨、智能體工具使用評估中,與工具結合的o3和o4-mini準確性是最高的。

外部專家評估顯示,o3在處理真實世界任務時,嚴重錯誤率比o1還降低了20%。

之所以有如此大的進步,正是因為RL中持續的算法進步所驅動的。用Greg的話說,引擎蓋下最令人驚歎的是,目前它還仍然是預測一個token,然後加入一點RL的AI,就已經做到這個地步。

那麼,在實操過程中,o3是如何結合使用工具解決複雜任務的呢?

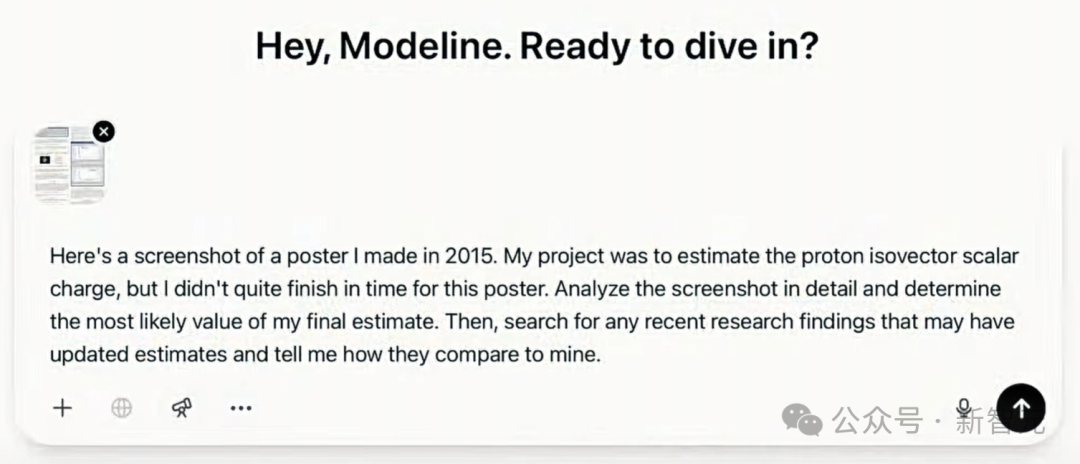

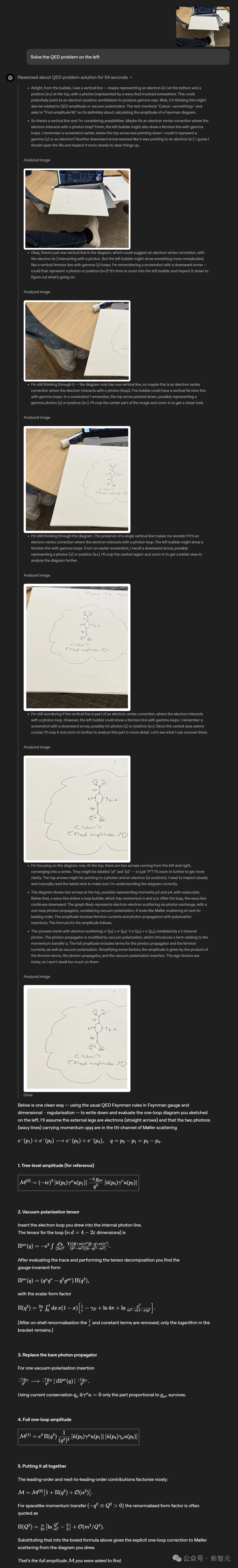

多模態團隊研究員Brandon McKinzie上傳了一張2015年完成的一個物理實習海報,讓ChatGPT估算質子同位標量電荷的數量。

o3開始推理的同時,逐一分析圖片中內容,並確定Brandon提出問題的正確數量。實際上,海報截圖中並沒有覆蓋最終結果。

於是,o3便開始聯網搜索查找最新的估算值,幾秒鐘內讀完數十篇論文,節省了大量時間。

結果顯示,模型計算出了一個未經歸一化的值,並且乘以一個特定常數,又可以重新歸一化,最終結果與實際比較接近。

後訓練團隊研究員Eric Mitchell為ChatGPT開啓了記憶功能, 然後讓o3去查找新聞,而且是與自己興趣有關的內容,同時還要足夠冷門。

o3基於已有的了解——潛水和演奏音樂,主動思考並調用工具,找出了一些相關的有趣內容。

比如,研究人員錄製了健康的珊瑚聲音,並用揚聲器播放錄音,加速了新珊瑚和魚類定居。

同時,它還能繪製出可視化的數據,便於直接放入博客文章當中。

也就是說,無論o3是用於前沿的科研領域,還是將模型集成到日常工作流中,都會非常有用。

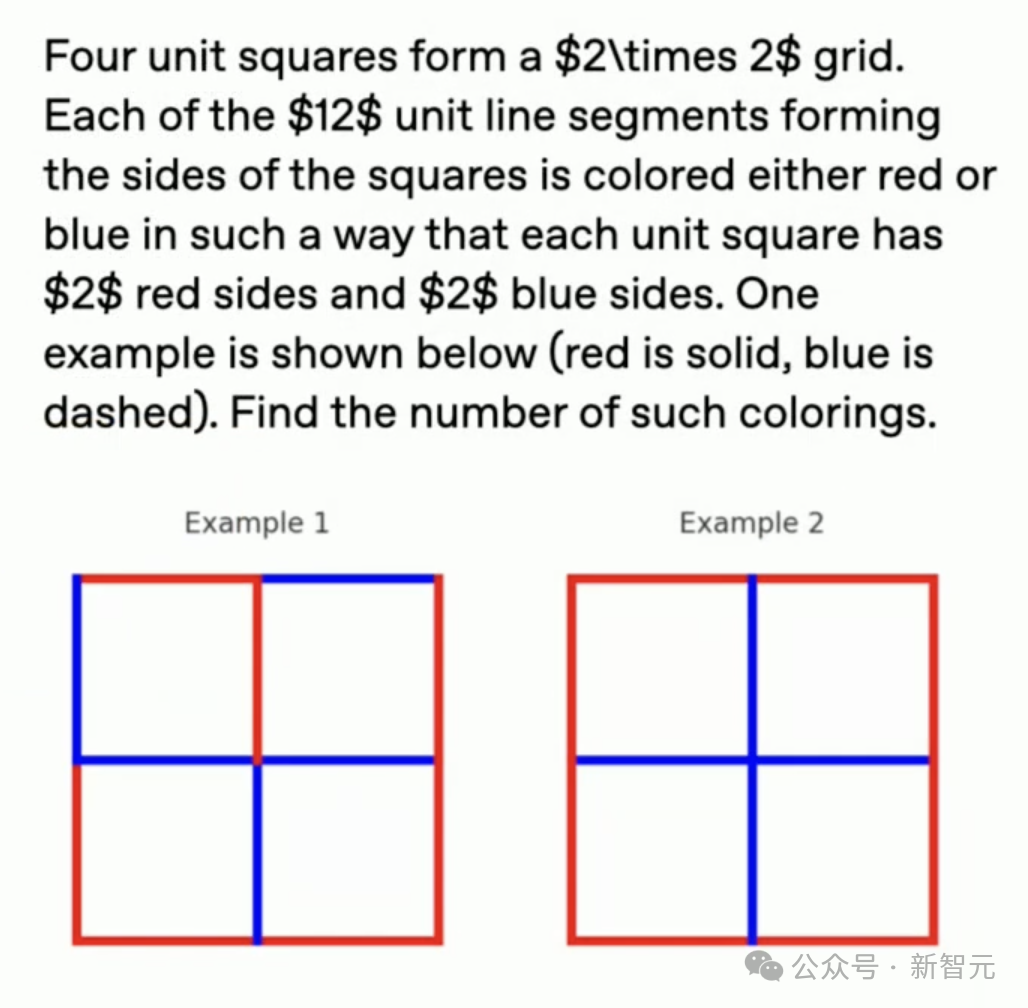

在解決AIME數學競賽問題時,o3被要求觀察2x2方格網格,並計算出滿足約束條件的顏色方案數量。

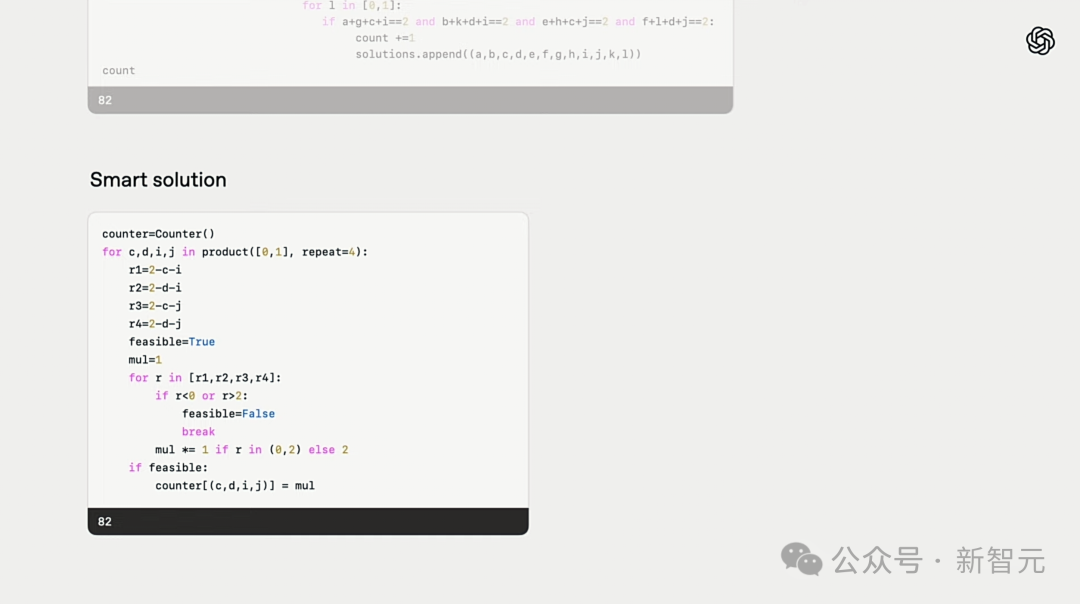

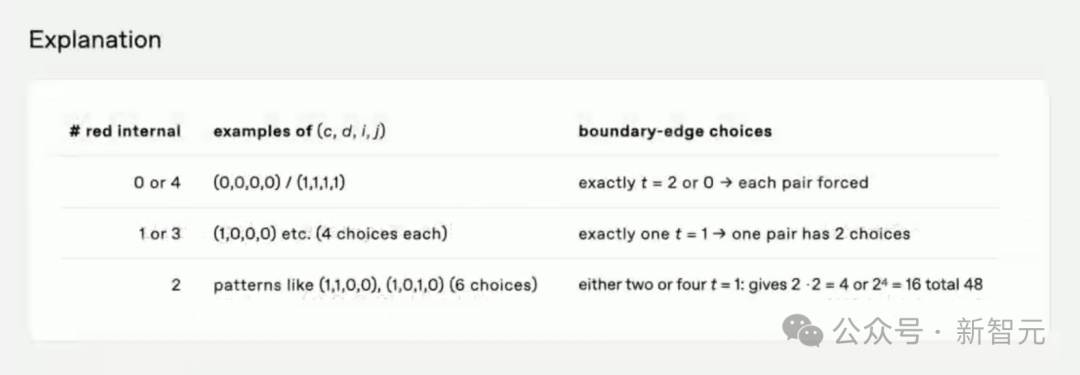

它首先生成了一個暴力程序,然後用Python解釋器運行,並得到了正確答案,即82。

即便如此,它的解題過程並不優雅簡潔,對此,o3自動識別後並嘗試簡化解決方案,找到更聰明辦法。

它還會自動覈查答案的可靠性,甚至最後給出了文字解決方案,方便向人類解釋。

讓研究人員驚訝的是,訓練o3過程中並沒有使用類似策略,也沒有要求簡化,都是AI自主學習完成的。

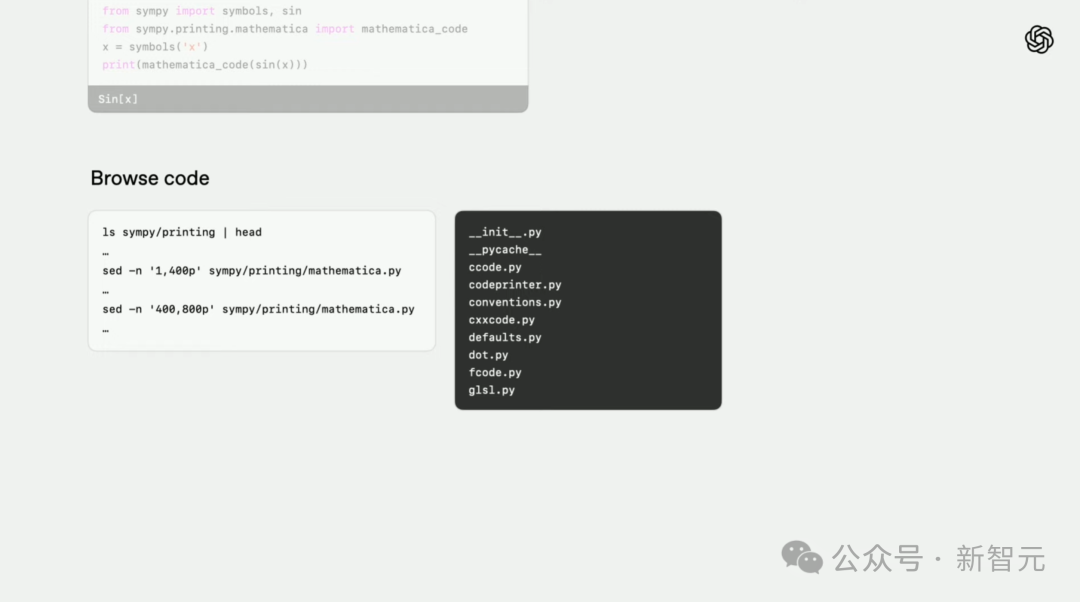

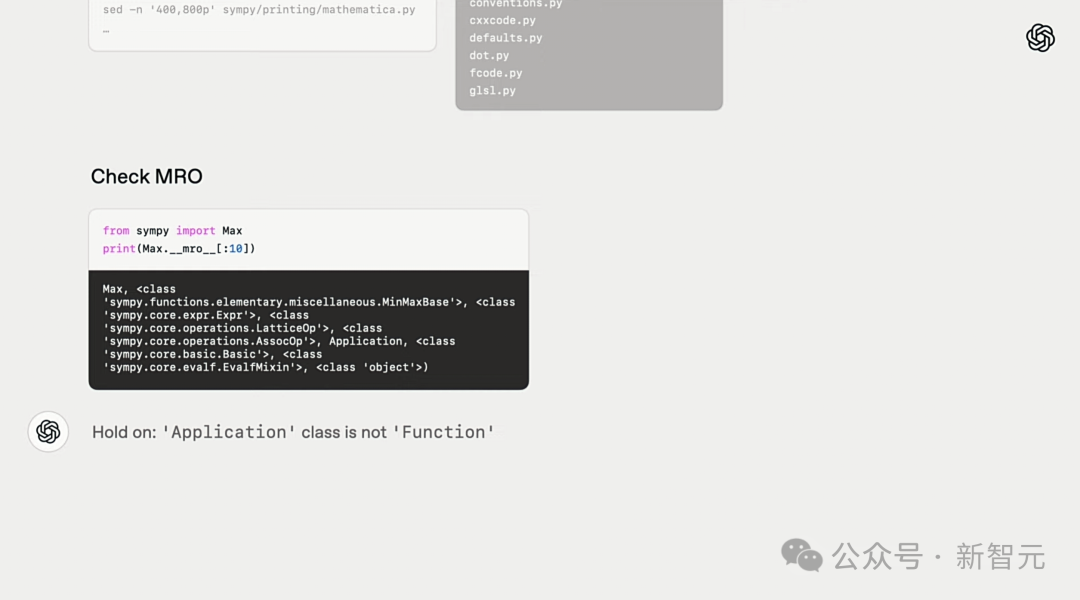

在編碼任務中,研究人員讓o3-high找出一個名為symbols軟件包的錯誤。

首先,模型會主動檢查指令中,所說的問題是否存在,並嘗試了解代碼儲存庫的概況。

然後,它發現一可以mro的解釋類繼承信息的Python結構,基於已有的世界知識,找到了問題所在。

最後,o3通過瀏覽互聯網,找到了最優的解決方案——apply_patch。

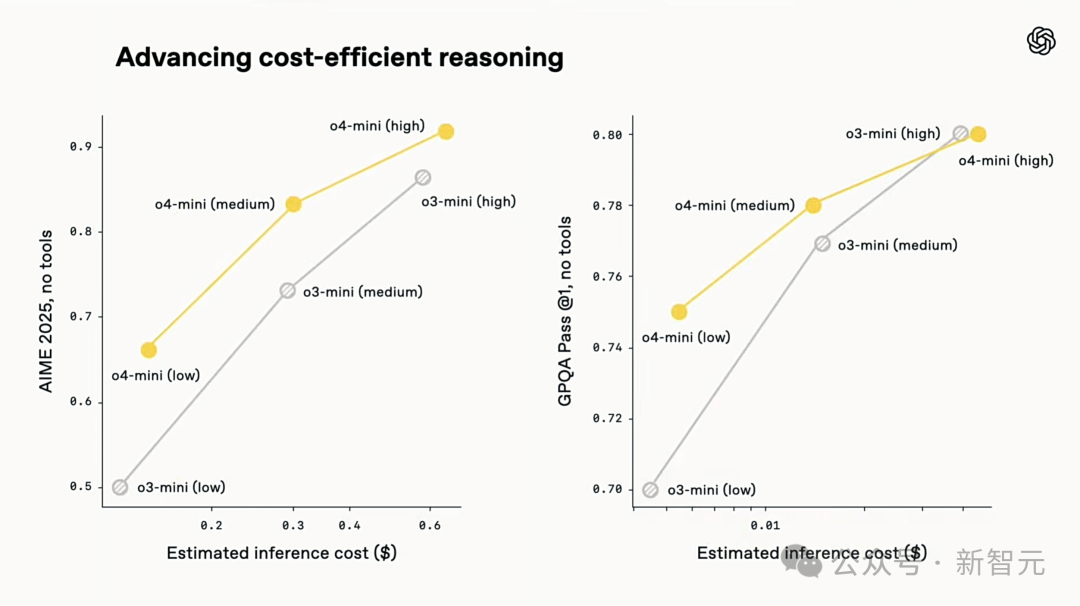

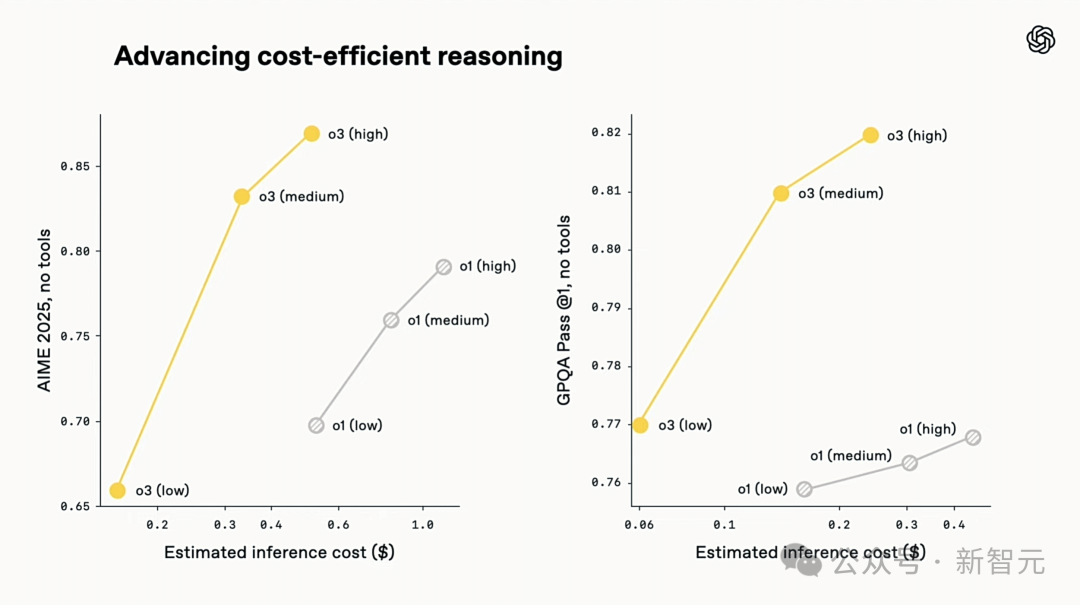

就推理成本來看,o3和o4-mini不僅是迄今為止最智能模型,相較於o1和o3‑mini,更在效率和成本控制方面樹立了新標杆。

在2025年AIME數學競賽上,o3推理成本和性能全面優於 o1,同樣地,o4-mini成本-性能也全面優於o3‑mini。

所以,如果你需要一個小而快的多模態推理模型,o4-mini將是極好的選擇。

|

|

o3和o4-mini能夠自主選擇工具、計劃方法解決問題,無論是數學、商業、科學、體育還是視覺推理都沒問題。

比如,在解決體育問題時,o3能聯網獲取最新數據,考慮了最近一個賽季和2022-23年聯賽ERA略升後迴歸正常的情況。

o1給出的數據是大概值,略有偏差,不夠精確,而且它錯誤地認為偷壘增加完全是因為投球計時器,忽略了基地墊擴大和限制牽制次數這些更直接的原因。

左右滑動查看

用圖像思考,視覺推理新巔峯

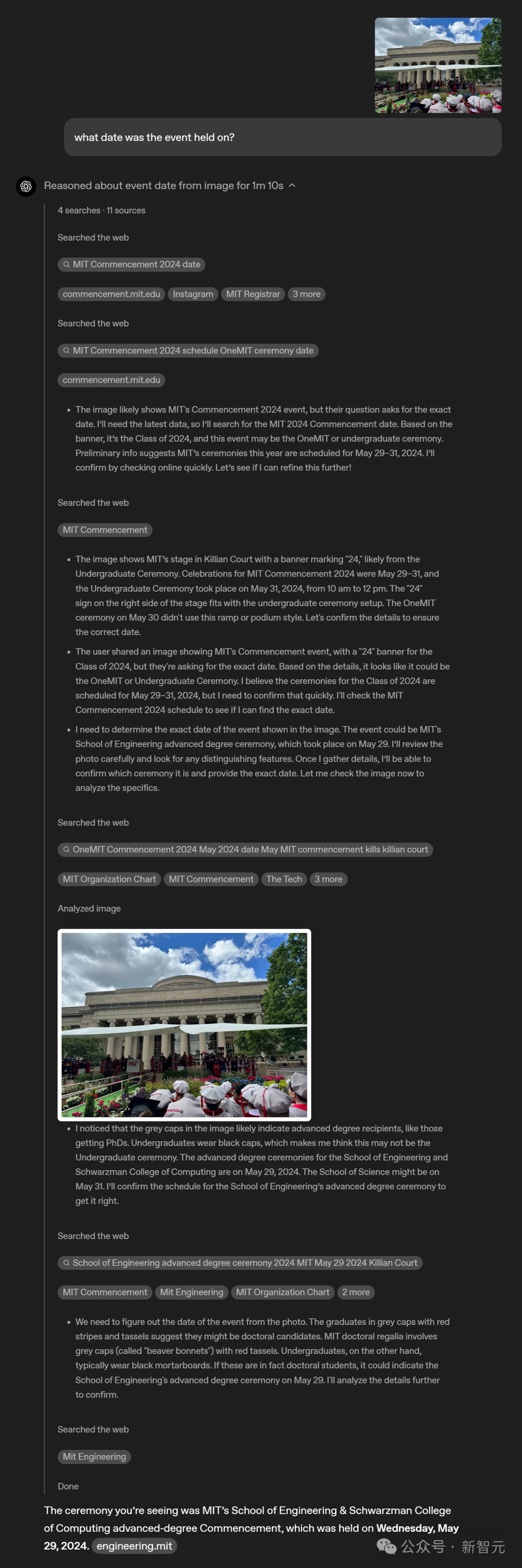

更引人注目的是,o3和o4-mini在視覺推理上全面超越前代,成為o系列最新的視覺推理模型。

它們通過在思維鏈(CoT)中用圖像進行推理,實現了視覺感知的重大突破。

OpenAI首次實現了模型在其思維鏈中用圖像進行思考——而不僅僅只是看圖。

與早期的OpenAI o1類似,o3和o4-mini能在回答前思考更久,在回答用戶前內部會生成很長的思維鏈。

不僅如此,o3和o4-mini可以在思考過程中「看」圖片。這種能力是通過工具處理用戶上傳的圖像來實現的,比如進行裁剪、放大、旋轉等簡單的圖像處理。

更厲害的是,這些功能都是原生的,不需要依賴額外的專業模型。

在基準測試中,這種用圖像思考,無需依賴網絡瀏覽的能力,碾壓了前代多模態模型的性能。

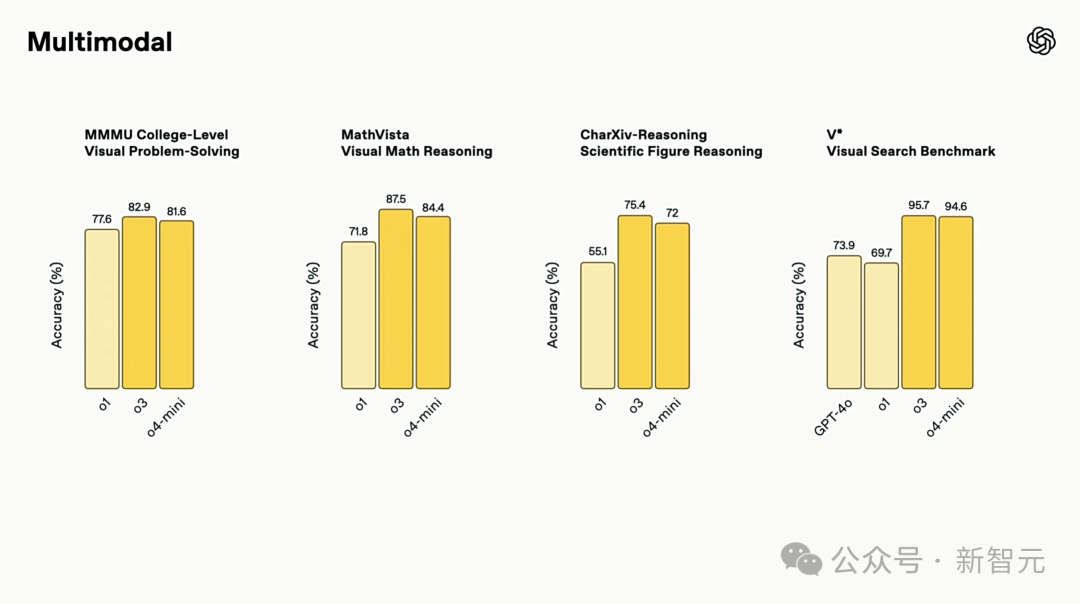

在STEM問答(MMMU、MathVista)、圖表閱讀與推理(CharXiv)、感知基元(VLMs are Blind)以及視覺搜索(V*)等領域,o3和o4-mini均創下了SOTA。

特別是,在 V*基準測試上,兩款模型以96.3%準確率幾乎攻克了這項挑戰,標誌着視覺推理技術重大飛躍。

ChatGPT增強的視覺智能,能更徹底、精準、可靠地分析圖片,幫你解決更棘手的問題。

它能將高級推理與網頁搜索、圖像處理等工具無縫結合,自動放大、裁剪、翻轉或優化你的圖片,哪怕照片不完美也能挖掘出有用信息。

比如,你可以上傳一張經濟學作業的照片,得到一步步的解答,或者分享一個程序報錯的截圖,快速找出問題根源。

這種方法開啓了一種新的測試時計算擴展方式,完美的融合了視覺和文本推理。

這體現在它們在多模態基準測試中的頂尖表現,標誌着多模態推理邁出了重要一步。

視覺推理實戰

用圖像思考可以與ChatGPT更加輕鬆的互動。

你可以直接拍張照片提問,不用擔心物體擺放問題——不論文字是不是倒的,或者一張照片裏有多道物理題。

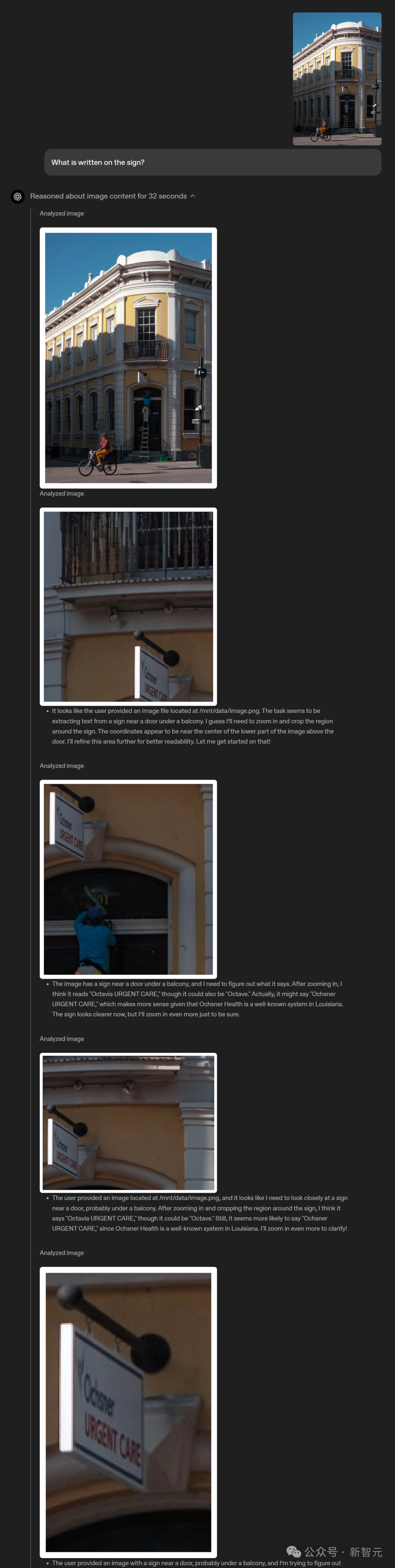

即使東西乍一看不太清楚,視覺推理也能讓模型放大看清細節。

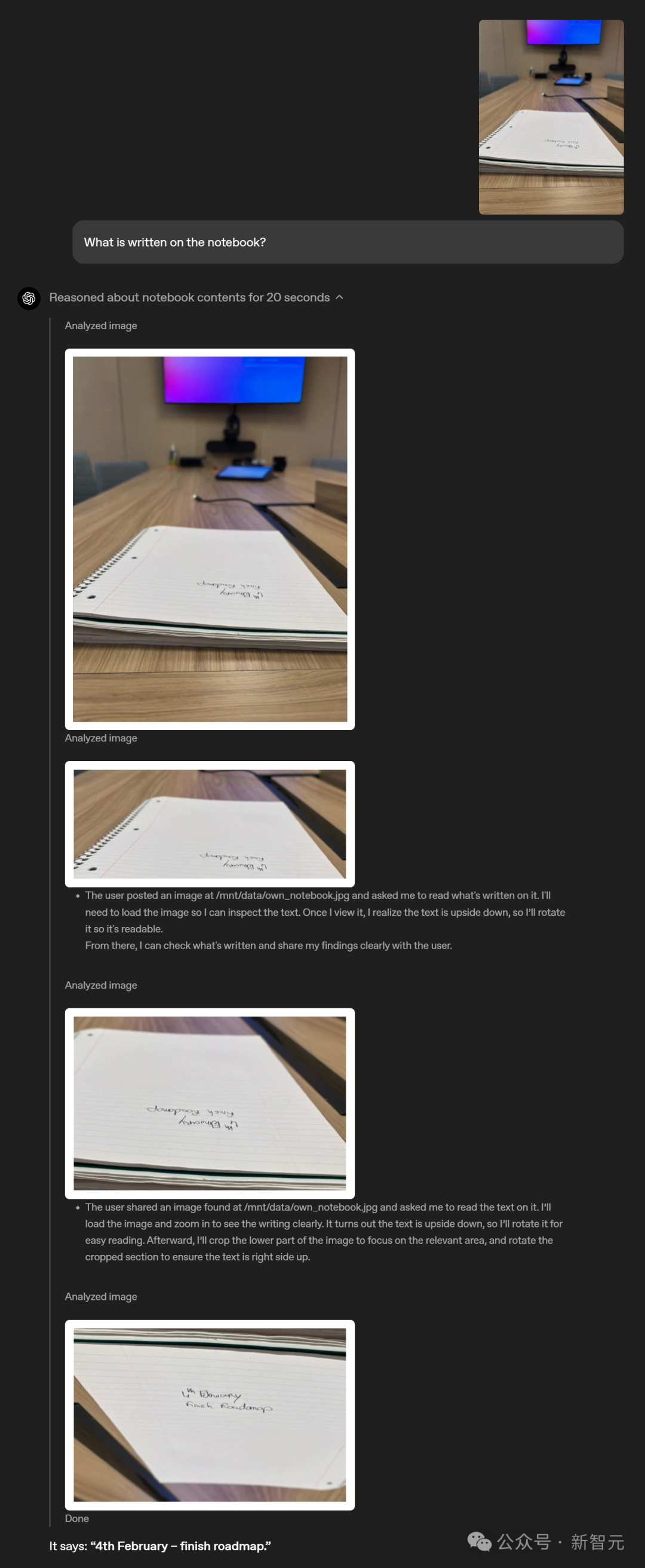

比如,一個放在桌子上幾乎與視線平行的筆記本,上面有兩行模糊的字,人看上去也很難直接認出來。

而ChatGPT可以將圖片放大查看,發現字是倒着的後,還將其旋轉過來,最終成功將其給認了出來。

上下滑動查看

上下滑動查看

上下滑動查看

上下滑動查看

OpenAI最新的視覺推理模型能跟Python數據分析、網頁搜索、圖像生成等工具配合,創意又高效地解決更復雜的問題,為用戶首次帶來了多模態智能體驗。

編程智能體Codex CLI全開源

接下來,OpenAI表示,將展示一些codex遺產的延續,發布一系列應用程序,而它們,將定義編程的未來。

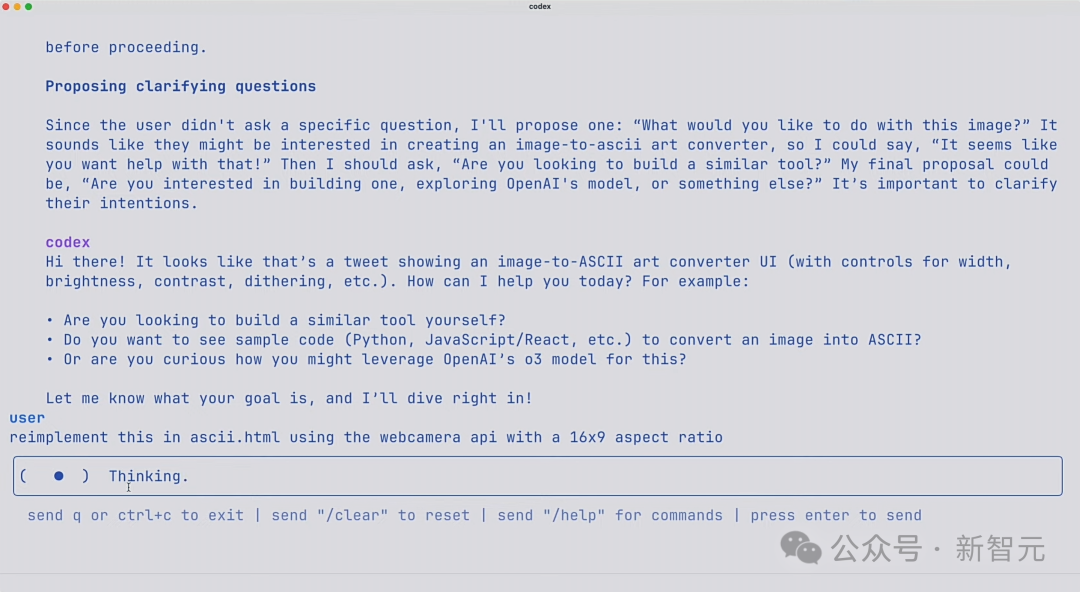

除了新模型之外,OpenAI還開源了一項新的實驗性工具:Codex CLI,一個可在終端運行的輕量級編程AI智能體。

它的作用,就是在需要的地方安全地部署代碼執行。

它直接在本地計算機上運行,旨在充分發揮o3和o4-mini這類模型的強大推理能力,並將很快支持GPT-4.1等更多模型的API調用。

通過向模型傳遞螢幕截圖或低保真草圖,並結合訪問本地代碼的權限,就能在命令行中體驗到多模態推理的強大功能。

同時,他們也啓動一項100萬美元的資助計劃,用以支持使用Codex CLI 和 OpenAI 模型的項目。

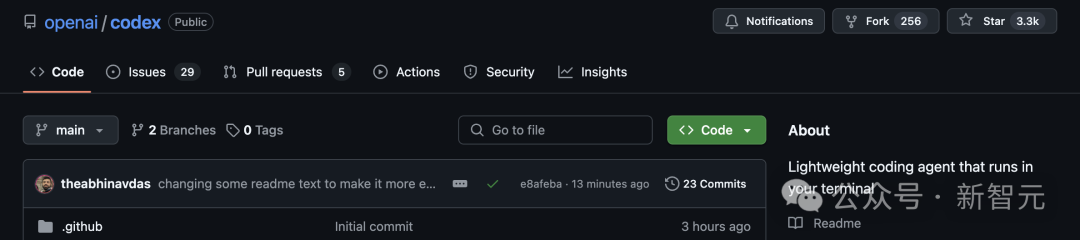

GitHub項目一經發布,Codex CLI已斬獲3.3k星,可見響應度之高。

項目地址:https://github.com/openai/codex

現場,OpenAI演示人員參考了網上的帖子,使用Codex和o4 Mini做了一個很酷的圖片轉ASCII生成器。

只需先截一張圖,拖進終端裏,接下來就可以把它交給Codex。

令人驚歎的是,你可以實際看到它在思考,還可以直接運行工具。

完成後,Codex創建了一個ASCII HTML文件,甚至還生成了一個可以控制分辨率的滑塊。

也就是說,從此電腦上的任何文件,以及你正在處理的代碼庫,都可以放進Codex了!

在現場,研究者們還成功添加了一個網絡攝像頭API。

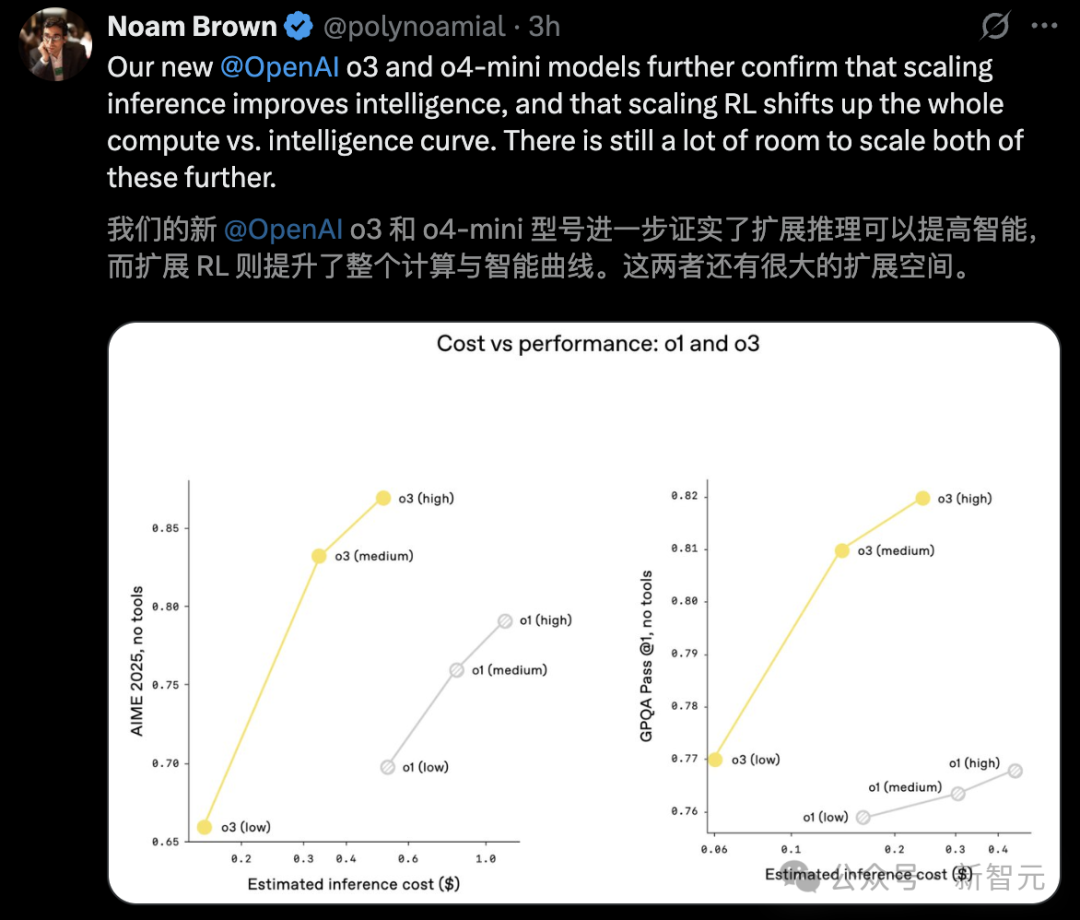

Scaling強化學習,依舊有效

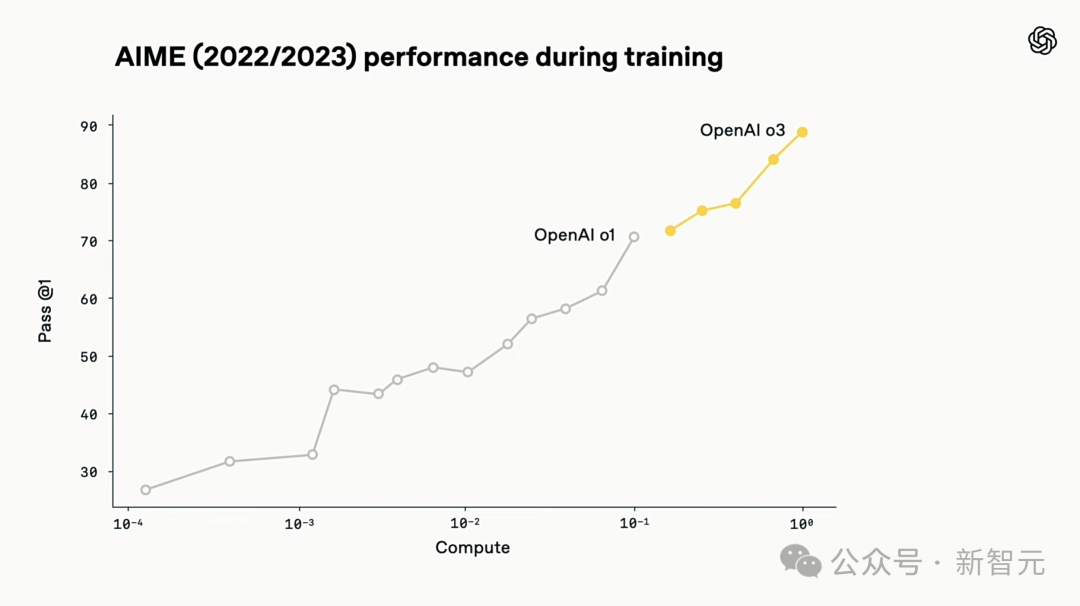

在OpenAI o3的整個研發過程中,研究者觀察到一個現象:大規模強化學習同樣遵循着GPT系列預訓練時顯現的規律——即「投入越多的計算資源,就能獲得越好的性能」。

他們循着這條Scaling路徑,這次將重點放在強化學習(RL)上,把訓練計算量和推理階段的思考量(或稱推理計算量)都提升了一個數量級,結果依然觀察到顯著的性能提升。

技術報告:https://cdn.openai.com/pdf/2221c875-02dc-4789-800b-e7758f3722c1/o3-and-o4-mini-system-card.pdf

這驗證了只要給模型更多時間去「思考」,它的表現就會持續提高。

相較於前代o1,o3在相同延遲和成本下展現出更高的性能。更令人興奮地是,當允許思考更長時間,其性能還會繼續攀升。

此外,OpenAI通過強化學習訓練,讓o3和o4-mini掌握了工具使用的智慧——不僅學會「如何用」,更懂得「何時用」。

它們不僅能完全訪問ChatGPT內置的工具,還能通過API中的函數調用功能接入用戶自定義的工具。

這種能力讓模型在開放式場景時,更加遊刃有餘,尤其是在需要視覺推理和多步驟工作流的複雜任務中。

而且,從前面諸多案例中,我們已經對模型工具調用的能力,獲得了關鍵一撇。

那些提前拿到內測資格的大佬們,紛紛被o3震驚了。

尤其是在臨牀和醫學領域,它的表現堪稱現象級。無論是診斷分析還是治療建議,彷彿出自頂尖專家的手筆。

不論是加速科學發現、優化臨牀決策,還是推理跨領域的創新,o3正成為這場變革的主導者。

參考資料:

https://openai.com/index/thinking-with-images/

https://openai.com/index/introducing-o3-and-o4-mini/