智通财经APP获悉,12月25日,TechInsights发文称,存储器市场,包括DRAM和NAND,预计在2025年将实现显著增长,这主要得益于人工智能(AI)及相关技术的加速采用。预计HBM出货量将同比增长70%,因为数据中心和AI处理器越来越多地依赖这种类型的存储器来处理低延迟的大量数据。边缘AI将AI处理功能更接近智能手机和PC等设备的数据源,预计将在2025年进入市场。但真正的转变应该发生在2026年,随着边缘AI变得更加普及,将推动对适合这些新功能的内存解决方案的需求。

AI持续推动对高带宽内存(HBM)的关注

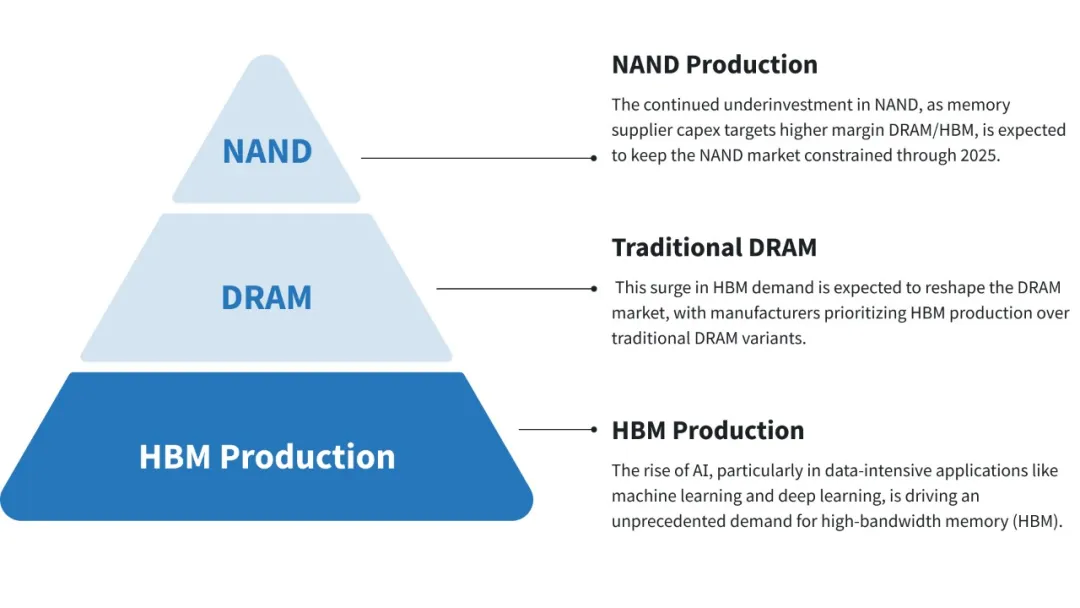

随着AI的兴起,特别是在机器学习和深度学习等数据密集型应用中,对高带宽内存(HBM)的需求空前高涨。HBM需求的激增预计将重塑DRAM市场,制造商将优先生产HBM,而不是传统的DRAM产品。

AI推动对大容量SSD和QLC NAND技术的需求

随着AI继续渗透各行各业,对大容量固态硬盘(SSD)的需求也在上升。这对于需要大量数据存储和快速检索时间的AI工作负载尤其如此。因此,预计QLC NAND技术的采用率将增加,该技术以较低的成本提供更高的密度。尽管QLC SSD的写入速度比其他NAND类型慢,但由于其成本效益和适合AI驱动的数据存储需求,它们将获得更多青睐。预计数据中心NAND bit 需求增长继2024年约70%的爆炸性增长之后,将在2025年超过30%。

资本支出(Capex)投资大幅转向DRAM和HBM

受AI应用激增的推动,内存市场的资本支出(capex)越来越多地流向DRAM,特别是HBM。随着制造商扩大产能以满足日益增长的需求,DRAM资本支出预计将同比增长近20%。然而,这一转变导致对NAND生产的投资极少,可能在市场上造成潜在的供应瓶颈。NAND领域的盈利能力持续改善,这可能会在 2026 年重新点燃该领域的投资热情。

边缘AI开始崭露头角,但要到2026年才会产生显著影响

边缘AI将AI处理功能更接近智能手机和PC等设备的数据源,预计将在2025年进入市场。然而,该技术的全面影响要到2026年才会显现。具有真正设备端AI功能的设备预计将在2025年底推出,但销量可能不足以立即影响存储器市场。

数据中心AI重点延迟了传统服务器更换周期

对AI驱动的数据中心的关注导致传统服务器基础设施的更换周期延迟。许多企业正在将资源转移到升级其AI能力上,导致传统服务器需要更新。虽然这种延迟在短期内可能是可控的,但在某个时候,这些服务器将需要更新,这可能会推动DRAM和NAND需求的突然激增。这种延迟的更换周期一旦发生时,可能会推动存储器需求显著增加。