中国大模型又在包括硅谷在内的全球AI圈炸场了。

两天前,幻方量化旗下AI公司深度求索(DeepSeek),以及月之暗面相隔20分钟相继发布了自家最新版推理模型,分别是DeepSeek-R1以及Kimi 全新多模型思考模型k1.5,且都给出了非常详尽的技术报告, “中国双子星”很快引发全球AI圈的关注。

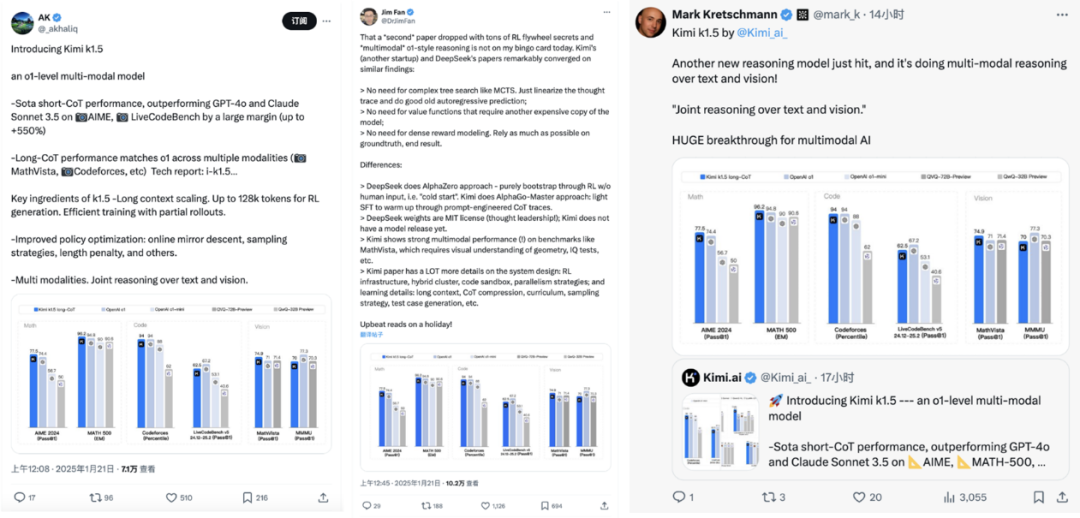

在社交软件X上,包括英伟达AI科学家Jim Fan在内的全球AI从业者纷纷发出了自己的感叹:

相关数据显示,区别于过往类o1-preview模型,这次两家中国公司正面硬刚OpenAI o1,发布的都是满血版o1,而Kimi k1.5还是具备视觉思考的多模态。

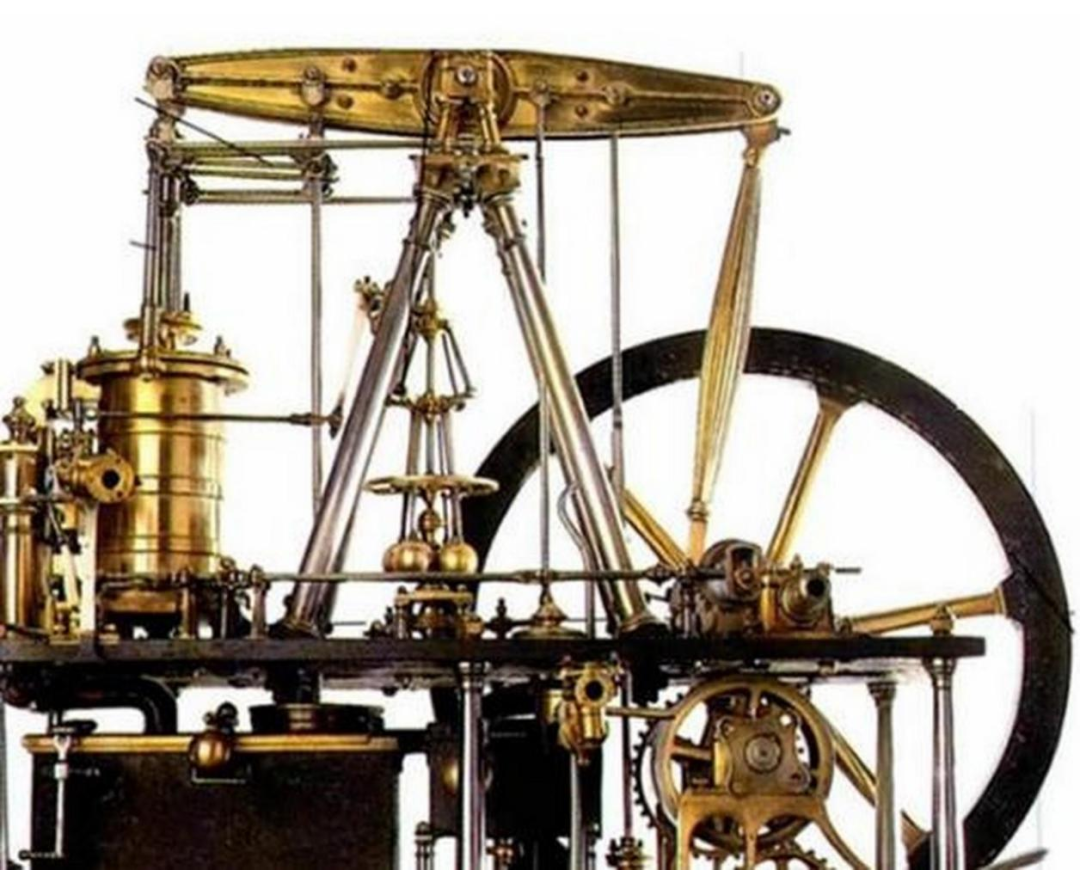

表面上,是中国大模型某种程度上又一次在技术能力上直起了腰,而全球AI从业者的“围观”,本质上则透露出业界对大模型这台“蒸汽机”能够尽快出现属于自己的“瓦特”的期许。

01

大模型这台蒸汽机,急需要一个“瓦特”

大模型对时代的意义,不亚于蒸汽机之于工业革命。

但正如蒸汽机是在发明之后,是经过一段时间的改进,尤其是瓦特的改进后才正在成为工业革命驱动力一样,大模型这台“蒸汽机”要想大展拳脚,还一直处在不断改进之中。

那个属于它的“瓦特”,还一直没有到来,所有从业者都在热切期待这个时刻。

参与的人越多,“瓦特时刻”出现的可能性就越大,只有一个遥遥领先的OpenAI未必符合业界的普遍期许,当出现了与之肩并肩的DeepSeek、Kimi,关键进化的可能性变得更大,炸场AI圈就成为普遍期待下的必然。

而回看DeepSeek与Kimi这对中国双子星,他们发布的模型呈现了很多相似之处,都侧重以强化学习(RL)为核心驱动力(即在仅有极少标注数据的情况下,极大提升模型推理能力)。

具体来说,二者在实现方式上都不需要进行像 MCTS 那样复杂的树搜索(只需将思维轨迹线性化,然后进行传统的自回归预测即可),也不需要配置另一个昂贵的模型副本的价值函数、不需要密集奖励建模,只尽可能多的依赖事实和最终结果。

很明显,这些,都在提升推理模型的运行效率、降低资源需求,而有意思的是,这同样是当年瓦特改造蒸汽机的方向,他在众多改造中最完美地实现了这些目标。

历史,总是惊人的相似。

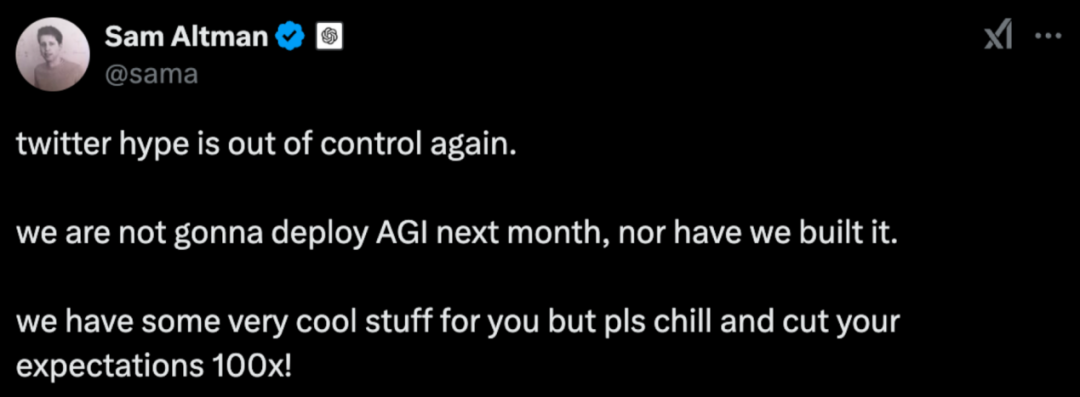

值得一提的是,在这次中国双子星炸场的过程中,OpenAI萨姆·奥尔特曼也加入其中,只不过他发挥了一贯的“阴阳”技能,“AGI不会下个月就到来”,在一片赞誉甚至狂欢中,暗地里讽刺社交平台的关注是不是太过疯狂。

实际上,AGI确实不是短期能做到的,但这并不是制止全球从业者欢欣鼓舞的理由。蒸汽机花了很长时间才完成进化能够走入工厂,大模型也需要这样的过程才能实现对社会进步的全面赋能,也正因为如此,每一次对这个进程的缩短,都值得每一个从业者欣慰。

02

中国双子星,让业界看到“瓦特”的更多可能性

具体到技术层面,当仔细分析中国双子星尤其是Kimi的SOTA模型能力后,就会发现业界人士的惊喜有着充分的理由。

以“蒸汽机”类比,瓦特的改进首先是直接提升了运行效率,提升了蒸汽转化为机械动力的能力,从而能够由“试验装置”走向真正的“机器”。

这次发布的模型首先也是在推理能力上大幅跨越,发布的都是真正的“满血版o1”,而不是其他各家所发布的“准o1”,或者得分差得太远的o1,有着绝对实力上的领先而非只是小小的一次迭代。

更进一步看,瓦特对蒸汽机的改进还在机器对不同生产环境的适应能力上进行了改造,对应到大模型这里,则是推理大模型的多模态进化。

目前,DeepSeek R1只能识别文字、不支持图片识别不同,Kimi k1.5则能进行一步多模态推理,且在数学、代码、视觉等复杂任务上的综合性能提升,成为OpenAI之外首个多模态类o1模型。

以Kimi k1.5为例:

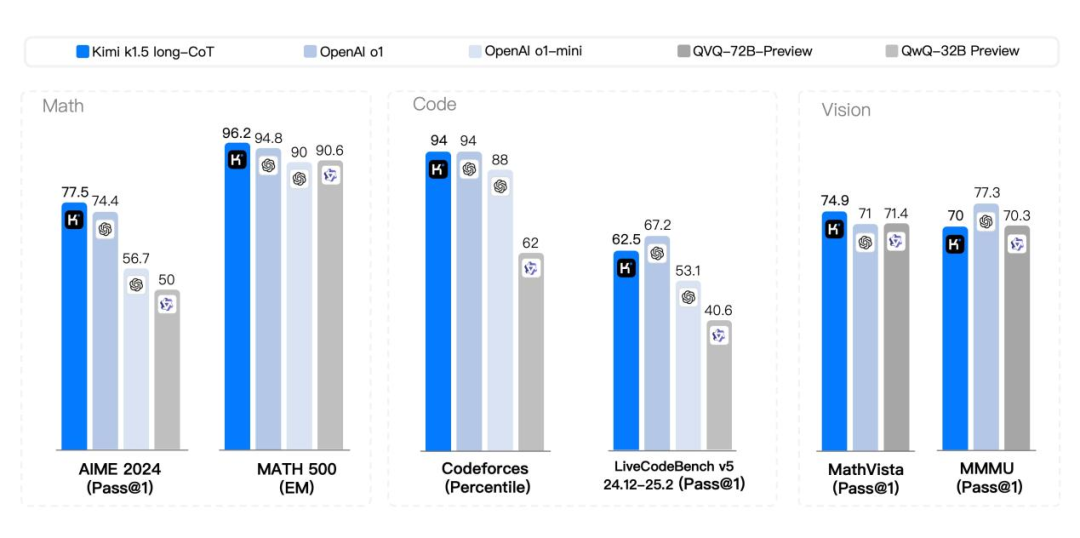

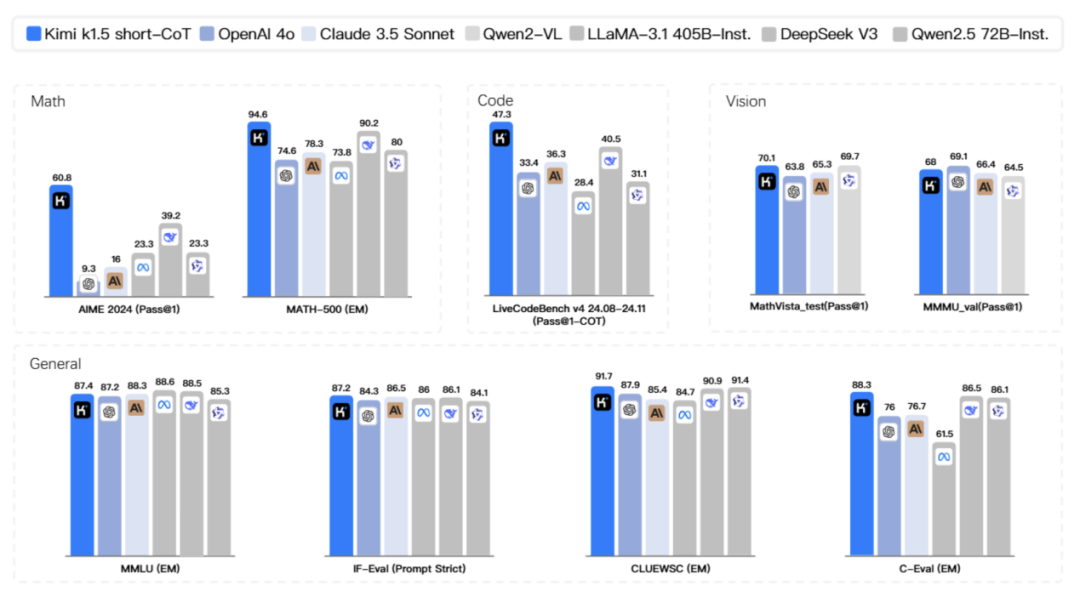

一方面模型在数学和代码能力上的推理能力和正确率(诸如 pass@1、EM等指标)大幅领先或赶超其他主流对比模型;

另一方面模型在在视觉多模态任务上,无论是对图像中信息的理解、还是进一步的组合推理、跨模态推理能力,都有显著提升。

截取Kimi的发布Paper原文,其长文本处理能力大幅提升,支持高达128ktokens 的 RL生成,采用部分展开方式进行高效训练,且在训练策略上有包括在线镜像下降法等在内的多项改进。

在长思考模式(long-CoT)下,Kimi K1.5在数学、编程和视觉任务中的表现与OpenAI o1的性能水平接近。

而到了短思考模式(short-CoT)下,Kimi k1.5 更是让业界惊喜,做到了某种程度上的“遥遥领先”,其数学、代码、视觉多模态和通用能力,大幅超越了全球范围内短思考SOTA模型GPT-4o和Claude 3.5 Sonnet的水平,领先达到550%。

这种领先,得益于Kimi k1.5独特的“Long2Short”训练方案,顾名思义,即先利用较大的上下文窗口让模型学会长链式思维,再将“长模型”的成果和参数与更小、更高效的“短模型”进行合并,然后针对短模型进行额外的强化学习微调。

这种做法,最大化保留了原先长模型的推理能力,避免了常见的“精简模型后能力减弱”难题,又能同时有效挖掘短模型在特定场景下的高效推理或部署优势,是一次推理模型的重要创新。

“Long2Short”训练方案在算力与性能平衡方面实现了成功探索,改变了OpenAI o1以时间换空间的做法(牺牲实际应用时的用户体验来提升性能,这种做法一直存在争议),有业界人士表示将会是未来新的研究方向。

而从更宏观的视角看,这样的创新,除了给Kimi带来更亮眼的模型表现,毫无疑问也在让大模型“蒸汽机”的“瓦特时刻”变得越来越近。

03

更密集的突破,才能争抢“瓦特”

Kimi k1.5的出现显然不会是一蹴而就的,是多次进化迭代的结果,但最令人关注的,是迭代的速度。

仅仅在三个月前的2024年11月,月之暗面就推出了初代版本的Kimi K0-math。过了1个月,k1视觉思考模型诞生,继承了K0-math的数学能力,又成功解锁了视觉理解能力,“会算”+“会看”。紧接着又1个月后,也就是这次的K1.5发布,在数理化、代码、通用等多个领域中,刷新了SOTA,直接媲美世界顶尖模型。

三个月三次突破,密集创新迭代才带来炸场的效果与成果。

在关键的历史节点,业界期待“瓦特”,与此同时,业界也在争当“瓦特”,大模型只会越来越卷。

就在中国双子星炸场后,美国总统特朗普宣布OpenAI、甲骨文和软银将联合推进一项称之为Stargate(星际之门)的项目,要在人工智能基础设施领域投资至少5000亿美元,大国AI竞争已经白热化。

好在,无论是基础设施的建设,还是以中国双子星为代表的模型能力建设,中国都已经抢占了先机,这一次不会再处于被动地位——在Kimi的规划中,其将继续发力多模态推理,快速迭代出更多模特、更多领域、更具备通用能力的Kn系列模型。

相信,大模型的“瓦特时刻”,同样会是中国大模型赢得话语权的时刻。