对人类而言,沟通至关重要。然而,全球有数以万计的人因脑损伤而无法实现正常交流。

脑损伤是指脑组织的异常,可由神经系统疾病或创伤性脑损伤(TBI)引起,导致各种神经功能缺损。此前发表在《柳叶刀神经病学》的研究显示,2021 年 全球有超过 30 亿人患有神经系统疾病 ,如中风、阿尔兹海默症、脑膜炎、癫痫和自闭症谱系障碍等。此外,全球每年也约有 6900 万人遭受着因道路交通事故等导致的创伤性脑损伤。

能否“修复”损伤的大脑,对于改善人类的日常生活和工作至关重要,且意义重大。

今天,Meta 公布了两项重磅研究,他们联合认知科学和神经科学顶尖研究机构巴斯克认知、大脑和语言中心(BCBL), 采用非侵入式方法利用 AI 解码大脑语言、并进一步理解人类大脑如何形成语言 。这两项突破性的研究成果也 使得高级机器智能 (Advanced Machine Intelligence, AMI) 更加接近实现 。

据介绍,第一项研究成功地通过非侵入式方法解码了脑部活动中句子的生成,准确 解码了多达 80% 的字符 ,也就是说可以完全通过大脑信号重建想表达的完整句子;第二项研究则详细介绍了 AI 如何帮助理解这些大脑信号,并 阐明大脑如何有效地将思想转化为一连串的文字 。

这不仅有助于帮助无法沟通的患者恢复语言能力,也帮助科学家加深对大脑处理语言和认知过程的理解,推动精度更高、更安全可靠的 脑机接口(BCI)的开发 。

01 从大脑活动到文本输出:依靠非侵入式方法解码

目前的方法表明,可以通过神经假体向 AI 解码器输入指令信号来恢复交流。然而,当前的立体定向脑电图和皮层脑电图等侵入式脑记录技术需要神经外科干预,且难以推广,非侵入式方法又通常受到其记录信号的噪声复杂性的限制。

在 第一项研究中 ,Meta 团队提出了一种非侵入式方法来解码大脑活动中的句子生成,并在 35 名脑部状态健康的志愿者中证明了其有效性。

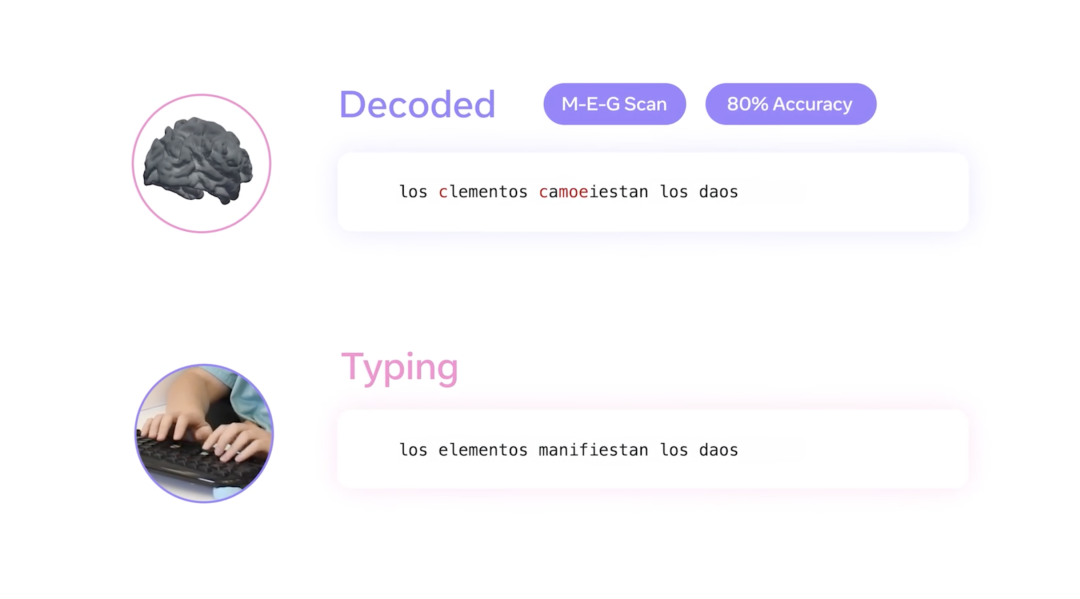

他们 训练了一个新的 AI 模型 ,可以解码来自脑电图(EEG)或脑磁图(MEG)的句子 ,参与者则在 QWERTY 键盘上输入简短的句子。该 AI 模型可以解码参与者用 MEG 记录输入的多达 80% 的字符,平均字符错误率(CER)为 32% ,大大优于传统的 EEG(CER:67%)。对于表现最佳的参与者,该模型实现了 19% 的 CER,并且可以完美解码训练集之外的各种句子。

具体实验设计如下:

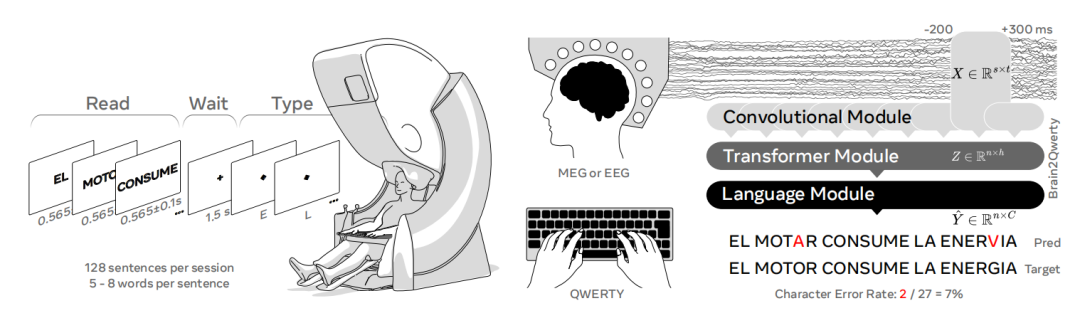

参与者坐在投影屏幕前,MEG 和 EEG 分别距离眼睛 100 厘米和 70 厘米,键盘放在一个稳定的平台上。M/EEG 传感器与键盘之间的距离为 70 厘米,确保参与者能以自然的姿势打字。 每次实验包括三个步骤:阅读、等待、键入 。

图|键入实验设计

首先,准备好的句子在参与者面前的屏幕上逐词显示,以黑色大写字体呈现在 50% 灰色背景上,持续时间在 465 至 665 毫秒之间,单词之间没有间隔。其次,在每个句子的最后一个单词消失后,屏幕上会显示一个黑色的固定十字,持续 1.5 秒,参与者被要求在 1.5 秒内记住这个句子。当十字从屏幕上消失后, 参与者开始凭记忆输入句子 。

在打字过程中,屏幕上不会显示任何字母,但有最低限度的视觉反馈,即每按一次键,屏幕中央的黑色小方块就顺时针旋转 10 度,有助于在不呈现按键输入的情况下发出成功按键的信号,从而确保参与者最小化眼球运动。

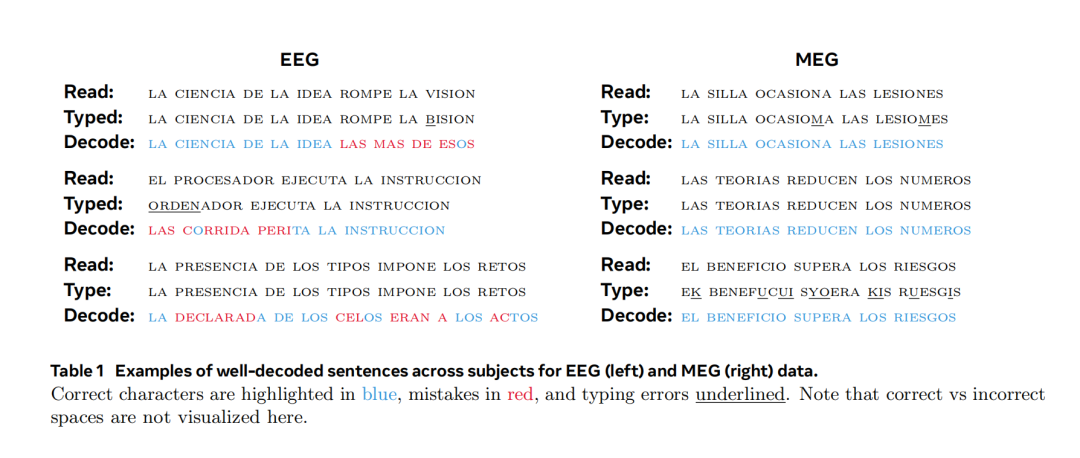

参与者尽可能准确地键入句子,不使用空格纠错,同时将注意力集中在屏幕中央,使用大写字母且不带重音。每次测试包括 128 个不重复的陈述性句子(西班牙语),每句话包含 5 到 8 个单词,由定语、名词、形容词、介词和动词组成。在 EEG 中,参与者共输入了 4000 个句子和 146000 个字符;在 MEG 中,共输入了 5100 个句子和 193000 个字符。

接下来,他们对深度学习架构 Brain2Qwerty 进行了训练,以解码这些 M/EEG 信号中的单个字符 。Brain2Qwerty 则通过三个核心阶段从大脑活动中解码文本:(1) 一个卷积模块(convolutional module),输入的是 500 毫秒窗口的 M/EEG 信号;(2)一个在句子层面上训练的 transformer 模块(3)一个预训练的语言模型 ,用来纠正 transformer 模块的输出。性能评估使用的是句子层面的 CER。

图|参与者输入与基于 MEG 解码的文本结果(标红为错误部分)

他们评估了平均字符错误率 ,结果显示,Brain2Qwerty 在 MEG 和 EEG 上的错误率分别为 32±0.6% 和 67±1.5% ,反映了不同记录设备之间的巨大差异,表现最好和最差的 EEG 受试者在不同句子中的 CER 分别为 61±2.0% 和 71±2.3%,表现最好和最差的 MEG 受试者在各句子中的 CER 分别为 19±1.1% 和 45±1.2%。

图|解码表现较好的 EEG 和 MEG 文本对比,正确解码字符标为蓝色,错误为红色

那么,相比于经典的基线架构,Brain2Qwerty 的性能如何呢?

为了解决这个问题,他们 用同样的方法训练了线性模型和 EEGNet(一种用于脑机接口技术的流行架构) ,并通过跨受试者的 Wilcoxon 检验比较了它们与 Brain2Qwerty 的解码性能。就 MEG 而言,EEGNet 在手误率(HER)(p=0.008) 和 CER (p<10-4) 方面均优于线性模型,但就 EEG 而言,EEGNet 仅在 HER 方面优于线性模型(p=0.03)。然而, EEGNet 的效果仍然不如 Brain2Qwerty ,相比之下,Brain2Qwerty 在 EEG 和 MEG 的 CER 上分别提高了 1.14 倍和 2.25 倍。

该项研究结果表明,侵入式和非侵入式方法之间的差距缩小,这也为开发安全的脑机接口开辟了道路。

02 从思想到语言的转化:层次化的表征生成

第二项研究旨在理解协调 人类大脑语言生成的神经机制 。

研究说话时的大脑活动对神经科学来说一直极具挑战性,部分原因是存在一个简单的技术问题:移动嘴巴和舌头会严重干扰神经成像信号。

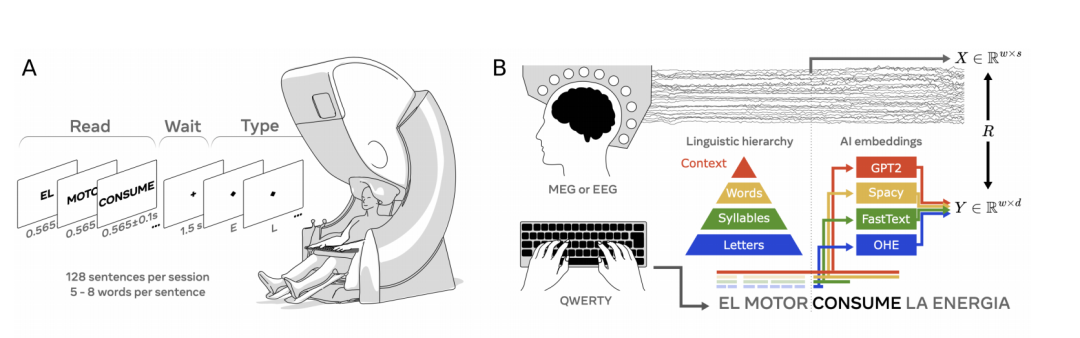

为了探索大脑如何将想法转化为复杂的运动动作序列,Meta 团队使用 AI 帮助解释参与者输入句子时的 MEG 信号。 通过每秒拍摄 1000 张大脑快照,他们能够精确定位思想转化为单词、音节甚至单个字母的准确时刻。

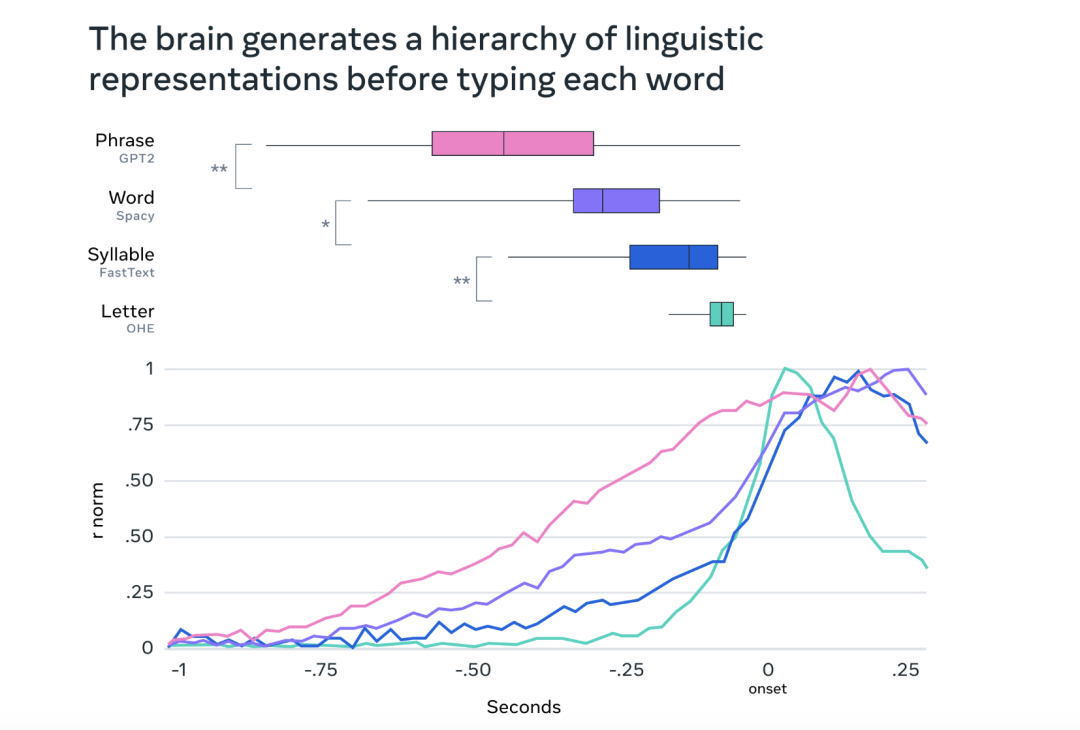

这一研究建立在第一项研究的输入句子实验基础上,为了研究大脑何时以及是否会产生语言表征的层次结构, 他们从这些信号(X)线性解码了四个层次表征的向量嵌入(Y) :上下文词嵌入(使用 GPT-2),去上下文词嵌入(使用 Spacy),音节嵌入(使用 FastText)以及字母(使用 One-Hot-Encoder,OHE),使用皮尔逊相关系数评估解码性能。

图|左为实验设计,右为解码层次

研究结果表明, 大脑在产生语言时采用层次化的过程,首先生成上下文表征,然后依次生成词汇、音节和字母表征 ,证实了语言理论的层次预测:大脑会产生一系列表征,产生每个单词之前的神经活动以上下文、单词、音节和字母级表征的连续上升和下降为标志,并 逐渐将它们转化为无数的动作 ,例如键盘上的实际手指运动。

此外,这项研究还揭示了大脑如何连贯而同时地表达连续的单词和动作。研究结果表明,大脑 使用一种“动态神经代码” ——一种特殊的神经机制,它可以 链接连续的表达 ,同时在很长一段时间内保持每个表达。

图 | 输入每个单词前大脑产生的语言表征层次

然而,Meta 团队也表示,这些研究也存在一些局限性。

例如,当前的 解码性能仍不够完善 ,线性解码算法可能无法捕捉大脑活动的复杂性,需要更复杂的解码算法;且还不适用于实时解码,需要开发实时架构。在实用层面上,MEG 要求受试者处于磁屏蔽室中并保持静止。此外,使用打字任务来探究语言产生的神经机制,可能无法完全反映自然语言产生的神经机制,研究也主要在健康的参与者中进行, 还需要进一步研究在脑损伤患者中的适用性 。

03 催生“无障碍交互”新范式

交流是人类活动的重要内容,用技术解决交流能力失去或缺陷的问题,一直是科技先驱关注的前沿。

近年来,全球脑机接口技术正在快速跨越科幻与现实的边界。例如,侵入式脑机接口技术已在运动控制和语言解码等方面取得突破,马斯克的 Neuralink 公司利用 Link 芯片,使瘫痪患者能以意念操控机械臂完成复杂动作;而脑机接口与 AR/VR 融合的多模态交互技术也在不断发展,Synchron 公司通过脑机接口操控 Apple Vision Pro 的案例,为消费级应用带来了无限遐想。同时, 非侵入式脑机接口技术因无需手术、低风险的特点,更适合大规模应用 ,也取得了显著进步。

此外,AI 模型的引入有望彻底提升解码效率和优化医疗决策, 未来或能借助 LLM 实时解析脑电信号,将零散的神经活动转化为连贯语言 ,甚至实现与外部 AI 系统的直接交互,从而 催生“无障碍交互”新范式 。

对此,你怎么看呢?