段永平宣布:我准备买英伟达了,AI值得关注,英伟达很不错(附英伟达分析师会议记录)

炒股就看金麒麟分析师研报,权威,专业,及时,全面,助您挖掘潜力主题机会!

在纠结了一段时间看不懂英伟达未来十年的竞争力之后,投资家段永平还是决定尝试性买入了。

在英伟达发布2024年四季度财报之后,段永平今早在雪球网表示:“尽管没完全看懂NVDA(英伟达),但我还是准备开始卖点NVDA的put了。AI值得关注,NVDA其实是个很不错的公司。”

稍早前,美东时间2月26日盘后,英伟达发布了2025财年第四季度财报(截至2025年1月26日),成绩超过华尔街预期。

财报显示,英伟达第四财季总营收达到393.31亿美元,同比增长78%;净利润为220.66亿美元,同比增长72%。全年来看,英伟达全年实现营收1304.97亿美元,同比增长114%;净利润达728.80亿美元,同比增长145%。

英伟达掌门黄仁勋在财报中表示,市场对Blackwell芯片的需求令人惊叹,因为推理AI增加了另一种扩展法则——增加训练的计算能力使模型更智能,而长时间思考的额外算力使答案更智能。

公司成功地大规模推进了Blackwell AI超级计算机的生产,在其首个季度实现了数十亿美元的销售额。随着代理AI和物理AI为下一波AI的到来铺平道路,AI正以光速发展,并有望彻底改变最大型的行业。

2月26日收盘后,英伟达股价上涨3.67%,报收131.28美元/股,市值3.22万亿美元。

段永平所说的卖出put,表达的是对英伟达股票价格不会大幅下跌的预期。

所谓卖出put,Put的卖方一旦收取买方支付的权利金,就必须承诺:如果买方选择行权(在到期日或之前),你需按执行价买入标的股票。

我们先来看段永平的观点,再来看当晚英伟达分析师会议的内容,最后再请DS用通俗的语言,科普一下美股卖出PUT的含义。

提醒一下,本文的初衷只是了解一下行业和未来,绝对不是推荐股票,没有独立思考能力的人勿入!

一、段永平谈英伟达

段永平:NVDA很难看懂的并不是短期的增长,而是长期的护城河到底是什么。10年后的NVDA肯定还在,但还是目前的市场地位吗?

评论区:能不能解释得再细一点,段总?是以会有更强的竞争对手比如amd,国产gpu?还是说以后核显越来越强,私人家用足以,分抢走一部分独显市场?还是说ds出现,显卡算力市场并不需要那么大?

段永平: 我没啥可解释的。我说的是我看不懂。未来算力的需求肯定是会继续增长的,算力的供应包括DS(deepseek)这种效率提高,也大概率是会继续增长的。

NVDA目前的毛利率巨高,因为各大厂都不敢不买算力。同时,各有钱的大厂肯定是不心甘一直这么高的价钱去买算力的。

这么多有钱的企业,搞个三五年难道还不能搞出点名堂来?总感觉NVDA的MOAT(护城河)不是那么牢不可破,但这确实不是我能力圈内的东西。

段永平: 我知道目前NVDA的护城河是CUDA,也知道CUDA的生态有点像苹果。

(注:CUDA是 NVIDIA 发明的一种并行计算平台和编程模型,它通过利用图形处理器 (GPU) 的处理能力,可大幅提升计算性能。)

我也早就看到黄(仁勋)说的,目前别的芯片白给都比NVDA提供的方案贵,也看到黄说的10年后算力会是百万倍的增长。但10年后就不能有别的替代方案吗?

特别说明一下,我在这里不是表示质疑NVDA,而是表示对NVDA有兴趣,想努力看看能不能看懂,NVDA到底是不是可以成为我的投资标的。

我其实跟很多业内人士聊过,甚至当面还听苏姐说过几句,但到目前为止依然一头雾水。看不懂10年真的很难下手。

段永平:跌到137倍pe?大概率还早着呢!

评论区:deepseek不是冲击力算力问题,而是支持非cuda生态的其它厂商芯片。

段永平:这个是关键!但我没看懂是不是真是那么回事。

评论区:传说中的量子计算会不会是一个颠覆性技术?

段永平:没有什么比可控核聚变厉害的了。

段永平::尽管没完全看懂NVDA,但我还是准备开始卖点NVDA的put了。ai值得关注,NVDA其实是个很不错的公司。

评论区:你卖put我来买,泡沫已经太明显。

段永平:你拉倒吧!

评论区:英伟达火了两年,很好奇为什么大道在这个时点关注?特别DS出来后对算力的争议巨大,大道是看见了什么?

段永平:我关注很久了!

二,英伟达分析师会议问答记录

(手工记录,或不准确,请以官方最终发布为准)

Blackwell通用,客户需求惊人

Q1:Jensen(注:英伟达创始人黄仁勋的英文名),既然测试计算和强化学习展现出了如此巨大的潜力,我们显然能看到,训练和推理之间的界限正日益模糊。

这对于未来专门用于推理的集群的潜在发展意味着什么?你认为,这对英伟达公司及其客户的整体影响是怎样的呢?

黄仁勋:我明白你的意思,杰伊。现在存在多种规模扩展方面的损耗情况。

首先是预训练的规模扩展规律,而且这种扩展还会持续下去,因为我们有了多模态数据,并且有了来自推理的数据,这些数据现在正被用于进行预训练。

其次是后训练阶段的规模扩展,通过使用强化学习结合人类反馈、强化学习结合人工智能反馈、强化学习以及可验证的奖励机制,实际上在后训练阶段所使用的计算量比预训练阶段还要高。

从某种意义上来说,这是合理的,因为当你使用强化学习时,可以生成大量的合成数据或者合成生成的标记,

人工智能模型本质上就是在生成标记来训练自身模型,这就是后训练阶段的情况。

第三点,也就是你提到的部分,是测试阶段的计算或者说推理、深度思考以及新的规模扩展方式。它们本质上都是相似的概念。

在这个过程中,你会有一连串的思路,你会进行搜索。所生成的标记数量以及及所需的推理计算量,已经比早期大语言模型仅进行单次示例和单次处理能力时高出了100倍。而这仅仅只是个开始,这才刚刚起步。

未来,下一代模型有可能会达到数千倍的提升,甚至我们希望,那些基于深度思考、模拟和搜索的模型,其计算量可能会比现在高出数十万倍乃至数百万倍。

问题就在于,你要如何设计这样的架构呢?有些模型是自回归模型,有些模型是基于扩散模型的。有时候,你希望数据中心具备分散式推理的能力,有时候又希望它是集中式的。

因此,很难确定数据中心的最佳配置是什么,这也正是英伟达的架构如此受欢迎的原因。我们能运行各种模型,我们擅长训练。实际上,如今我们的计算量中绝大部分都用于推理,而Blackwell(产品)将这一切提升到了一个新的水平。

我们在设计Blackwell时,就考虑到了推理模型的需求。当你看训练方面时,它的性能要高出许多倍。

但真正令人惊叹的是,对于需要深度思考的测试阶段规模扩展推理人工智能模型来说,它的速度要快上数十倍,吞吐量能提高25倍。所以,Blackwel在各个方面都将表现得非常出色。

当你拥有一个数据中心,它能让你根据当前是在进行更多的预训练、后训练还是扩展推理能力来配置和使用数据中心时,我们的架构是通用的,并且很容易以各种不同的方式来使用。

事实上,我们看到,现在比以往任何时候都更倾向于采用统一的架构。

Q2:您是否可以谈谈在国际消费电子展(CES)上提到的GB200,您当时提到了机架级系统的复杂性以及面临的挑战。然后,正如您在事先准备好的发言中所说,我们已经看到GB200在很大程度上实现了通用可用状态。

那么,在扩大生产规模方面,目前进展到什么程度?除了芯片层面的问题,在系统层面上是否仍然存在需要考虑的瓶颈?您对 NVL72 平台是否依然保持着热情?

黄仁勋:对GB200的热情,比在国际消费电子展(CES)时还要高。

原因在于,自国际消费电子展以来,我们已经出货了更多产品。我们有大约350家工厂。这些工厂负责制造用于每个Blackwell机架(即 Grace Blackwell 机架)的150万个组件。

没错,这极其复杂。而我们成功且出色地扩大了Grace Blackwell 的生产规模,上个季度实现了约110亿美元的营收。由于需求相当高,客户急切且迫不及待地想要拿到他们的Blackwel系统,我们将不得不继续扩大生产规模。

你可能在网上看到过,有不少关于GraceBlackwell系统上线的庆祝消息,当然我们也有相关庆祝活动。我们为自己的工程团队、设计团队和软件团队安装了相当数量的GraceBlackwell系统。

Core Weave 公司如今已经相当公开地宣布他们成功启用了该系统。当然,微软、OpenAl也都用上了,而且你开始看到越来越多的系统上线。

所以,我认为,对于你的问题答案是:我们所做的事情没有一件是容易的,但我们进展得很顺利,我们所有的合作伙伴也都进展顺利。

Blackwell毛利率超过70%,还将提升

Q3:科莱特(注:英伟达执行副总裁兼首席财务官),如果你不介意的话,能否确认一下第一季度是否就是毛利率的最低点呢?然后,詹森,我的问题是问你的。在你的(业务监控)仪表盘上有哪些指标让你有信心认为这种强劲的需求能够持续到明年呢?还有,DeepSeek公司以及他们所推出的任何创新成果,有没有在任何方面改变你对这种情况的看法呢?

科莱特:让我先来回答问题中关于毛利率的第一部分内容。

在我们扩大Blackwell产品的生产规模期间,毛利率将处于70%出头的水平。目前,我们正专注于加快生产速度,以确保能够尽快向客户供货。

我们的Blackwell产品正在全面推进量产。哦,抱歉,一旦我们的Blackwell产品全面实现量产,我们就能够降低成本并提高毛利率。所以,我们预计今年晚些时候毛利率可能会达到70%中期的水平。

就像你听到詹森谈到的那些系统及其复杂性,在某些情况下,这些系统是可定制的。它们有多种网络配置选项,还具备液冷和水冷功能。所以我们知道,未来我们有机会提高这些产品的毛利率。但目前,我们将专注于加快生产(此处有听不清的内容),并尽快把产品交付给客户。

黄仁勋:我们清楚一些情况,对于数据中心正在进行的资本投资规模,我们有相当清晰的预期。我们知道,未来绝大多数软件都将基于机器学习。因此,在数据中心中,你会希望采用加速计算、生成式人工智能以及推理式人工智能这类架构。

当然,我们有来自顶级合作伙伴的预测和规划。而且我们也明白,仍有许多极具创新性、令人兴奋的初创企业正在崛起,它们是推动人工智能领域实现下一个重大突破的新机遇,无论是智能体人工智能、推理式人工智能还是物理人工智能--初创企业的数量仍然相当可观,并且它们中的每一家都需要大量的计算基础设施。

我认为,无论是短期信号还是中期信号,短期信号当然包括采购订单和预测之类的东西。中期信号则是与前几年相比基础设施的水平以及资本支出的扩张规模。

而长期信号则基于这样一个事实,即我们从根本上了解到,软件已经从在中央处理器(CPU)上运行的手工编码,转变为在图形处理器(GPU)和加速计算系统上运行的基于机器学习和人工智能的软件,

因此,我们相当清楚这就是软件的未来。当你进一步思考时,换个角度来看,我们实际上只是触及了消费级人工智能、搜索领域以及一定程度的消费级生成式人工智能、广告和推荐系统等,这些还只是软件发展的早期阶段。

下一波浪潮即将到来,包括面向企业的智能体人工智能、用于机器人技术的物理人工智能,以及随着不同地区为自身生态系统构建人工智能而出现的主权人工智能。

而这些领域几乎都才刚刚起步,并且我们能够预见到它们的发展。我们能够预见到,是因为显然我们处于这些发展的核心位置,我们能看到在所有这些不同领域都在发生着巨大的活动,而且这些都会成为现实。所以,无论是短期、中期还是长期,都是如此。

Blackwell Ultra产品将在下半年推出

可以顺利衔接Blackwell产品

Q4:你们的下一代Blackwell Ultra产品预计将于今年下半年推出,这与团队的年度产品发布节奏相符。詹森,鉴于你们目前仍在扩大现有一代Blackwel 解决方案的生产规模,你能否帮我们了解一下市场对Blackwell Ultra产品的需求动态呢?你们的客户和供应链又将如何同时应对这两款产品的生产规模扩大呢?

另外,团队在今年下半年推出Blackwell Ultra产品的计划是否仍按原计划推进?

黄仁勋:是的。Blackwell Ultra产品将在下半年推出。

如你所知,第一代Blackwell产品推出时我们遇到了一点小波折,这可能让我们延误了几个月的时间。当然,我们已经完全恢复了。

团队在恢复生产方面做得非常出色,我们所有的供应链合作伙伴以及众多人士都以极快的速度帮助我们实现了恢复。所以现在我们已经成功扩大了Blackwell产品的生产规模。

但这并不会让后续的产品计划停滞。后续产品是按照年度节奏推进的,Blackwell Utra产品将配备新的网络技术、新的内存,当然还有新的处理器,所有这些都将投入使用。

我们一直在与所有的合作伙伴和客户共同努力,规划相关事宜。他们已经掌握了所有必要的信息,我们会与所有人合作,做好恰当的过渡工作。

这次从Blackwell产品过渡到Blackwell Ultra产品,系统架构完全相同。从Hopper产品过渡到Blackwel产品时难度要大得多,因为我们从NVLink 8系统过渡到了基于NDLINK72的系统。所以机箱、系统架构、硬件以及供电系统等所有方面都必须做出改变。这是一次相当具有挑战性的过渡。

但下一次过渡,Blackwell Ultra产品会很顺利地衔接上。我们也已经透露了后续的产品信息,并且一直与所有合作伙伴就之后的产品进行紧密合作。

之后的产品叫做Vera Rubin,我们所有的合作伙伴都在加快了解这款产品的过渡情况,并为此做准备。而且,我们又将带来一次巨大的提升。

所以,来参加GPU技术大会(GTC)吧,我会和你们聊聊Blackwell Ultra和Vera Rubin产品,然后向你们展示我们在这之后的规划。会有非常令人兴奋的新产品,所以一定要来参加GTC大会。

Q5:我们听说了很多关于定制专用集成电路(ASIC)的事情。你能谈谈客户定制 ASIC 和商用图形处理单元(GPU)之间的平衡问题吗?

我们听说了一些使用GPU和ASIC的异构超级集群,这是客户计划构建的吗?还是说这些基础设施仍会保持相当的独立性?

黄仁勋:我们所打造的产品与专用集成电路(ASIC)有很大不同,在某些方面甚至截然不同,不过在一些领域也有交集。我们在几个方面存在差异。

首先,英伟达(NV)的架构具有通用性,无论你是针对非激进型模型、基于扩散的模型、基于视觉的模型,还是多模态文本模型进行优化,我们的架构在所有这些方面都表现出色。

我们在各个方面都表现卓越,因为我们的软件堆栈非常出色--我们的架构设计合理,软件堆栈生态系统极为丰富,以至于我们成为了大多数令人兴奋的创新和算法的初始目标。

从定义上来说,我们的通用性远远超过了专用性。从端到端的流程来看,我们也非常出色,从数据处理、训练数据的管理,到数据训练,当然还包括后训练中使用的强化学习,一直到在严格的时间尺度下进行推理,我们都游刃有余。

我们具有通用性,能实现端到端的处理,并且应用广泛。因为我们不局限于某一个云平台,而是存在于所有云平台中,我们也可以在本地部署,甚至可以应用于机器人中。我们的架构更容易获取对于任何新成立的公司来说,都是绝佳的初始目标。所以我们无处不在。

我要说的第三点是,我们的性能提升节奏非常快。要记住,这些数据中心的规模往往是固定的,或者其功率是固定的。如果我们的每瓦性能达到2倍、4倍甚至8倍(这并不罕见),这将直接转化为收入。

所以,如果你有一个100兆瓦的大型数据中心,如果在这个100兆瓦的数据中心里,性能或吞吐量提高了4倍或8倍,那么这个数据中心的收入也会相应提高8倍。

这与过去的数据中心如此不同的原因在于,人工智能工厂可以通过生成的标记直接实现货币化。因此,我们架构的标记处理吞吐量如此之快,对于所有出于创收目的而构建这些设施并追求快速投资回报率的公司来说,具有极高的价值。所以我认为第三个原因就是性能。

最后我想说的是,软件堆栈的构建难度极大。打造一款专用集成电路(ASIC)和我们所做的事情并无不同。我们构建了一种新的架构,而如今基于我们架构之上的生态系统比两年前复杂了10倍。

这一点相当明显,因为全球基于我们架构所开发的软件数量正在呈指数级增长,而且人工智能的发展速度非常快,要在多个芯片之上构建起整个生态系统是很困难的。

所以我认为有这四个原因。

最后,我还要说一点,仅仅设计出芯片并不意味着就能将其部署应用。这种情况屡见不鲜。有很多芯片被制造出来,但到了需要做决策的时候,就必须做出商业决策,而这个商业决策涉及到将一个新的引擎、新的处理器部署到规模、功率和成本都有限的人工智能工厂中。

而我们的技术不仅更加先进、性能更高,还具备更好的软件能力,而且非常重要的是,我们的部署速度极快。大家现在都知道,这些优势对于(在市场竞争中)脱颖而出已经足够了。我们表现出色、能够获胜,是有很多不同原因的。

中国业务占比与之前持平

Q6:你很清晰地解释了需求背后的一些强劲因素。但是美国业务的营收环比增长了大约50亿美元左右。人们可能担心,如果对其他地区实施监管措施,美国业务是否能够弥补可能出现的缺口。

我想知道,在这一整年里,如果美国业务的这种增长势头持续下去,是否可行呢?而且如果美国业务的增长是你公司增长率的支撑,在业务结构向美国倾斜的情况下,你该如何保持如此快速的增长?

从业务指引来看,中国业务的营收可能会环比增长。你能否详细阐述一下这种变化态势,或许科莱特也可以发表一下看法。

黄仁勋:中国业务的占比与第四季度以及之前几个季度大致相同。目前的规模大约是实施出口管制之前的一半,但占比大致保持不变。

关于地域方面,关键要点在于,人工智能是一种软件,是现代软件。它是令人惊叹的现代软件,而且人工智能已经成为主流。人工智能被广泛应用于名地的配送服务、购物服务中。如果你订购一份牛奶并配送到家,这其中就有人工智能的参与。

所以,几乎所有消费者服务的中心,都有人工智能的存在。

每个学生都会把人工智能当作辅导老师,医疗保健服务使用人工智能,金融服务也使用人工智能。没有哪家金融科技公司会不使用人工智能,实际上,每家金融科技公司都会用到。气候科技公司使用人工智能,现在矿产勘探也用到了人工智能。

在高等教育领域,每一所大学都在使用人工智能所以可以很肯定地说,人工智能已经成为主流,并且正被融入到每一种应用当中。

当然,我们希望这项技术能够继续安全地发展,并以对社会有益的方式进步。

基于此,我确实认为,我们正处在这一全新转型的开端。我所说的开端是指,要知道,在我们身后是几十年来建成的数据中心和计算机,而它们是为一个以手工编码、通用计算以及中央处理器(CPU)等为主的世界而构建的。

展望未来,可以很肯定地说,这个世界几乎所有的软件都将融入人工智能。所有的软件和服务最终都将基于机器学习,数据飞飞轮将成为改进软件和服务的一部分,而且未来的计算机将是经过加速的,未来的计算机将基于人工智能。

我们实际上才刚刚踏上这段旅程两年时间,而要让经过几十年才建成的计算机实现现代化。所以我相当确定,我们正处于这个新时代的开端。

最后,从来没有任何一项技术有机会像人工智能这样,影响到全球国内生产总值(GDP)中如此大的比重,也没有任何一款软件工具能够做到。

所以,现在人工智能作为一种软件工具,能够影响到全球GDP中比历史上任何时期都更大的比重。因此,我们思考增长的方式,以及判断某事物规模大小的方式,都必须放在这样的背景下来考量。

当你退一步,从这个角度来看待问题时,就会发现我们真的才刚刚起步。

企业业务的增长更快

Q7:我有一个需要澄清的点和一个问题。先请科莱特来澄清一下。你是不是说,数据中心业务中的企业客户部分,在1月所在的那个季度同比增长了两倍?如果是这样的话,这是否意味着它的增长速度比超大规模数据中心运营商还要快呢?

詹森,我有个问题想问你。超大规模数据中心运营商是你们解决方案的最大买家,但他们购买设备既用于内部工作负载,也用于外部工作负载,而外部工作流程指的是企业所使用的云服务。

我的问题是,你能否让我们了解一下,超大规模数据中心运营商的支出,在外部工作负载和内部工作负载之间是如何分配的?另外,随着这些新的人工智能工作流程应用的出现,你评估,企业在消费组合中所占的比例是否会变得更大?这又是否会影响到你们开发服务以及生态系统的方式呢?

科莱特:是的,企业业务实现了增长,而且增长情况与我们从大型云服务提供商(CSP)那里看到的情况非常相似。

请记住,了解与云服务提供商的合作以及他们在大型语言模型方面的工作,还有他们在自身业务中进行推理的工作,这些都是很重要的方面。

但也要记住,这同样也是企业业务所涉及的领域。企业既与云服务提供商合作,也会自行构建相关业务。这两方面的发展都相当不错。

黄仁勋:云服务提供商(CSP)的业务占我们总业务的大约一半。而且正如你所说,云服务提供商存在内部消费和外部消费。当然,我们的产品被用于他们的内部消费。

我们与所有云服务提供商都紧密合作,以优化他们内部的工作负载。因为他们拥有大量可利用的英伟达设备基础设施。而且我们的产品一方面可用于人工智能,另一方面可用于视频处理,以及像Spark这样的数据处理,具有通用性。

所以我们基础设施的使用寿命要长得多。如果使用寿命更长,那么总体拥有成本(TCO)也会更低。

第二个问题是我们如何看待企业(如果你愿意,也可以说是非云服务提供商的企业)未来的增长情况呢?我的答案是,从长远来看,企业业务的增长规模要大得多。

原因在于,如果你审视当今的计算机行业,那些尚未被行业充分服务的领域在很大程度上是工业领域。

让我举个例子。当我们说到企业时,我们以汽车公司为例,因为汽车公司既生产软件相关的产品,也生产硬件产品。

就拿汽车公司来说,公司的员工群体就是我们所说的企业范畴,我们有智能体人工智能(ageneticAl)、软件规划系统和工具,而且我们在GPU技术大会(GTC)上会有一些非常令人兴奋的成果与大家分享,我们构建智能体系统是为了让员工更高效地进行设计、制定市场计划以及运营公司。这就是智能体人工智能。

另一方面,他们生产的汽车也需要人工智能。他们需要一个人工智能系统来训练汽车,管理这一庞大的汽车车队。

如今,道路上有10亿辆汽车。未来某一天,道路上依然会有10亿辆汽车,而且每一辆汽车都将是自动驾驶汽车,它们都会收集数据,并且我们会通过人工智能工厂来改进它们。

如今,他们有自己的工厂,未来他们将拥有一个汽车工厂和一个人工智能工厂,然后在汽车内部本身就是一个机器人系统。

所以,如你所见,这里涉及到三种计算机。有一种计算机是帮助人们的。还有一种计算机是为机械设备构建人工智能的,当然,这些机械设备可以是拖拉机、割草机。也可以是如今正在研发的人形机器人或其他机器人。还可以是建筑物或仓库,

这些物理系统需要一种新型的人工智能,我们称之为物理人工智能。它们不能仅仅理解单词和语言的含义,还必须理解现实世界的意义、摩擦力和惯性、物体恒存性以及因果关系。

所有这些对我们来说是常识的东西,人工智能却必须去学习这些物理效应。所以我们把这称为物理人工智能。

利用智能体人工智能来彻底改变我们在公司内部的工作方式,这一领域才刚刚起步。现在正是智能体人工智能时代的开端,你也听到很多人在谈论这个话题,而且我们也取得了一些非常出色的进展。

在这之后是物理人工智能领域,再之后是机器人系统领域。所以这三种计算机都是全新的领域。

我的感觉是,从长远来看,这无疑将是一个更大的市场,这也是有一定道理的。世界国内生产总值(GDP)主要由重工业、工业以及为这些行业提供服务的公司所构成。

“不用担心替换周期和毛利率”

Q8:如今,我们即将迎来2023年你所见证的Hopper 架构在通用生成式人工智能领域带来的转折的两周年纪念。当我们思考你所规划的未来路线图时,从替换周期的角度来看,你如何看待已经部署的基础设施呢?

另外,无论是GB300还是那个Rubin系列产品,我们是否开始看到一些设备更新换代的机会呢?你对这方面是怎么看的?

黄仁勋:首先,人们仍在使用 Volta.Pascal和 Ampere 架构的产品。原因在于,由于CUDA的可编程性非常强,所以总会有一些应用场景。

目前, Blackwell的一个主要应用场景就是数据处理和数据整理。

假设你发现了一种情况,某个人工智能模型不太擅长处理SP58765061(可能是特定数据或任务标识?)相关的任务。

你将这种情况呈现给一个视觉语言模型,比如说,这是一个关于汽车的模型,这个视觉语言模型实际上会审视这种情况,并说,“这就是所发生的情况,而且我很擅长处理这个”。

然后,你把这个对提示的回应拿过去,促使另一个人工智能模型在你整个数据池中去寻找类似情况,不管那种情况具体是什么。接着,你使用人工智能进行领域随机化处理,并生成一大堆其他示例。然后基于这些,你就可以去训练模型了。

所以,你可以使用安培架构的产品去进行数据处理、数据整理以及基于机器学习的搜索。然后你创建训练数据集,再将其提供给 Hopper 架构系统用于训练。

而且这些架构中的每一种都是完全… 它们都与CUDA 兼容,所以,所有东西都能相互配合使用。但是如果你已经部署了相关基础设施,你就可以把那些强度较低的工作负载分配到过去已安装的设备上,所有这些都能得到很好的利用。

Q9:我有一个关于毛利率的后续问题要问科莱特,我知道Blackwell产品的良率,以及以太网的组合情况等诸多因素都在变化。

你在之前回答问题时提到过,4月所在的季度是毛利率的最低点,但要达到你所说的本财年末毛利率处于70%中期水平的目标,下半年每个季度的毛利率就得提升大约 200个基点。而且我们对于关税对更广泛的半导体行业的影响仍知之甚少。那么,是什么让你对今年下半年毛利率朝着这个预期走势发展有信心呢?

科莱特:感谢提问。就我们在Blackwel 系统中所整合的材料及其他所有内容而言,我们的毛利率相当复杂,从长期来看,有大量机会从诸多不同方面来更好地提高我们的毛利率。

请记住,我们在布莱克威尔系统上还有许多不同的配置,这将有助于我们做到这一点。所以,在为我们的客户完成一些强劲的产能提升之后,我们就可以一起开展大量相关工作。如果不行的话,我们也会尽可能尽快开始。

如果我们能在短期内提升(毛利率),我们也会这么做。

目前来说,关税情况还不太明朗,在我们进一步了解美国政府的计划,包括时间、地点和幅度之前,它都是个未知数。所以目前我们还在等待,但当然,我们始终会遵守出口管制和/或关税规定。

三美股的卖出put的含义

关于美股的卖出put是什么意思,deepseek是这么回答小雅的:

小雅一问:美股的call和put是什么意思?

ds回答:

在美股市场中,Call(看涨期权)和Put(看跌期权)是两种基础的期权合约,允许投资者在不直接持有股票的情况下押注价格波动或对冲风险。

以下是它们的核心概念和区别:

1. Call(看涨期权)

定义:

买方支付权利金后,有权在到期日或之前,以约定的执行价买入标的股票。卖方则有义务按此价格卖出股票。

适用场景:当投资者看涨某股票(如特斯拉、苹果)时,可通过买入Call押注股价上涨。

收益与风险:

买方:风险有限(最大损失为权利金),潜在收益无限(股价越高,盈利越大)。

卖方:收益有限(赚取权利金),但风险极高(若股价暴涨,需按低价卖出股票)。

举例:

假设苹果股价现为150美元,你买入一份执行价160美元、1个月到期的Call,支付权利金5美元/股。

假设到期时,苹果股价涨至180美元,你可按160美元买入并立即以市价卖出,赚取(180-160-5=15美元/股。

假设到期时,苹果股价未超过160美元,你可以放弃行权,仅损失5美元权利金。

2. Put(看跌期权)

定义:买方支付权利金后,有权在到期日或之前,以执行价卖出标的股票。卖方必须按此价格买入。

适用场景:当投资者看跌某股票(如担心财报暴雷)时,可通过买入Put对冲下跌风险或投机。

-收益与风险:

买方:风险有限(损失仅为权利金),收益取决于股价跌幅(股价跌至0时,收益最大)。

卖方:收益固定(权利金),但若股价暴跌,需按高价接盘,可能巨亏。

举例:

假设特斯拉股价现为200美元,你买入一份执行价180美元、1个月到期的Put,支付权利金7美元/股。

若到期时股价跌至150美元,你可按180美元卖出股票,赚取(180-150-7=23美元/股)。

若股价高于180美元,放弃行权,损失7美元权利金。

3. 关键术语对比

4. 期权价格的两部分

内在价值:立即行权可获得的利润。

Call内在价值 = 当前股价 - 执行价(若股价>执行价,否则为0)。

Put内在价值 = 执行价 - 当前股价(若执行价>股价,否则为0)。

时间价值:权利金中超出内在价值的部分,反映股价未来波动的可能性。到期日越远,时间价值越高。

5. 注意事项

美式 vs 欧式期权:美股期权多为美式,可在到期前任何时间行权;欧式仅限到期日行权。

高杠杆风险:期权自带杠杆,收益放大,但亏损也可能快速发生,尤其是卖方。

流动性:优先选择交易量大、买卖价差小的期权合约,避免难以平仓。

总结:Call和Put是投资者应对市场波动的工具,Call用于押注上涨,Put用于防范下跌或做空。买方适合风险偏好较低者,卖方则需承受高风险以赚取权利金。建议新手从模拟交易开始,并深入学习希腊字母(Delta、Gamma等)以管理风险。

小雅二问:在美股,卖出put是什么意思?

ds回答:

在美股市场中,卖出Put(做空看跌期权)是期权交易中一种常见的策略,通常用于赚取权利金收入或表达对标的股票价格不会大幅下跌的预期。

以下是其核心逻辑、风险和典型应用场景:

1. 卖出Put的定义

义务:作为Put的卖方(义务方),你收取买方支付的权利金,但必须承诺:如果买方选择行权(在到期日或之前),你需按执行价(Strike Price)买入标的股票。

市场预期:

认为股价不会跌破执行价(中性或看涨);

或愿意以执行价接盘股票(相当于“打折买入”)。

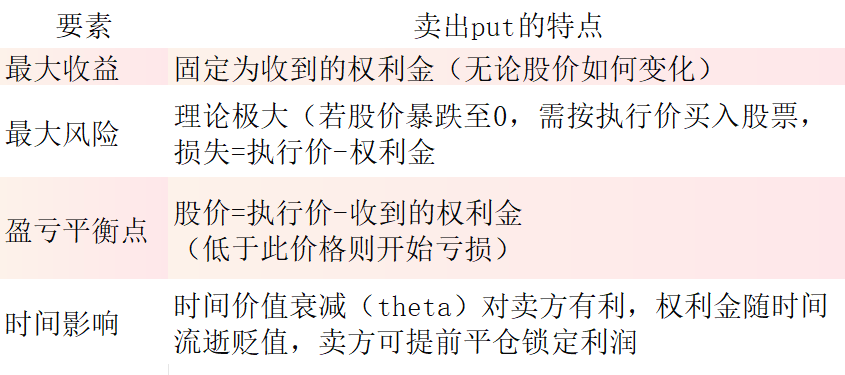

2. 收益与风险

3. 典型应用场景

场景1:赚取权利金(中性市场)

逻辑:认为股价短期内会在执行价上方震荡,不会大幅下跌。通过卖出Put收取权利金,无需实际持有股票。

举例:

当前特斯拉股价200美元,你卖出1份执行价180美元、1个月到期的Put,收取权利金7美元/股。

若到期股价≥180美元,买方放弃行权,你净赚7美元/股。

若股价跌至170美元,你需按180美元买入股票,成本为180 - 7 = 173美元/股(相当于以173美元接盘,低于市价170美元则亏损)。

场景2:低成本买入股票(看涨但等待回调)

逻辑:长期看好某股票,但希望以更低价格买入。卖出Put相当于设定一个“心理买入价”(执行价),若股价未跌至此价则白赚权利金;若跌至此价则按目标价买入。

举例:

想以150美元买入苹果股票(现价160美元),卖出执行价150美元的Put,收取权利金5美元/股。

若股价未跌破150美元,赚取5美元权利金;若跌破,则以150 - 5 = 145美元/股的实际成本买入股票。

场景3:对冲持仓风险(增强收益)

逻辑:持有股票时,卖出Put可额外赚取权利金(需注意风险叠加)。

4. 关键风险与注意事项

强制接盘风险:若股价暴跌,卖方必须按执行价买入股票,可能面临巨额亏损(尤其是高波动标的)。

保证金要求:卖出Put需账户有足够保证金(券商可能要求冻结资金,限制流动性)。

流动性风险:冷门期权可能难以平仓,需持有到期。

心理压力:股价逼近执行价时,需承受是否提前平仓的决策压力。

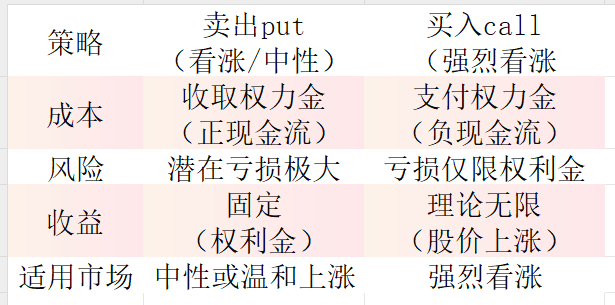

5. 卖出Put vs 买入Call(看涨策略对比)

6. 总结

卖出Put的本质:通过承担“接盘义务”赚取权利金,适合对股价有明确支撑预期的投资者。

优势:无需直接持有股票即可获得收益,或在回调时低成本建仓。

风险警示:潜在亏损远高于收益,需严格管理仓位(避免重仓单一标的)。

新手建议:先通过模拟交易熟悉操作,并学习如何用止损、对冲(如买入更低执行价的Put)控制风险。

再次声明,本公众号文中提到的所有公司,都只是企业经营思考,不涉及公司交易,更不构成任何投资建议和评价。

(转自:投资人记事)

Disclaimer: Investing carries risk. This is not financial advice. The above content should not be regarded as an offer, recommendation, or solicitation on acquiring or disposing of any financial products, any associated discussions, comments, or posts by author or other users should not be considered as such either. It is solely for general information purpose only, which does not consider your own investment objectives, financial situations or needs. TTM assumes no responsibility or warranty for the accuracy and completeness of the information, investors should do their own research and may seek professional advice before investing.

Most Discussed

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10