编译 | 尹非非

编辑 | 云鹏

智东西3月11日消息,全球最大电子产品代工企业富士康(Foxconn)于昨日宣布,该公司已自主研发推出首款繁体中文AI大语言模型FoxBrain。模型现已具备数据分析、决策辅助、文书协作、数学、推理解题与代码生成等功能,后续将对外开源分享。

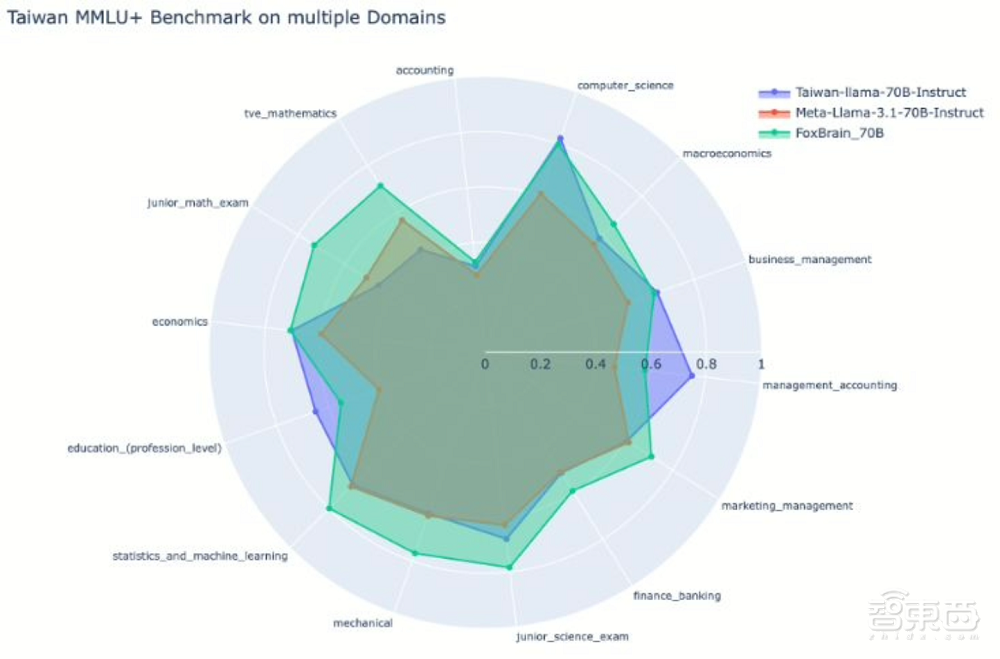

一、历时四周研发,数学能力强,但性能不及DeepSeek蒸馏模型

富士康鸿海研究院人工智能研究所所长栗永徽称,该模型”采用高效训练策略,专注于训练过程优化而非盲目堆砌算力”。在研发过程中,其团队使用120块英伟达H100显卡,耗时约四周完成FoxBrain的训练。

作为苹果公司iPhone主要组装商,富士康已公布FoxBrain部分参数,并表示将在3月中旬英伟达年度技术大会上披露更多细节。该模型基于Meta开放的大语言模型Llama 3.1架构开发,尤其在数学与逻辑推理方面展现卓越能力。但富士康坦言,其模型性能与DeepSeek的蒸馏模型还有些微差距,但已接近世界先进水平。

二、联手英伟达,计划开源

在研发过程中,英伟达(Nvidia)以超级计算机Taipei-1给予其支持,并提供技术咨询,从而确保模型训练成功。而这已经不是富士康和英伟达的第一次合作了,去年,富士康就曾与英伟达联手打造“人工智能工厂”,发展自动驾驶技术。

该公司还表示,FoxBrain模型虽然起源于鸿海研究院为集团内部应用而设计,但计划未来将这一模型开源,与产业伙伴展开合作,并希望FoxBrain能推动制造和供应链管理领域的进步。

三、FoxBrain未来成为智慧应用新引擎

鸿海未来将通过导入AI大型语言模型,优化智能制造、智慧电动车、智慧城市等三大平台的数据分析效率,让FoxBrain成为驱动智慧应用升级的重要引擎,进一步提升公司营运效益。面对电子制造主业因行业变迁和利润率下滑带来的挑战,这家代工巨头正积极向人工智能和电动汽车等领域拓展多元化布局。

结语:垂直自研大模型——富士康撬动产业升级的AI新杠杆

FoxBrain的推出,彰显了富士康作为垂直领域玩家深耕行业场景、布局AI技术的决心。通过优化训练策略与英伟达的算力支持,其能以较低算力成本实现数学推理等专项突破,虽性能略逊于顶尖模型,却更贴合制造、供应链等产业需求。

从内部提效到计划开源,富士康正以AI为杠杆撬动智能制造与电动汽车等新增长极,其“轻量化训练+场景化落地”路径或为传统巨头转型提供范本。随着垂直模型向开源生态渗透,AI与实体经济的融合将迈向深水区。