黄仁勋

凤凰网科技讯 3月24日,商业内幕发文,英伟达首席执行官黄仁勋上周开了一个玩笑,但他的大客户们可能不会觉得好笑。

“我之前说过,当Blackwell开始大量发货时,Hopper就会无人问津了,”黄仁勋在GTC大会上说道。

“在某些情况下,Hopper还是不错的,” 他补充道,“但这种情况不多。”

他所说的是英伟达最新的人工智能芯片和服务器组合——Blackwell。它明显比2022年推出的上一代产品Hopper更好。亚马逊、微软和谷歌等大型云服务公司购买了大量此类GPU系统,用于训练和运行推动生成式人工智能革命的巨型模型。近年来,Meta也在GPU上大肆投入。

这些公司应该会为像Blackwell这样更强大的GPU感到高兴。这对人工智能领域来说通常是个好消息。但也存在一个问题:产品折旧速度越快,对收益的影响就越大。

巴克莱银行的首席科技分析师罗斯・桑德勒周五警告投资者,大型云服务公司和Meta可能不得不做出这些调整,这可能会大幅降低利润。

他写道:“超大规模数据中心运营商可能高估了收益。”

以最大的云服务提供商亚马逊云服务为例。今年2月,它成为了第一个承受痛苦的公司。亚马逊首席财务官布莱恩・奥尔萨夫斯基在上个月的公司收益电话会议上表示,公司“注意到技术发展的速度加快了,特别是在人工智能和机器学习领域”。

奥尔萨夫斯基说:“因此,从2025年1月开始,我们将把部分服务器和网络设备的使用寿命从6年缩短至5年。”他还补充说,这将使今年的运营收入减少约7亿美元。

然后,还有更多坏消息:奥尔萨夫斯基称,亚马逊“提前淘汰”了一些服务器和网络设备,这种“加速折旧”成本约为9.2亿美元,公司预计这将使2025年的运营收入减少约6亿美元。

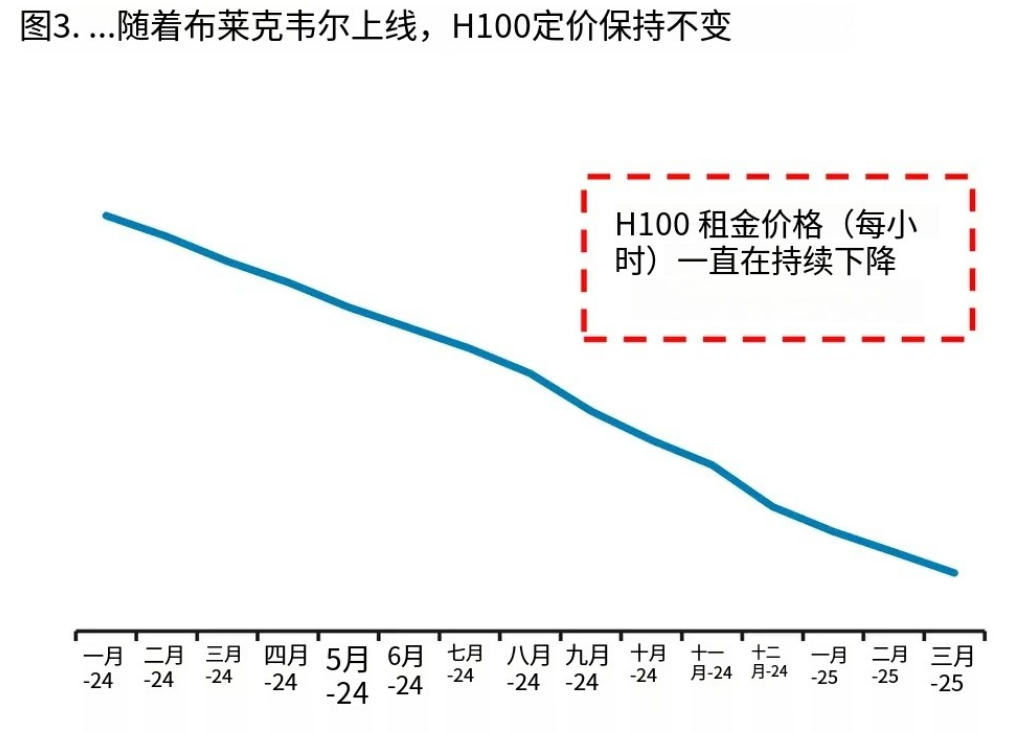

桑德勒在研究报告中附上了一张图表。图表显示了租赁使用英伟达旧版Hopper架构的H100 GPU的成本。可以看到,随着该公司更好的新型Blackwell GPU供应增加,租赁价格已经暴跌。

一张显示英伟达 H100 GPU 租赁成本的图表

桑德勒写道:“这对Meta、谷歌和其他高利润软件公司来说可能是个非常大的问题。”

他估计,对Meta而言,将公司服务器的使用寿命缩短一年,将使2026年的折旧增加50多亿美元,运营收入也会减少类似的金额。

桑德勒估计,对谷歌来说,类似的调整将使运营利润减少35亿美元。

不过,仅仅因为一家大型云服务提供商已经做出了这样的调整,并不意味着其他公司也必须采取完全相同的做法。一些公司可能会以不同的方式设计其人工智能数据中心,从而使英伟达的GPU系统使用寿命更长,或者不那么容易过时。(作者/陈俊熹)

更多一手新闻,欢迎下载凤凰新闻客户端订阅凤凰网科技。想看深度报道,请微信搜索“凤凰网科技”。