最近,AI领域的媒体头条几乎被DeepSeek和Manus占据,投资人和业内意见领袖忙着为这两家公司勾画“从芯片到终端”的上下游蓝图。而在大洋彼岸,另一场风暴正在酝酿——一家之前鲜少被中文媒体提及的新兴公司,悄然在国际巨头的夹缝中撕开一道口子。它既不做大模型,也不造机器人,甚至三个创始人都不是技术背景,然而这家公司在短短三年内让微软、OpenAI和英伟达同时成为自己的客户、盟友与赌注。

这家公司名为CoreWeave。本月它正式向纳斯达克递交招股书,计划募资40亿美元,估值或超350亿美元。而在此之前,其与OpenAI 签订了为期五年、价值 119 亿美元的协议,根据该协议,CoreWeave 将为 OpenAI 提供人工智能基础设施,成为后者逐渐摆脱微软控制的关键一环。此外,CoreWeave手握超过25万张英伟达的GPU,英伟达不仅是其核心供应商,更是其战略股东之一。据CoreWeave招股说明书披露,2024年其营收达19.15亿美元,同比激增736.6%,未履约合同金额高达151亿美元。

如果成功上市,CoreWeave将成为首个以“颠覆者”身份挑战传统云计算巨头的GPU云计算提供商,并自我定位为AI Hyperscaler(超大规模AI算力供应商)。

然而,高速增长的背后,是对英伟达GPU的高度依赖、被大客户微软的业绩绑架,以及沉重的债务压力。如今,AWS、Google、Microsoft等云计算巨头纷纷自研芯片,削弱对英伟达的依赖,而DeepSeek等低成本算力方案的崛起,正在重塑AI算力市场格局。在这样的大环境下,CoreWeave能否借助英伟达的优势构建自己的AI算力帝国,还是会在市场竞争、客户流失、供应链风险和债务重压下轰然倒地?

这不仅关乎CoreWeave的未来,也将深刻影响全球AI算力市场乃至整个AI行业的走向。在微软、OpenAI与英伟达越发复杂的三角关系中,CoreWeave究竟能否颠覆算力格局,实现逆袭,还是最终沦为大厂博弈和资本运作的牺牲品?

出身草莽从挖矿玩家到AI基建狂人

与光鲜的AI研发背景公司不同,CoreWeave的故事则充满草莽色彩。前面提到CoreWeave的三个创始人Michael Intrator、Brian Venturo和Brannin McBee都不是技术出身,他们对什么比较熟——金融,具体来说,大宗商品交易。众所周知,比特币的热潮如同当年加州的淘金热,掀起了全球范围的逐利狂潮,2017年,比特币从1000美元涨到接近20000美元。

CoreWeave“三兄弟”也是当年比特币狂热大军中的一员。据Brian Venturo回忆,2016年他们购入了第一块GPU,并在以太坊网络上成功挖出第一个区块,这一经历让他们踏入了区块链挖矿领域。随着挖矿业务的逐步发展,他们在2017年正式将这一副业转型为公司运营,创立了Atlantic Crypto公司,两年后将其改名为CoreWeave。

CoreWeave的三个创始人:Michael Intrator、Brian Venturo和Brannin McBee

来源:CoreWeave

彼时,以太坊等数字货币的挖矿市场处于高速增长期,GPU矿机需求旺盛,CoreWeave凭借其大规模的GPU集群积累了大量的计算资源,很快就发展成为以太坊一哥,拥有50000个GPU,占据了以太坊网络算力的1%以上。

然而,2018年的币价崩盘让无数矿场破产,也让当时的CoreWeave收入暴跌七成,生死存亡之际,他们嗅到另一条生路——AI训练所需的GPU与矿机硬件高度重合,还有娱乐和生命科学等几个计算量要求比较大的领域可以做备选,当时的AI刚刚起步,算力争夺并不激烈,这时候市场上堆积了大量破产矿工的GPU,收购这些GPU并不贵。

2019年,CoreWeave果断砍掉挖矿业务,将其原本用于挖矿的GPU集群重新配置,主要投向AI云计算和高性能计算,并开始向企业客户提供云端算力租赁服务。这时候不得不提促成CoreWeave这次转型的关键筹码英伟达,后者正急于扩大CUDA生态的商业版图,而CoreWeave承诺批量采购GPU并专注AI任务,双方迅速结成同盟。

原本是“雪中送炭”的合作在ChatGPT爆发后迎来质变,2022年11月ChatGPT的横空出世彻底改变了CoreWeave,也是英伟达的命运爆发。2023年起,全球AI实验室陷入算力饥渴,而传统云厂商的通用服务器难以满足需求——AWS的GPU实例需要多层虚拟化调度,性能损耗高达15%;Azure的自研芯片Maia尚在襁褓。对算力的需求一下将英伟达推到风口浪尖上,也包括CoreWeave,到处是要买他们服务的人。

CoreWeave顺势推出“裸金属GPU(Bare Metal GPU)”服务,绕过虚拟化层,直接将物理GPU服务器租赁给客户。相较传统的云端虚拟GPU实例,该模式不仅提供更强大的计算性能和更低的延迟,还赋予用户对硬件资源的完整掌控。2023年,CoreWeave与英伟达建立深度合作关系,成为A100、H100等高端GPU的核心云端供应商之一。

CoreWeave此时则研制出自己的杀手锏,通过GPU集群和自研软件栈构建,优化AI训练与推理效率,将英伟达GPU的算力利用率榨取到极致,2023年MLPerf基准测试显示,CoreWeave联合英伟达和Inflection AI,利用3,584块H100,用时不到11分钟就能训练出GPT-3 175B模型,训练速度领先第2名29倍。

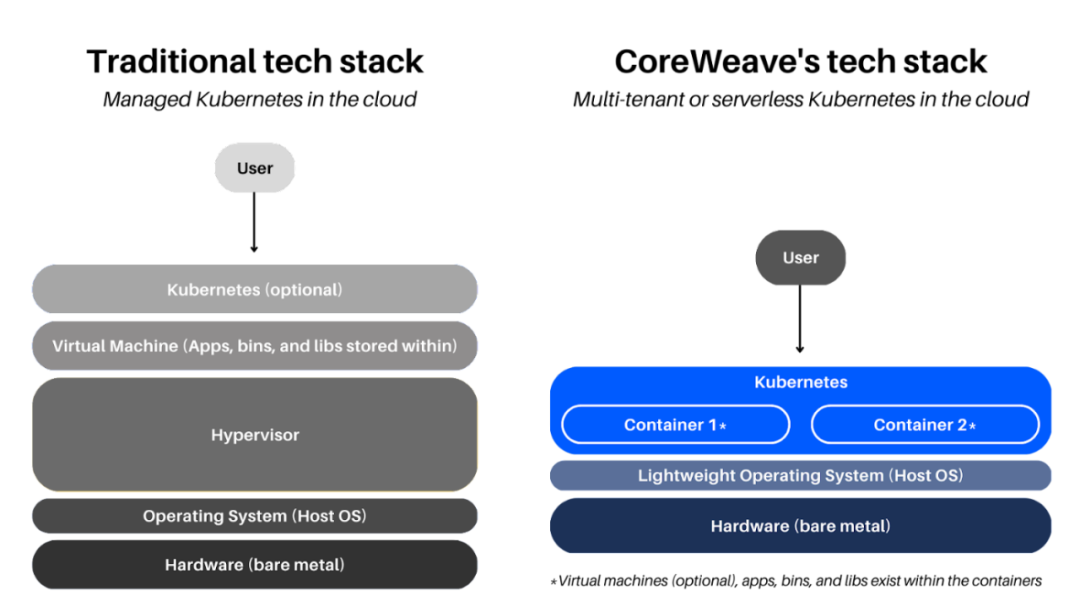

传统与CoreWeave 基础设施比较

来源:CoreWeave官网

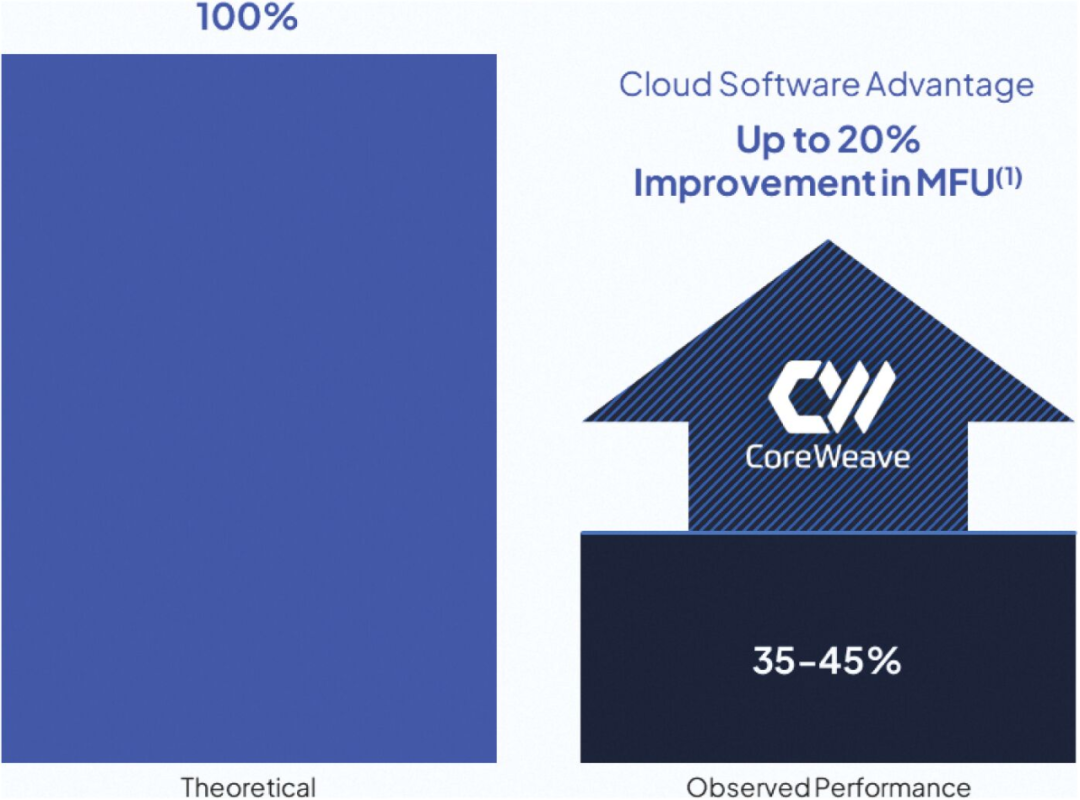

CoreWeave认为,运行AI工作负载的典型GPU的计算效率在峰值理论性能的35%到45%之间,这也是大部分云计算大厂的平均水平,若能将效率缺口从约35%缩小至理论上的100%,将大幅释放AI基础设施的性能潜力,从而推动AI整体质量的蝶变。所以后来CoreWeave在技术上的一系列举措,无论其自研的SUNK 协调系统还是 Tensorizer 优化工具,都围绕着最大限度地提高客户的 GPU 利用率进行,CoreWeave招股书表明,已经比大厂的GPU 利用率提升了20%。

来源:CoreWeave招股说明书

在商业模式上,CoreWeave则以“GPU即服务”(GPUaaS)模式或“人工智能即服务”(AIaaS)模式为核心,结合按需计费和预付款机制,为客户提供灵活性与长期算力保障。前者客户按小时或实例使用时长付费,适用于短期需求,后者收取客户的15%-25%作为预付款,面对需要长期算力保障的大型用户。

目前CoreWeave的大型客户包括微软(一家贡献62%)、英伟达、Meta、IBM、Mistral和Cohere等,此外,CoreWeave的算力服务也逐步渗透到金融、制药等高性能计算需求较高的行业。例如,华尔街量化交易公司Jane Street,以及多个生物制药企业,均依赖CoreWeave的算力支持其模型训练和数据分析。

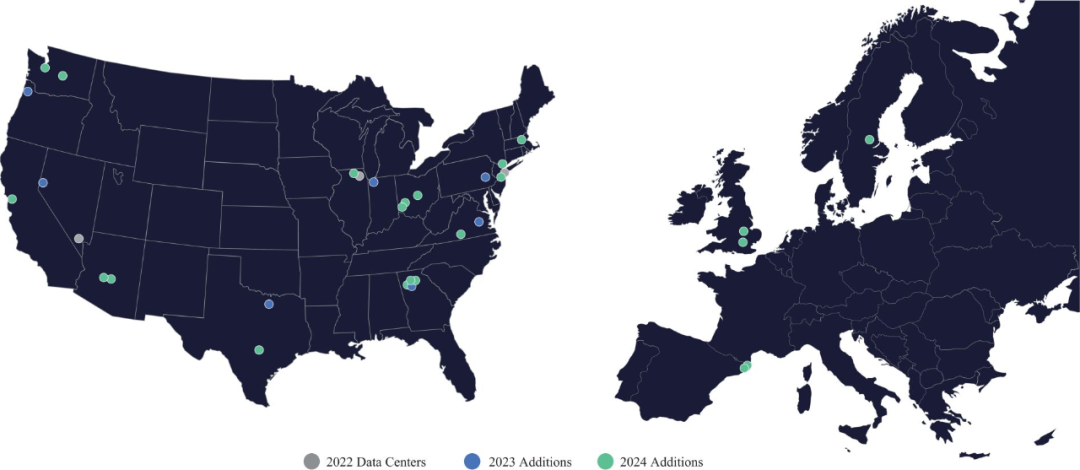

2024年,CoreWeave营收达到19.15亿美元,同比增长736.6%,显示出极强的市场需求。同年,CoreWeave运营的GPU数量超过25万张,并管理着32座数据中心,覆盖全球多个区域,以提供低延迟、高吞吐的算力支持。

在2025年,CoreWeave计划进一步扩大数据中心网络,新增10座数据中心,对于AI算力供应商而言,数据中心的扩张不仅代表着计算能力的提升,也直接影响客户的服务质量和算力成本,随着全球AI训练任务的规模不断增长,数据中心的算力密度成为企业竞争的关键要素。此外CoreWeave总签约电力达1.3GW,将提供长期可持续的能源支持。

Coreweave从数字基础设施提供商Core Scientific租用了16兆瓦的数据中心空间

来源:https://www.datacenterdynamics.com/en/news/coreweave-to-lease-16mw-of-data-center-space-from-cryptominer-core-scientific/

时势造英雄从幕后角色被推向AI算力革命前线

CoreWeave从“闷声发大财”到备受市场瞩目,表面是一个新兴GPU云计算供应商的出圈案例,实质则折射出近半年来AI算力市场格局的动荡与变革。

过去十多年,云计算市场由几大巨头主导,它们掌控全球大部分算力资源,并依托强大的基础设施优势建立竞争壁垒。AI兴起后,这些巨头与英伟达及大模型企业紧密合作,共同推动产业发展,使市场规模迅速扩大,企业市值也屡创新高。

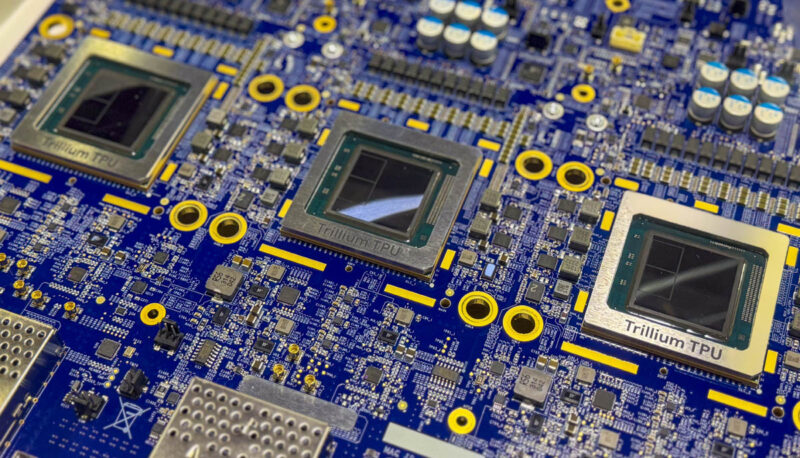

然而,随着AI算力需求从爆发式增长转向长期化,传统云厂商开始加速构建自有AI生态,削弱对英伟达的依赖。AWS推出Bedrock平台,并自研Inferentia和Trainium芯片;Google则从Gemini大模型到Trillium TPU芯片全面走向自研。该趋势不仅挑战了英伟达与头部AI企业的原有生态关系,也让算力市场的竞争进一步加剧。

Google Trillium TPU芯片:Google Cloud TPU V6e Trillium 3

来源:Servethehome,Google

微软与OpenAI从紧密合作走向竞争的转变更为典型。微软持有OpenAI约49%的股权,并享有高达75%的利润分成,原本在技术和资本层面深度绑定,关系看似稳固。然而,如今双方正在逐步疏远,并彼此加大防备力度。据报道,OpenAI拒绝向微软透露核心技术,而微软则在2024年启动自研大模型项目“MAI”,并从著名独角兽公司Inflection AI大规模挖角,包括联合创始人Mustafa Suleyman,他随后出任微软AI总负责人,直接向微软CEO汇报。

进入2025年,随着特朗普上任启动“星际之门计划”(Stargate Project),OpenAI加速推动自身算力独立化,比如与Oracle和Crusoe合作,在得克萨斯州阿比林市建设新的计算中心,预计到2030年,该项目或将满足OpenAI 75%的算力需求。

位于得克萨斯州的阿比林数据中心

来源:Crusoe

CoreWeave正是利用这一点,将自己定位为“中立”的算力提供商,专注于基础设施层面的GPU算力,既不倾向微软,也不倾向于像OpenAI这样的AI模型公司。理论上,它可以成为所有AI公司值得信赖的算力合作伙伴,而无需担心被云厂商兼竞争对手挖走市场。

这种中立性,让CoreWeave可以“两头做生意”,一方面,它在去年与微软达成了一份高达170亿美元的长期合同,为其提供2023年至2030年的GPU服务器租赁服务;另一方面,今年CoreWeave又与OpenAI达成近119亿美元的五年期合作协议,并计划进一步入股。类似的大厂客户还有Meta和Mistral,在竞争激烈的AI算力市场,CoreWeave反倒左右逢源起来。

我们知道,CoreWeave能够快速崛起,更离不开与英伟达的深度合作。由于CoreWeave作为英伟达战略上深度绑定的合作伙伴,包括约6%的股权,可以优先获得最新的GPU资源,如Blackwell架构的GPU,不仅如此,双方还在技术支持和资源整合方面进行深度协作,这种合作包括英伟达为CoreWeave提供定制版CUDA、专用优化芯片,甚至专属的软件堆栈,确保终端客户能够充分发挥每个GPU的最大效能。

众所周知,英伟达的A100、H100 GPU是训练大模型的关键硬件资源,至今仍面临供不应求的问题,客户往往需要等待很长时间。微软CEO Satya Nadella就曾坦言,之所以使用CoreWeave的产品,实则是因为“来不及了”,需要“紧急获取足够的数据中心资源”。平心而论,租用服务确实要比购买硬件要划算得多,利用CoreWeave提供的云基础设施,可以比自行购买、部署和管理GPU更具成本效益,特别是应对短期或波动性需求。

值得一提的是,GPU云服务提供商这个角色不只是CoreWeave独有的,它的直接竞争对手Lambda Labs亦与英伟达保持密切合作关系,英伟达也投资了这家公司,另外像Cerebras Systems、Nebius Group、Vultr、Paperspace、Vast.ai等公司都是这个赛道的知名玩家。

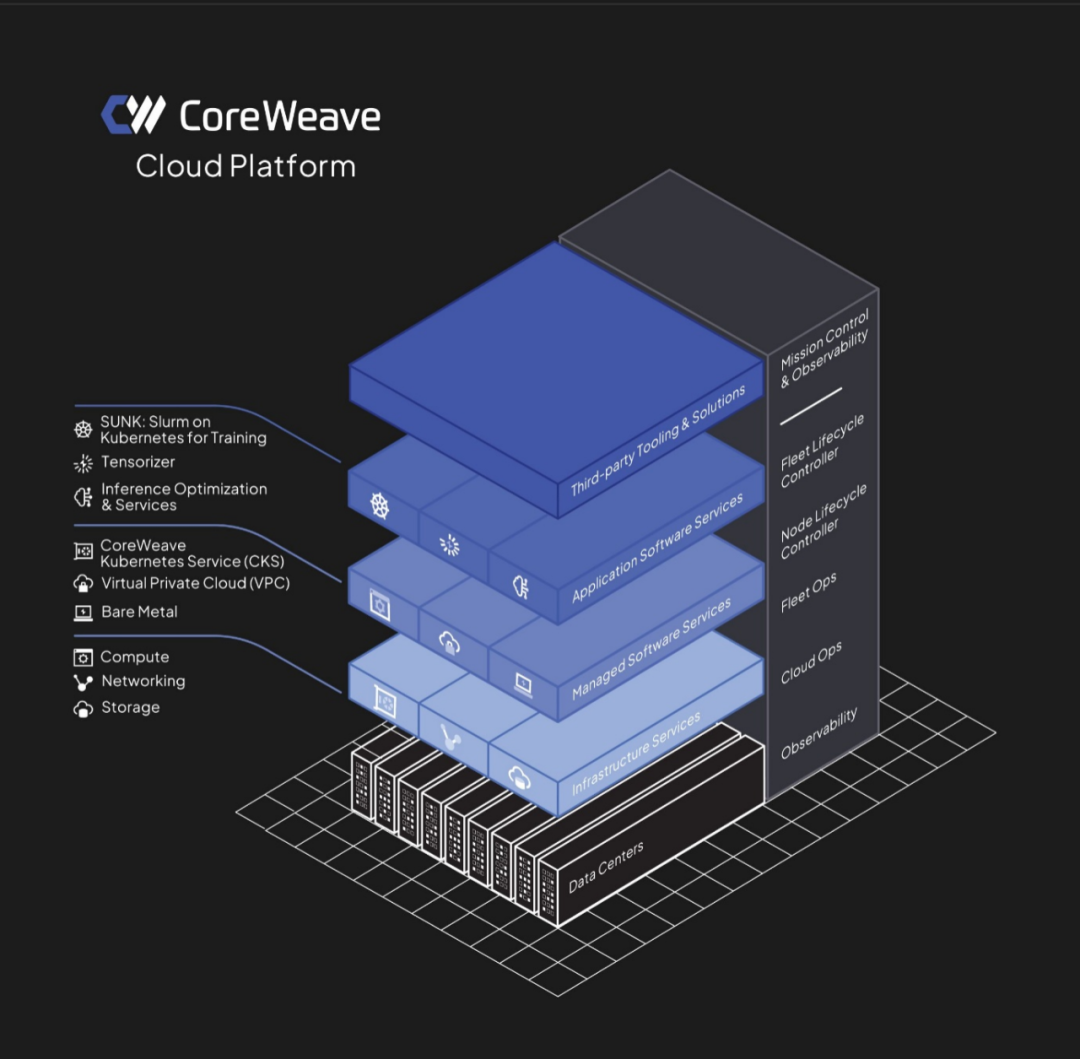

CoreWeave创始人Brannin将GPU云服务比作一个精心编排的大型舞台表演。他强调,CoreWeave的云平台远非简单地提供GPU访问,而是一个复杂而精密的系统,这个系统就像一位经验丰富的舞台导演,协调和管理着庞大的资源和设备网络。

CoreWeave提供接入GPU服务完整的云平台架构

来源:CoreWeave招股说明书

高歌猛进的背后被埋藏了多颗“不定时炸弹”

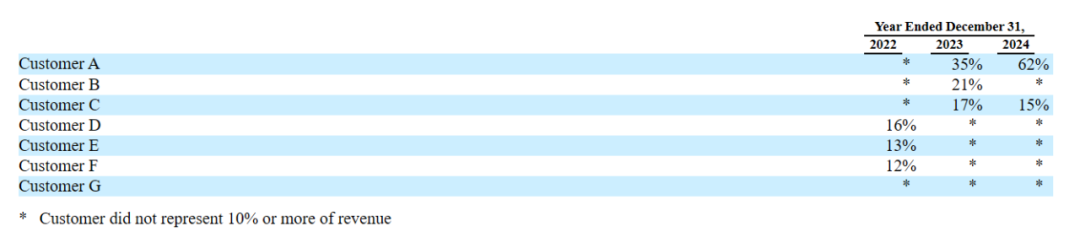

细心的读者可能会发现,我们在讲述CoreWeave上下游链条的时候,提到上游供应几乎全部受到英伟达的影响,而下游卖给微软的销售则占其总收入62%,还有一个它未提及名字的客户,两个客户加起来占总收入的77%,很明显,依赖性非常强。

2022-2024年CoreWeave收入占比超过10%的主要客户列表

来源:CoreWeave招股说明书

让所有人担心的事还是发生了。就在CoreWeave向SEC递交s1文件(招股书)的同一时间,CoreWeave最大客户微软,已撤回部分合作承诺。据英国《金融时报》3月6日报道,由于交货问题和错过最后期限,微软已撤回了(withdraw)部分协议,“这些问题影响了微软对CoreWeave的信心。”

知情人士最近则表示,微软将选择不行使近120亿美元的选择权,拒绝从CoreWeave那里购买更多的数据中心容量,此举为CoreWeave顺利上市蒙上了一层阴影。客观说,CoreWeave交货问题并非仅仅是它自己控制供应链不佳造成的,今年10月,英伟达创始人兼首席执行官黄仁勋承认,其Blackwell芯片存在“设计缺陷”,导致延迟向客户发货。

另据《金融时报》报道,这与微软今年的战略调整有关。Satya Nadella最近表示,微软人工智能基础设施存在“过度建设(overbuild)”。我们看到CoreWeave与OpenAI签订了119亿美元的协议,如果微软过去是给OpenAI下单,而现在OpenAI直接进货,微软本身的MAI实际不需要那么多算力,况且微软现在本身还是OpenAI的股东,意味着OpenAI的采购也会影响到资本回报,这可能就是Satya Nadella所说的“过度建设”,也就是重复下单。

我们再回过来看CoreWeave,一旦影响到营收占比62%-77%的大客户变动,都会对CoreWeave构成重大冲击。CoreWeave已与英伟达达成明确的采购协议,当前库存已超25万张GPU,并计划今年进一步扩充。如果大客户出现风吹草动,而其他客户的租赁需求无法填补这一缺口,那么这些高端GPU将面临与传统商品相同的困境——库存积压,进而影响资金回流与运营效率。

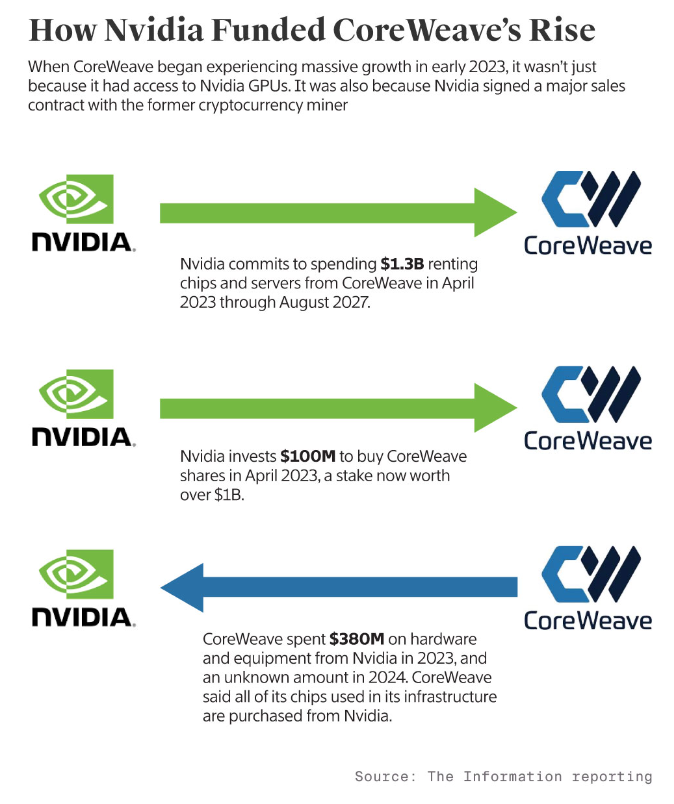

这里蕴藏着更严重的危机在于,CoreWeave的GPU储备、基础设施包括数据中心建设所需的资金大部分都来自借贷。据美国科技媒体information报道,在招股说明书中没有显名的第二大客户正是英伟达,去年贡献了15%的营收,约合2.87亿美元。

目前英伟达与CoreWeave正在进行代号为“鱼鹰计划”的合作,2023年初,英伟达向CoreWeave股权投资1亿美元,并承诺在四年内向CoreWeave支付13亿美元,租回自己生产的芯片,那么2.87亿美元收入可以算这13亿美元的一部分,而CoreWeave在2023年当年就花费了3.8亿美元来购置英伟达的硬件和设备,换句话说,单就这笔交易而言,CoreWeave显然是买亏了,2024年之后虽没有公开信息,我们推测只多不少,那么CoreWeave在这方面的综合成本很可能大于收入。我们不禁要问,CoreWeave为什么要和英伟达绕这么大一圈却做亏本买卖?

英伟达是怎么投资CoreWeave增长的,来源:The Information

说到底,英伟达以至微软、OpenAI最终还是会买单的,也许它们认为巨大的资金成本和不确定性结果,短期很难向股东交代,而是让CoreWeave这样深度绑定的合作伙伴先冲在前面。

我们看到,要实现CoreWeave规划的核心竞争力,需要巨大的重资产投入。据公开媒体报道,CoreWeave在数据中心承诺做出很多投资计划,如它计划投资超过10亿美元,将美国新泽西的一座实验室大楼改造成数据中心;与Blue Owl、Chirisa和PowerHouse合作的50亿美元项目的一部分;承诺在英国的数据中心投资超过10亿英镑;承诺在欧洲的数据中心再投资22亿美元;承诺在美国弗吉尼亚州投资6亿美元的数据中心项目等等。

CoreWeave全球数据中心网络,来源:CoreWeave招股说明书

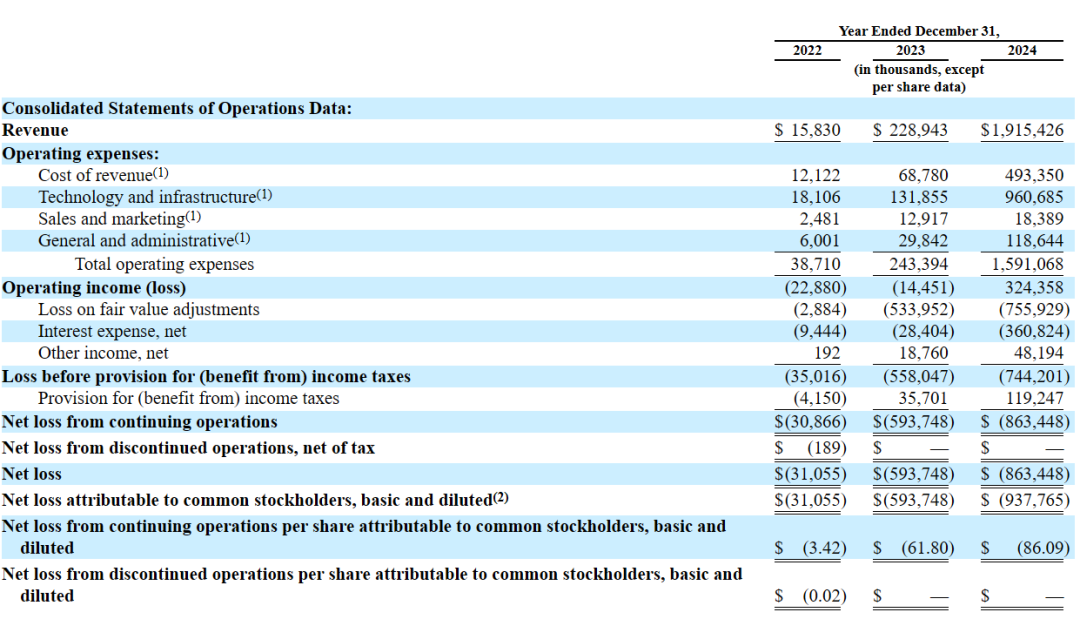

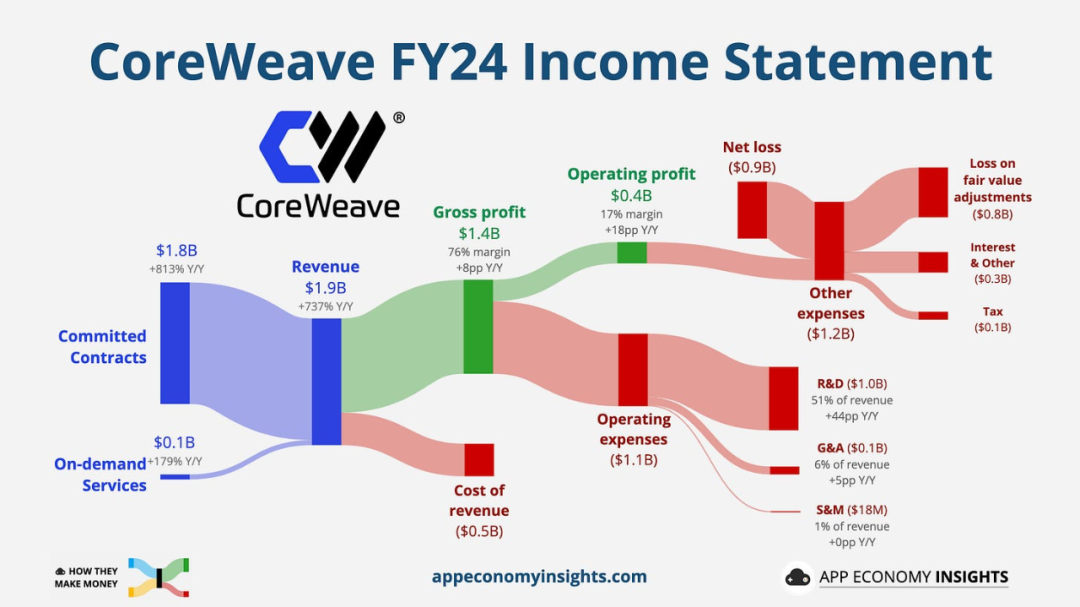

且不说这样布局是否合理,CoreWeave重资产投入从哪里来?我们从损益表可以看出,2024年营收约为19.15亿美元,运营成本(Operating expenses)则高达15.9亿美元,收入增长736.36%的背后,成本也增长了654%,最后导致去年净亏损(Net loss)8.63亿美元。

来源:CoreWeave招股说明书

Coreweave2024财年收入情况

来源:App Economy Insight

CoreWeave招股说明书表明,2024年其已签约1.3千兆瓦(GW)的运算容量,并转化为大约360兆瓦的运算能力。据美国科技媒体下一代平台(The Next Platform)主编Timothy Prickett Morgan估算,CoreWeave中GPU的估计价值约为75亿美元,将这些GPU转化为系统需要大约150亿美元的资本支出。

随着GPU数量的持续增长,并承诺达到签约的总计算能力,150亿美元只是当前的资本支出,并未涵盖未来几年可能持续攀升的成本。这意味着,CoreWeave每年仍需不断追加投资,以满足算力扩张需求并履行长期承诺。

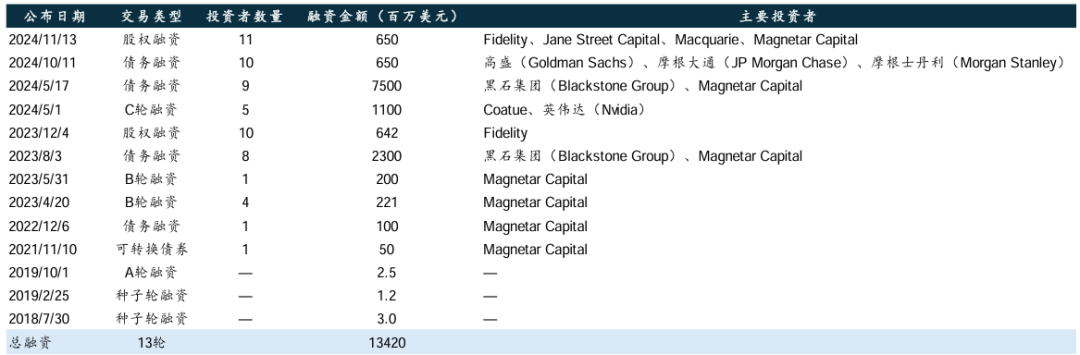

而这150亿美元恰好与CoreWeave历次融资总金额145亿美元基本能够对应,CoreWeave招股说明书表示,“我们通过12轮股权和债权融资筹集了145亿美元”,实际上这145亿美元大部分都是债权融资,CoreWeave将其整合进入两个DDTL(递延税项贷款,Delayed Draw Term Loan facilities),我们分别来看:

DDTL1.0主要来自私密股权资产管理公司黑石集团和对冲基金Magnetar Capital在2023年的借贷,总共23亿美元,2023和2024年平均年利率分别为14.12%、14.11%,再加上其它成本,根据科技博主Edward Zitron的推测,每年至少支付8.92亿美元的利息,预计到2028年3月还完。

很快又来了DDTL2.0,这次是在2024年,由黑石和Magnetar Capital牵头,完成了76亿美元的贷款,后面高盛(Goldman Sachs)、摩根大通(JP Morgan Chase)和摩根斯坦利(Morgan Stanley)等顶级投行也有参与,又借出了6.5亿,作为DDTL的补充,总共达到82.5亿美元的债务。DDTL2.0的年利率稍低一些,为10.53%,根据Edward Zitron的推测,每年则至少支付7.6亿美元的利息。

我们将这两个债务相加,每年至少要有16.52亿美元用于还债,去年的总收入不过19.15亿美元。比较残酷的是,这几家投行之所以把利率订到那么高,或许他们并不指望CoreWeave能够还到2028年或者更久,而是以更快速度在AI算力爆发之际收回一部分本金。

CoreWeave融资历史(不完全统计)

来源:华泰证券、CoreWeave招股书、Crunchbase

而英伟达并没有参与到发债的阵营中,它应该有过类似的计算,比较有意思的是,在2023年DDTL1.0的时候,英伟达曾提出用H100 GPU作为借贷的抵押品,因为在当时GPU是硬通货,获得较高的市场价值。然而今天英伟达H100 GPU的价格从2023年的8美元/小时一路下跌,最低到1美元/小时,摩尔定律仍然起作用。

然而,CoreWeave借贷是真金白银,并没有摩尔定律,除非美联储降息。

这还没有提及DeepSeek。上个月被世人有更多了解的DeepSeek通过算法创新和工程优化显著降低了大模型的算力成本,其核心技术包括混合专家(MoE)架构、定制化AI芯片设计(如稀疏计算单元和高带宽内存架构)、FP8混合精度计算、稀疏化技术以及数据蒸馏等,有效减少了训练和推理所需的计算资源,同时优化了模型效率。

我们看到,DeepSeek的低算力成本模式可能进一步削弱CoreWeave的市场竞争力。目前,在英伟达与CoreWeave体系下,无论是OpenAI、Mistral等大客户,还是中小客户,主要仍依赖GPU云供应商以高价租赁英伟达的算力服务。若DeepSeek的低成本方案进一步普及,可能促使全球中小客户转向DeepSeek主导的开源生态,又占据CoreWeave的一部分市场发展空间,迫使其调整定价策略或拓展增值服务,以维持竞争力,如此则进一步推高成本或减少收入。

若行业转向轻量化AI架构,将引发GPU估值重估—抵押品减值—融资能力下降的连锁反应,直接冲击微软、Meta等依赖英伟达GPU算力的企业,除非它们能及时调整方向,而CoreWeave这类高度依赖GPU的公司则更难找到生存空间。

一旦危机爆发,庞大的债务积压与产业连锁反应,或将导致估值数百亿美元的CoreWeave轰然倒塌,并波及整个上下游生态。因此,CoreWeave如今的赌注在于,既然自己已深度捆绑大厂生态,现实大厂也会豪赌其未来,后者的资产毕竟比几十亿负债的规模要大得多——这里不是Web3的世界。

CoreWeave能否从“鱿鱼游戏”中全身而退?

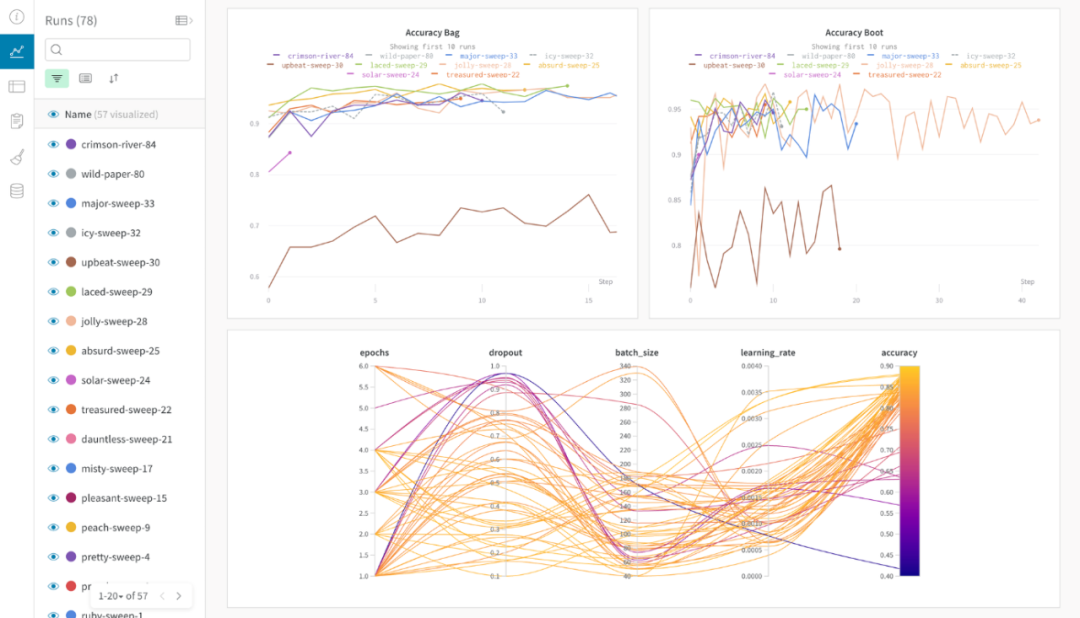

2025年3月4日,在上市前敏感时期以及资金紧张情况下,CoreWeave仍拟斥资17亿美元收购AI开发平台Weights & Biases(W&B)。

W&B成立于2018年,专注于 MLOps 和 LLMOps,为 AI 模型的构建、训练和部署提供工具支持。核心产品是一整套AI模型开发与管理工具,帮助科研人员和工程师更高效地进行模型训练、监控性能,并优化工作流程。

我们看到,一方面,这笔交易有助于CoreWeave整合自身的硬件优势与W&B的软件能力,从单一的GPU供应商转型为全栈式AI云平台提供商,超越单纯的GPU云服务;另一方面,CoreWeave即刻获得接触W&B庞大的百万级AI工程师用户生态系统的机会,在市场上产生更强的影响力和更正面的评价,两方面都可能给CoreWeave带来更多的想象空间。

W&B For TWIML Listeners

来源:Weights & Biases(W&B)网站

目前CoreWeave的未来,仍掌握在自己手中,未来既取决于自己,也取决于整个AI算力市场的持续演变。未来,无论是英伟达与大厂的竞争格局,以DeepSeek为代表的轻量化AI的攻城略池,CoreWeave自身成本压力的加剧、GPU价格的骤降,以及资本市场的信心波动,都可能让这场豪赌变得极端危险。在AI算力演进的新时代,CoreWeave能否成功从生存游戏中突围,还是成为科技变革的牺牲品,或许很快就会有答案。