今天凌晨4点,著名大模型训练平台Together AI和智能体平台Agentica,联合开源了新模型DeepCoder-14B-Preview。

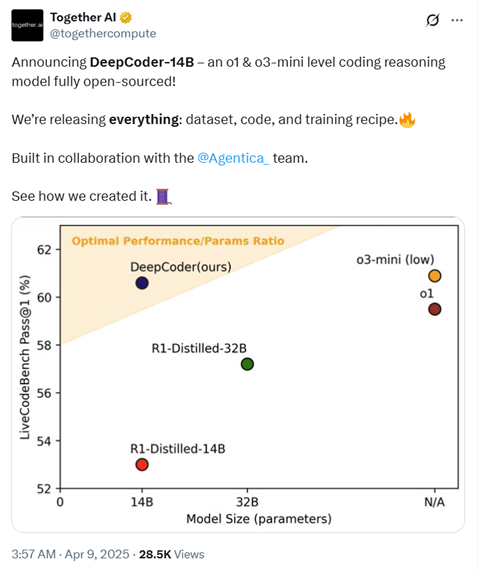

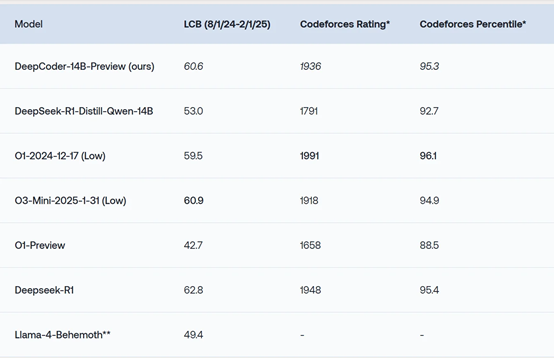

该模型只有140亿参数,但在知名代码测试平台LiveCodeBench的测试分为60.6%,高于OpenAI的o1模型(59.5%),略低于o3-mini(60.9%)。在Codeforces、AIME2024上的评测数据同样非常出色,几乎与o1、o3-mini差不多。

值得一提的是,Together AI不仅开源了DeepCoder-14B模型权重,还把训练数据集、训练方法、训练日志和优化方法全部公开,帮助开发者更深度的了解这个模型所有开发流程。

开源地址:https://huggingface.co/agentica-org/DeepCoder-14B-Preview

github:https://github.com/agentica-project/rllm

DeepCoder是在Deepseek-R1-Distilled-Qwen-14B基础之上,通过分布式强化学习(RL)进行了微调。

在开发过程中,研究人员首先构建了一个高质量训练数据集,包含24K个可验证的编程问题:涵盖TACOVerified 问题、PrimeIntellect 的 SYNTHETIC-1 数据集中的验证问题等。

为了确保数据质量,通过程序验证、测试过滤和去重等步骤。程序化验证,每个问题都会使用外部官方解决方案自动进行验证。会过滤数据集,只包含官方解决方案通过所有单元测试的问题。

测试过滤,每个问题必须至少包含5个单元测试。重复数据删除,删除了数据集中的重复问题,以避免污染。

在代码强化学习训练中,DeepCoder 使用了两种沙盒来运行单元测试并计算奖励。Together Code Interpreter 是一个快速高效的环境,与RL训练直接兼容,成本低且可扩展性强,能够支持100多个并发沙盒和每分钟1000多个沙盒执行。

本地代码沙盒则是一个独立的、受保护的 Python子进程,遵循官方 LiveCodeBench仓库中的相同评估代码,确保了结果与现有排行榜的一致性。

在奖励函数设计方面,DeepCoder采用了稀疏结果奖励模型(ORM),避免分配部分奖励,从而防止模型通过奖励黑客行为来获取不准确的奖励信号。

奖励函数简单而明确:如果生成的代码通过所有采样单元测试,则奖励为 1;否则为 0。这种设计确保了模型能够专注于生成高质量的代码,而不是通过记忆测试用例来获取奖励。

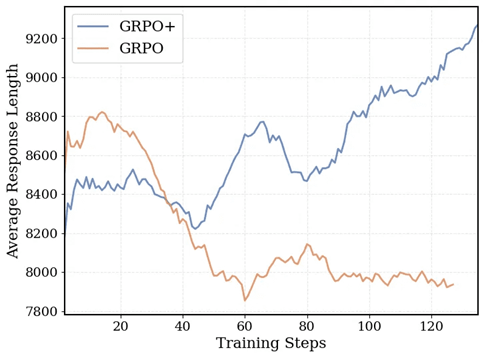

为了实现更稳定的训练过程,DeepCoder的训练采用了 GRPO+,这是对原始 GRPO 算法的改进版本。

通过消除熵损失和 KL 损失、引入过长过滤和上限裁剪等技术,GRPO+ 使得模型在训练过程中能够保持稳定的熵值,避免训练崩溃,并且能够更自然地生成较长的输出,从而提高了模型的推理能力。

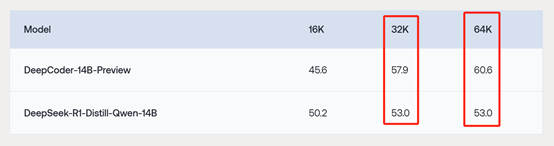

此外,DeepCoder-14B-Preview 采用了迭代上下文扩展技术,使模型能够从较短的上下文长度开始学习,然后逐步泛化到更长的上下文。该模型的上下文窗口从 16K 扩展到 32K,最终在 64K上下文中评估时达到了60.6%的准确率。

为了加速端到端的RL训练,DeepCoder 团队引入并开源了 verl-pipeline,这是 verl 的一个优化扩展。通过一次性流水线技术,DeepCoder 实现了训练、奖励计算和采样的完全流水线化。

同时,奖励计算与采样交错进行,减少了奖励评估的开销。这些优化使得训练时间减少了 2 倍,特别是在需要运行数千个测试用例的编码任务中,显著提高了训练效率。

虽然DeepCoder刚开源但评价非常高,网友表示,这相当令人惊讶。它不仅是真正意义上的开源,而且他们还对广义信赖域策略优化算法(GRPO)进行了多项改进,并且在训练过程中为采样流水线增添了额外的效率提升。

太厉害了!等不及这款模型在 Ollama 平台上体验了。

圣诞节提前到来了。

传奇!开源就应该这样。

关于Together AI

Together AI成立于2022年,主打云大模型平台支持超过200种开源AI模型,包括Llama系列、DeepSeek-R1等,并优化了高速推理和模型训练的基础设施。目前拥有超过3.6万块GB200 NVL72组成的超大GPU算力群。

此外,Together AI还提供模型微调、Agent智能自动化工作流和合成数据生成等,为大企业提供底层服务。

前不久,Together AI刚获得3.05亿美元的B轮融资,其估值也从去年的12.5亿美元翻倍至33亿美元。

本文素材来源Together AI,如有侵权请联系删除