近期,随着淘天集团对外披露了其 AIGX 技术体系、大模型家族等技术进展,其 AI 技术实力引发外界更多关注。有报道显示,淘天集团过去 5 年发表在国际顶会的论文数量超过 300 篇,同时阿里妈妈团队发明并申请中国专利 130 项以上,其中超过 20 项已经正式获批授权。

此外记者还了解到,淘天集团至今已开源了多个 AI 项目,且多个模型排名开源社区趋势榜前列。

值得一提的是,在人工智能顶会 NeurIPS 2024 上,淘天集团阿里妈妈团队就开源了世界首个标准化的自动出价 benchmark——AuctionNet,该数据集中包含了 48 个不同出价智能体相互竞价的日志,共有 5 亿条记录,共计 80GB。

AuctionNet 不仅适用于广告拍卖中的出价决策算法研究,也适用于大型博弈场景的决策智能算法研究。在 NeurIPS 2024 竞赛上 AuctionNet 已投入应用,为 1500 支队伍提供了近万次准确、公正的算法效果评估,并帮助选手研发更多元、创新性的解决方案。

在智能创意方向,淘宝天猫仅去年一年就开源了多个项目,如基于 FLUX(FLUX.1-dev)的配套模型 ControlNet 图像修复模型以及 8 步加速的 Turbo 模型,两个模型可互相兼容配合使用,达到更快的修复生图速度。

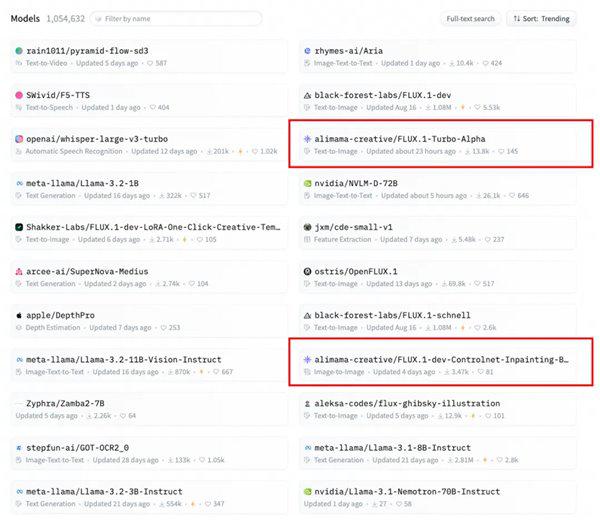

两项模型开源后很快收到了社区积极反馈,在 HuggingFace 社区居于趋势榜前列。

两个模型均排名开源社区趋势榜前列 2024.10.16

ChatGPT 掀起大模型浪潮后,淘天集团还曾联合爱橙科技于 2023 年 9 月对外开源大模型训练框架 ——Megatron-LLaMA,让开发者们能够更方便地提升大语言模型训练性能,降低训练成本,并且保持和 LLaMA 社区的兼容性。测试显示,在 32 卡训练上,相比 HuggingFace 上直接获得的代码版本,Megatron-LLaMA 能够取得 176% 的加速;在大规模的训练上,Megatron-LLaMA 相比较 32 卡拥有几乎线性的扩展性,而且对网络不稳定表现出高容忍度。

此外,淘宝天猫一直保持开源的传统,和业界共享 AI 技术红利,已经开源了包括 DIN(深度兴趣网络)、XDL(阿里自研深度学习框架)、EULER(分布式高性能图表示学习框架)、CLF(曲率空间学习框架)、EFLS(联邦学习解决方案)等在内的很多 AI 模型和平台。

AI 电商方兴未艾,淘天集团正在持续大量储备 AI 领域技术人才。据公开报道,过去两年内,淘天集团启动多轮校招,技术类岗位占比持续增加;又连续两年发起 T-Star 全球顶尖技术人才计划,开出定制化培养、百万年薪等待遇。