新智元报道

编辑:编辑部 NZYH

【新智元导读】满血版o3和o4-mini深夜登场,首次将图像推理融入思维链,还会自主调用工具,60秒内破解复杂难题。尤其是,o3以十倍o1算力刷新编程、数学、视觉推理SOTA,接近“天才水平”。此外,OpenAI还开源了编程神器Codex CLI,一夜爆火。

不出所料,满血版o3真的来了。

刚刚,OpenAI联创Greg Brockman和首席研究官Mark Chen带队,开启了20分钟线上直播。

这次不仅有o3,还有下一代推理模型o4-mini。它们首次实现了“用图像思考”,堪称视觉推理的巅峰之作。

如同AI智能体,两款模型在不到1分钟内,自主判断并组合运用ChatGPT内置工具,生成了详尽周全的答案。

其中包括,搜索网页、用Python分析上传的文件及数据、对视觉输入进行深度推理,乃至生成图像。

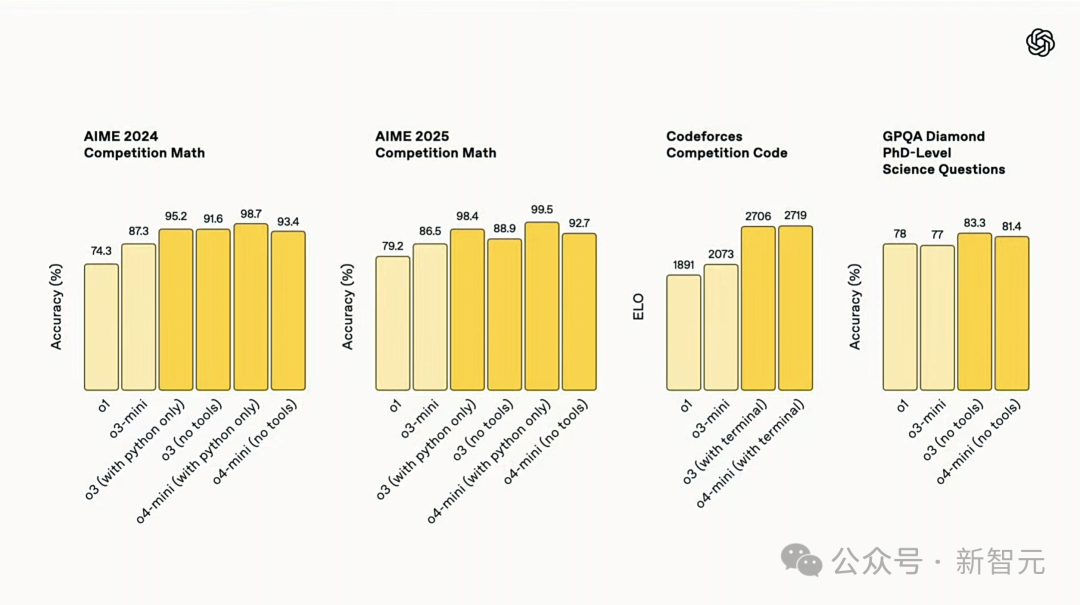

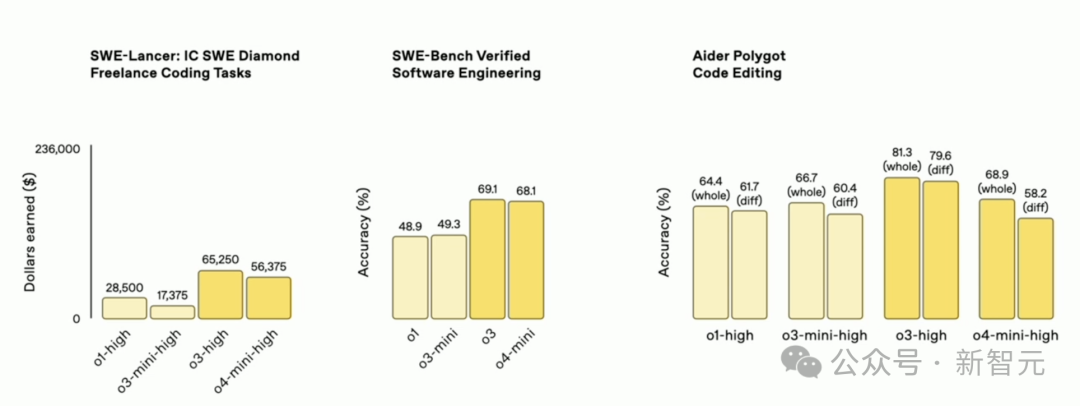

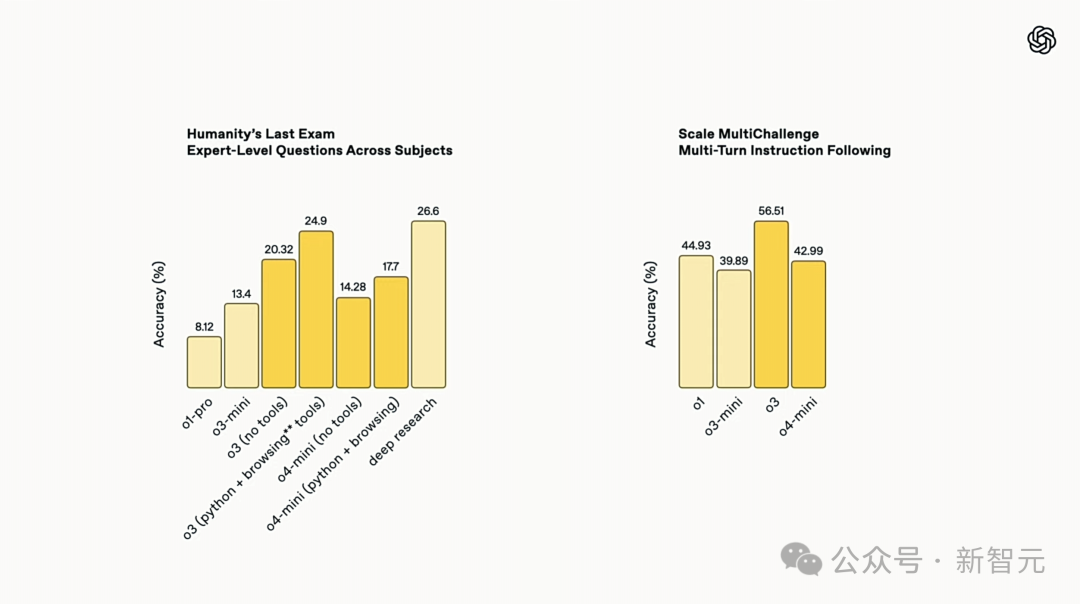

在Codeforces、SWE-bench、MMMU等基准测试中,o3刷新SOTA,不论是在编程、数学、科学,还是在视觉感知领域都树立了新标杆。

尤其是,对于图像、图表、图形分析,o3表现尤为突出,能够深入挖掘视觉输入的细节。

|

|

在Codeforces中,新模型得分均超2700分,在全球参赛者中排名前200名

用奥特曼的话来说,“接近或达到天才水平”。

不过,这个智力的代价是,需要投入o1十倍以上的算力。

相较于满血版o3,o4-mini则以小巧高效、高性价比的特点脱颖而出。

在AIME 2025测试中,o4-mini配合Python解释器取得了99.5%高分,几乎完美拿下了这项基准测试。

而且,在数学、编程、视觉任务,以及非STEM领域,它的性能均优于o3-mini。

此外,o4-mini支持远超o3的使用额度,是高并发场景最优选。

总而言之,o3和o4-mini都非常擅长编码,由此OpenAI还开源了一个可在终端运行的轻量级编程 AI 智能体——Codex CLI。

|

|

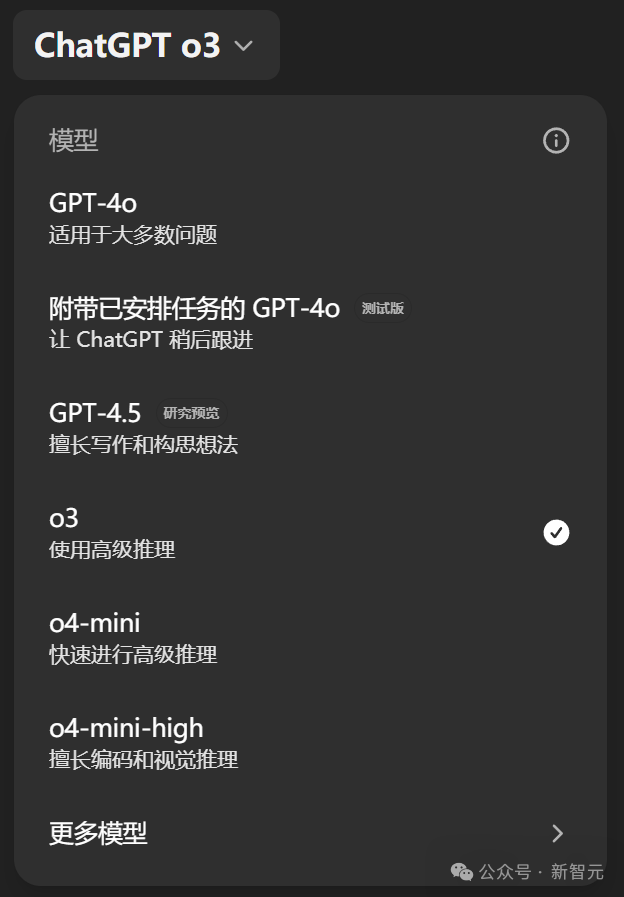

从今天起,ChatGPT Plus、Pro和Team用户将第一时间体验到o3、o4‑mini和o4‑mini‑high,它们将取代o1、o3‑mini和o3‑mini‑high。

同时,这两款模型也将通过Chat Completions API和Responses API,向所有开发者提供。

推理模型,首次会用工具了

直播演示中,Greg先上了一个价值——有些模型就像是质的飞跃,GPT-4是其中之一,今天o3/o4-mini同样是。

他表示,o3让他和OpenAI的同事见到了AI大模型能完成“从未见到的事”,比如,它自己就提出了一个很棒的系统架构想法。

这两款模型真正令人惊讶的地方,它们不仅仅是模型,更是一个“AI系统”。

它们跟之前那些推理模型最大的区别,就是首次被用来训练各种工具。它们会在CoT中使用这些工具来解决难题。

人类最后考试中,o3模型足以媲美Deep Research表现,而且速率更快

为了攻克了一个复杂难题,o3曾连续使用约600次工具调用。它们一次性生成的代码片段,真正在代码库发挥效用。

Greg表示,自己最珍视的一点,就是它们的软件工程能力:它们不仅能编写一次性的代码,而且能真正在真实的代码库中工作!

比如,它在浏览OpenAI代码库方面,就比Greg做得更好。这就是它极其有用的地方。

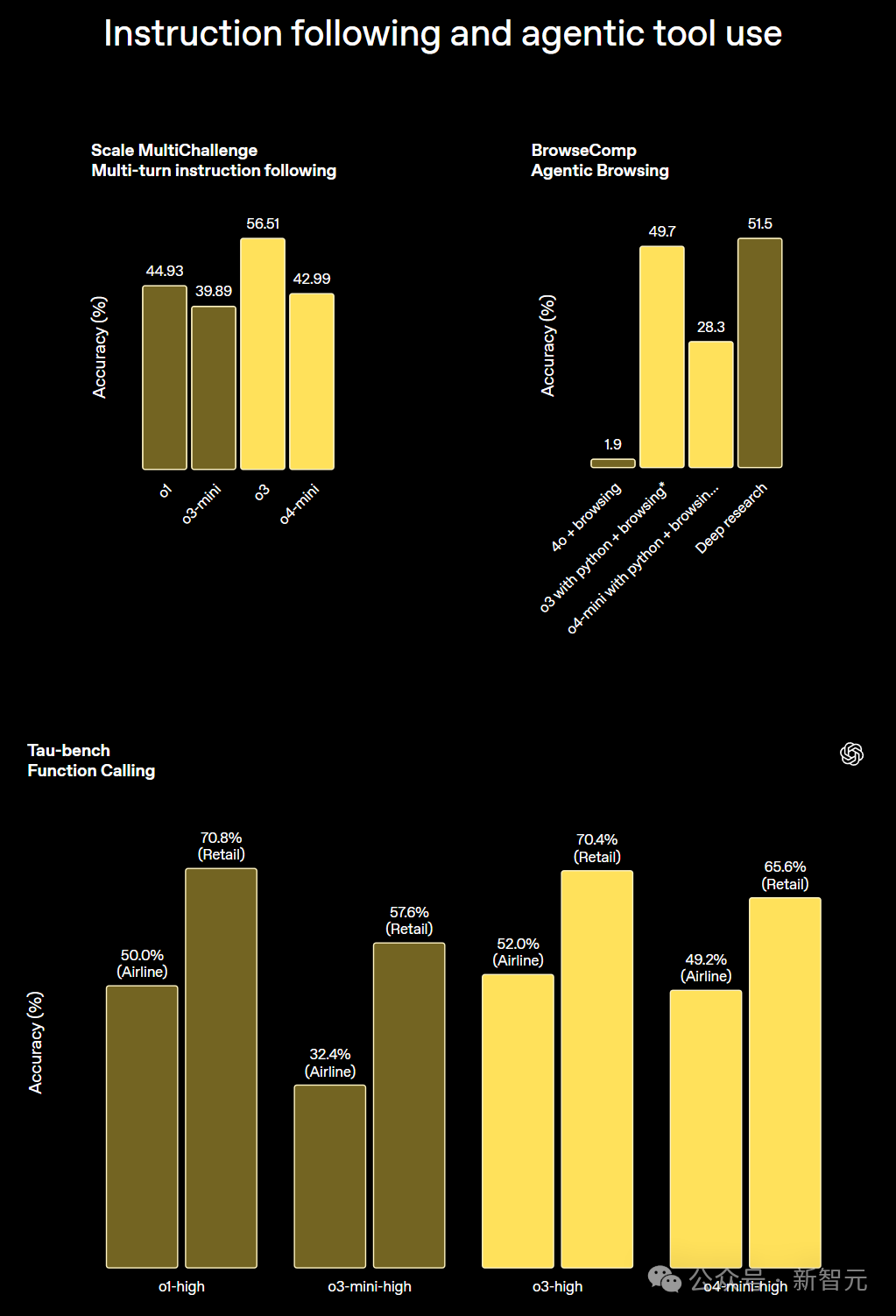

而且,在指令跟随、智能体工具使用评估中,与工具结合的o3和o4-mini准确性是最高的。

外部专家评估显示,o3在处理真实世界任务时,严重错误率比o1还降低了20%。

之所以有如此大的进步,正是因为RL中持续的算法进步所驱动的。用Greg的话说,引擎盖下最令人惊叹的是,目前它还仍然是预测一个token,然后加入一点RL的AI,就已经做到这个地步。

那么,在实操过程中,o3是如何结合使用工具解决复杂任务的呢?

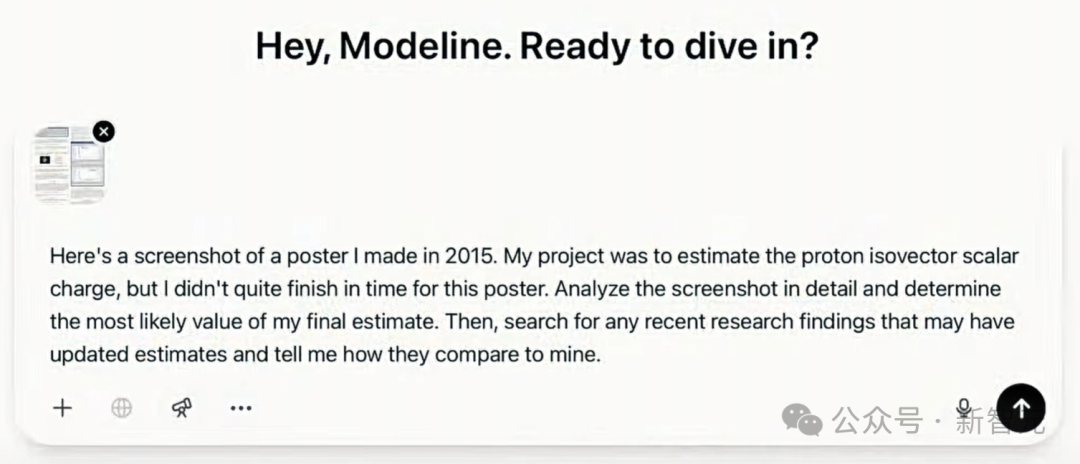

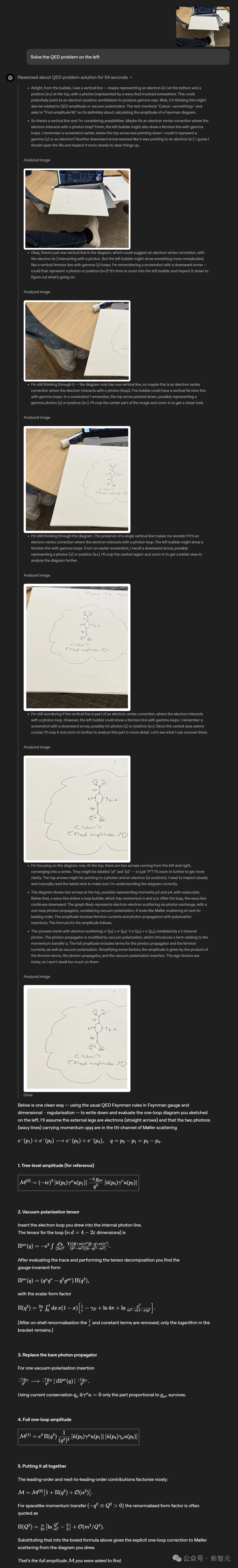

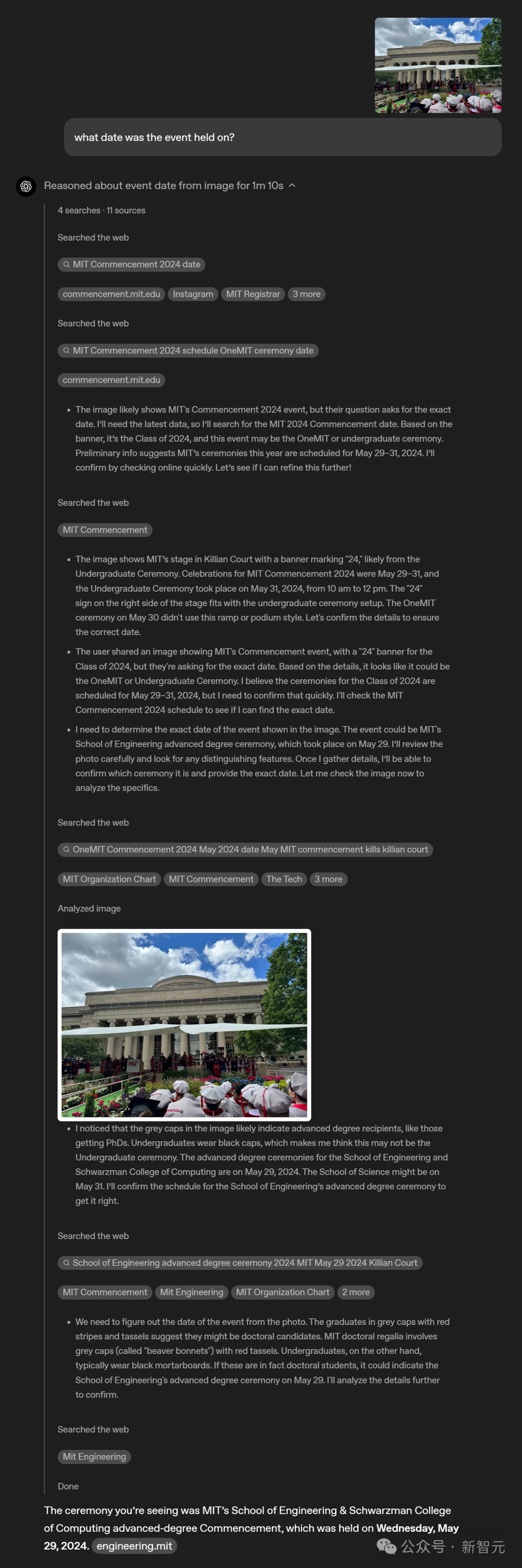

多模态团队研究员Brandon McKinzie上传了一张2015年完成的一个物理实习海报,让ChatGPT估算质子同位标量电荷的数量。

o3开始推理的同时,逐一分析图片中内容,并确定Brandon提出问题的正确数量。实际上,海报截图中并没有覆盖最终结果。

于是,o3便开始联网搜索查找最新的估算值,几秒钟内读完数十篇论文,节省了大量时间。

结果显示,模型计算出了一个未经归一化的值,并且乘以一个特定常数,又可以重新归一化,最终结果与实际比较接近。

后训练团队研究员Eric Mitchell为ChatGPT开启了记忆功能, 然后让o3去查找新闻,而且是与自己兴趣有关的内容,同时还要足够冷门。

o3基于已有的了解——潜水和演奏音乐,主动思考并调用工具,找出了一些相关的有趣内容。

比如,研究人员录制了健康的珊瑚声音,并用扬声器播放录音,加速了新珊瑚和鱼类定居。

同时,它还能绘制出可视化的数据,便于直接放入博客文章当中。

也就是说,无论o3是用于前沿的科研领域,还是将模型集成到日常工作流中,都会非常有用。

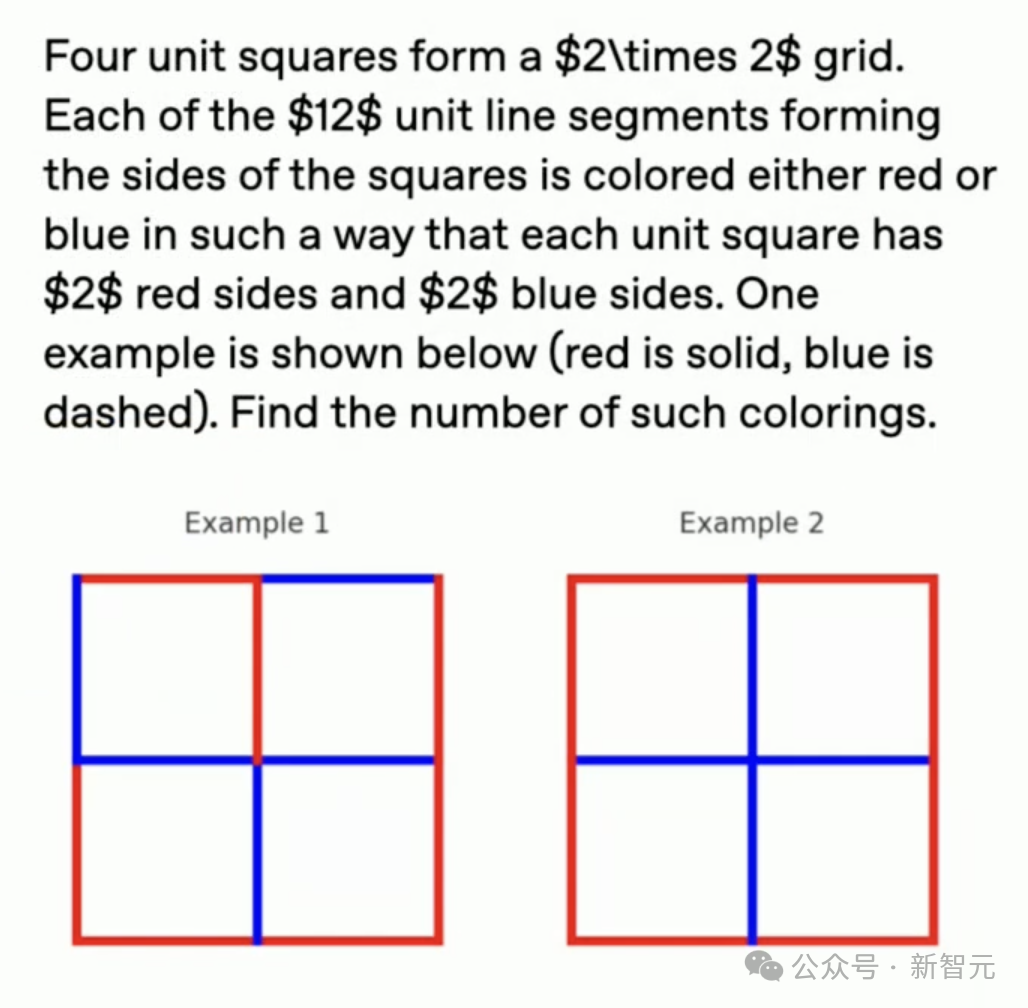

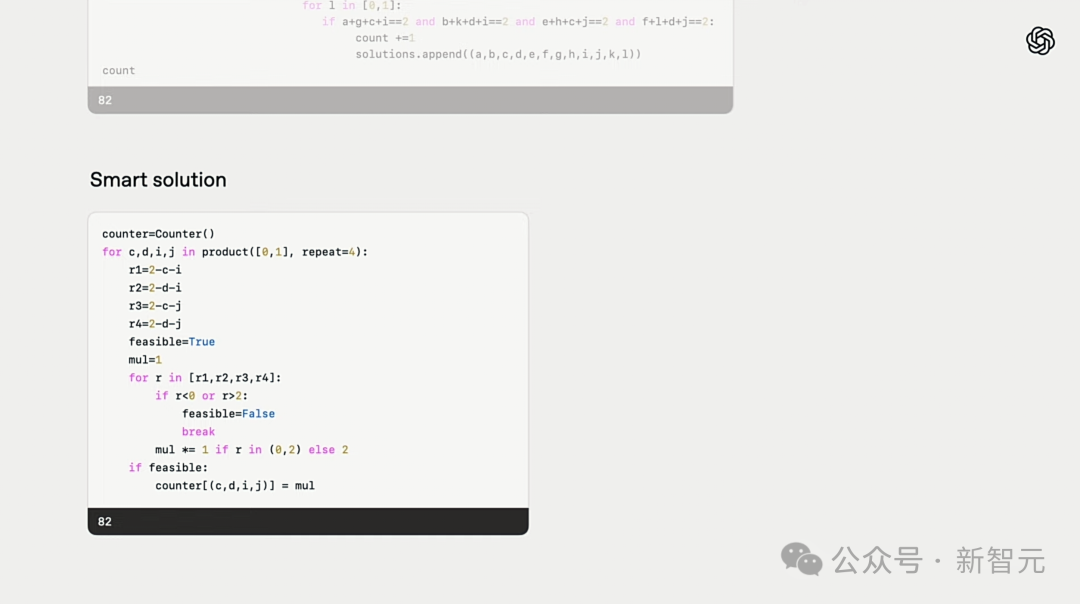

在解决AIME数学竞赛问题时,o3被要求观察2x2方格网格,并计算出满足约束条件的颜色方案数量。

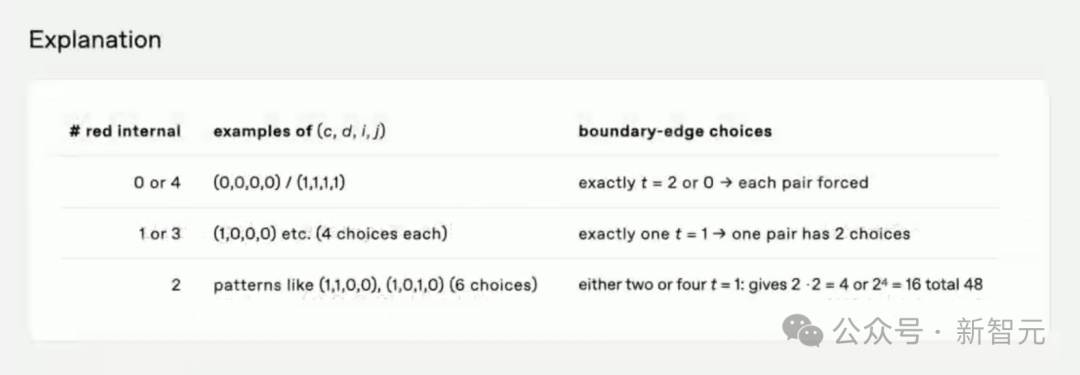

它首先生成了一个暴力程序,然后用Python解释器运行,并得到了正确答案,即82。

即便如此,它的解题过程并不优雅简洁,对此,o3自动识别后并尝试简化解决方案,找到更聪明办法。

它还会自动核查答案的可靠性,甚至最后给出了文字解决方案,方便向人类解释。

让研究人员惊讶的是,训练o3过程中并没有使用类似策略,也没有要求简化,都是AI自主学习完成的。

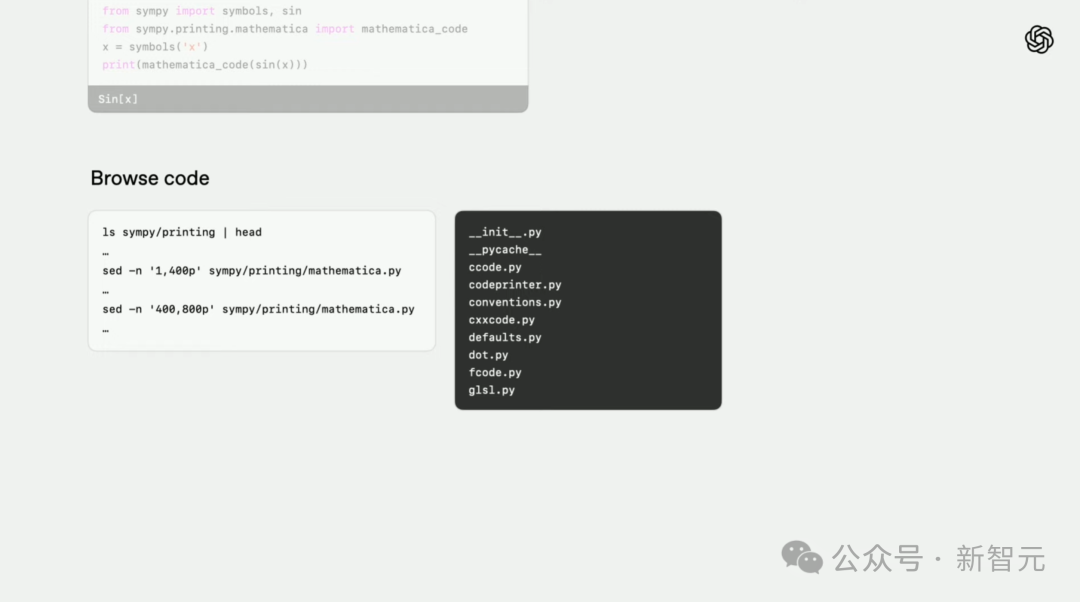

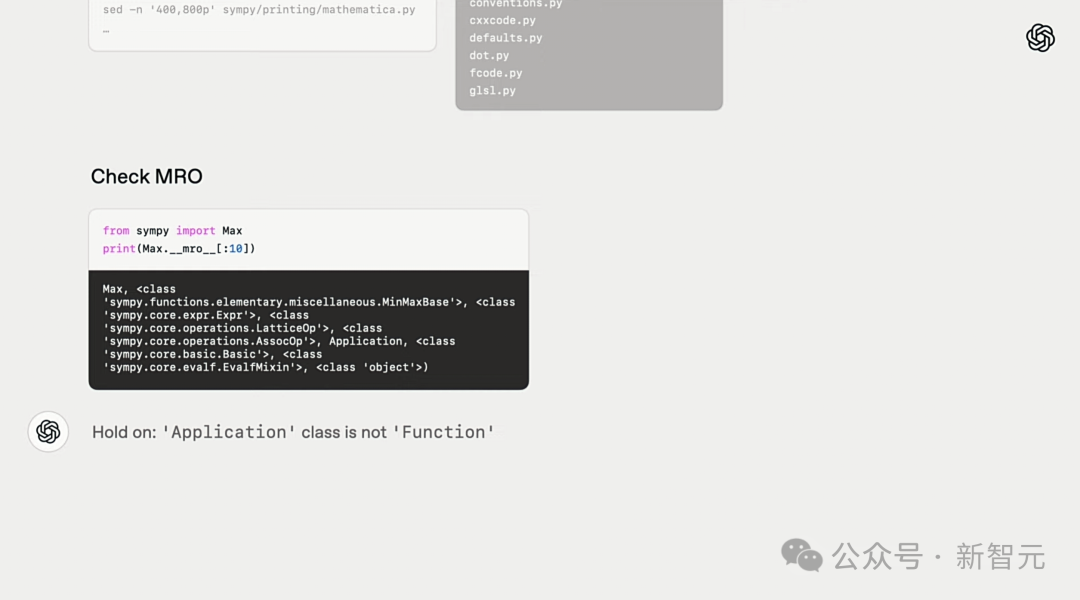

在编码任务中,研究人员让o3-high找出一个名为symbols软件包的错误。

首先,模型会主动检查指令中,所说的问题是否存在,并尝试了解代码储存库的概况。

然后,它发现一可以mro的解释类继承信息的Python结构,基于已有的世界知识,找到了问题所在。

最后,o3通过浏览互联网,找到了最优的解决方案——apply_patch。

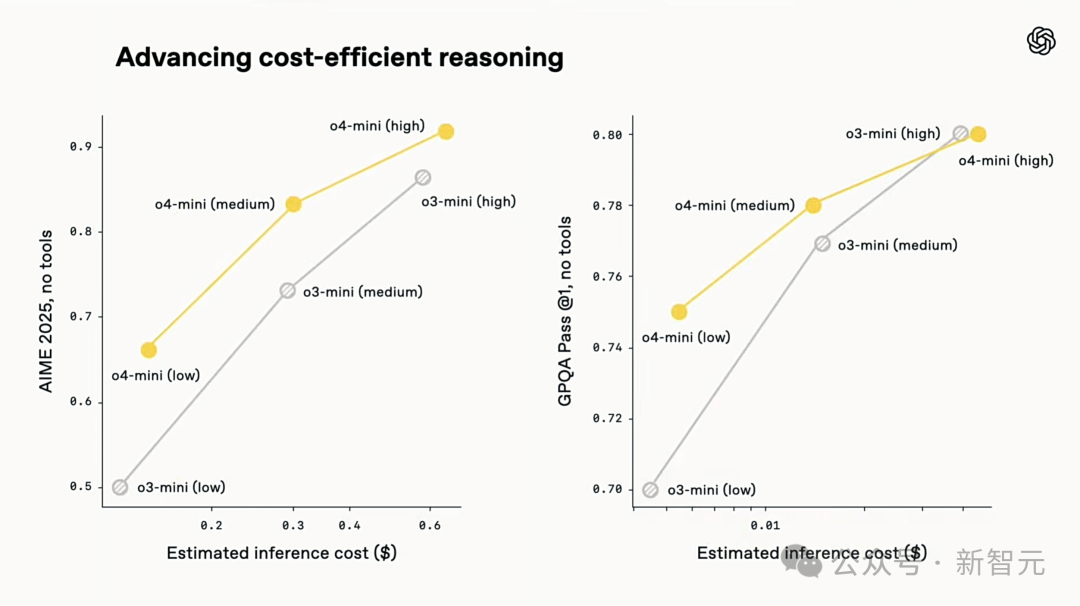

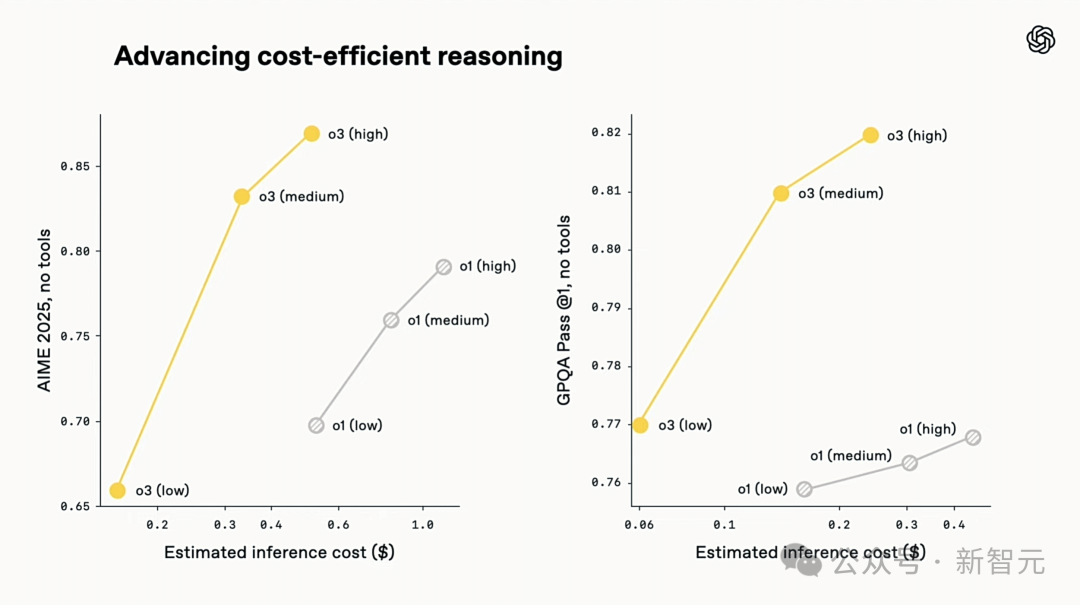

就推理成本来看,o3和o4-mini不仅是迄今为止最智能模型,相较于o1和o3‑mini,更在效率和成本控制方面树立了新标杆。

在2025年AIME数学竞赛上,o3推理成本和性能全面优于 o1,同样地,o4-mini成本-性能也全面优于o3‑mini。

所以,如果你需要一个小而快的多模态推理模型,o4-mini将是极好的选择。

|

|

o3和o4-mini能够自主选择工具、计划方法解决问题,无论是数学、商业、科学、体育还是视觉推理都没问题。

比如,在解决体育问题时,o3能联网获取最新数据,考虑了最近一个赛季和2022-23年联赛ERA略升后回归正常的情况。

o1给出的数据是大概值,略有偏差,不够精确,而且它错误地认为偷垒增加完全是因为投球计时器,忽略了基地垫扩大和限制牵制次数这些更直接的原因。

左右滑动查看

用图像思考,视觉推理新巅峰

更引人注目的是,o3和o4-mini在视觉推理上全面超越前代,成为o系列最新的视觉推理模型。

它们通过在思维链(CoT)中用图像进行推理,实现了视觉感知的重大突破。

OpenAI首次实现了模型在其思维链中用图像进行思考——而不仅仅只是看图。

与早期的OpenAI o1类似,o3和o4-mini能在回答前思考更久,在回答用户前内部会生成很长的思维链。

不仅如此,o3和o4-mini可以在思考过程中“看”图片。这种能力是通过工具处理用户上传的图像来实现的,比如进行裁剪、放大、旋转等简单的图像处理。

更厉害的是,这些功能都是原生的,不需要依赖额外的专业模型。

在基准测试中,这种用图像思考,无需依赖网络浏览的能力,碾压了前代多模态模型的性能。

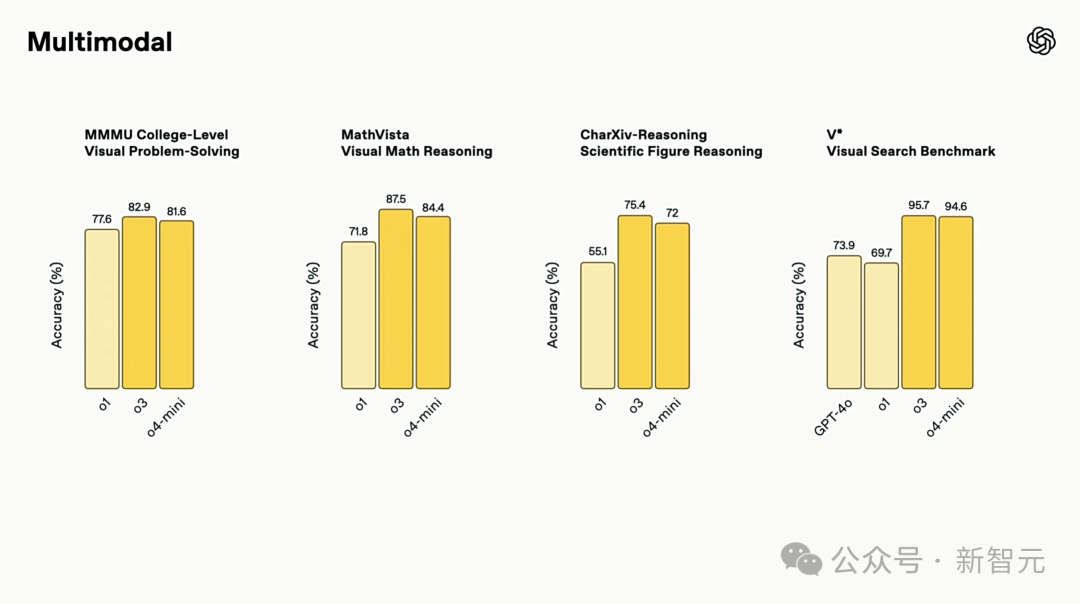

在STEM问答(MMMU、MathVista)、图表阅读与推理(CharXiv)、感知基元(VLMs are Blind)以及视觉搜索(V*)等领域,o3和o4-mini均创下了SOTA。

特别是,在 V*基准测试上,两款模型以96.3%准确率几乎攻克了这项挑战,标志着视觉推理技术重大飞跃。

ChatGPT增强的视觉智能,能更彻底、精准、可靠地分析图片,帮你解决更棘手的问题。

它能将高级推理与网页搜索、图像处理等工具无缝结合,自动放大、裁剪、翻转或优化你的图片,哪怕照片不完美也能挖掘出有用信息。

比如,你可以上传一张经济学作业的照片,得到一步步的解答,或者分享一个程序报错的截图,快速找出问题根源。

这种方法开启了一种新的测试时计算扩展方式,完美的融合了视觉和文本推理。

这体现在它们在多模态基准测试中的顶尖表现,标志着多模态推理迈出了重要一步。

视觉推理实战

用图像思考可以与ChatGPT更加轻松的互动。

你可以直接拍张照片提问,不用担心物体摆放问题——不论文字是不是倒的,或者一张照片里有多道物理题。

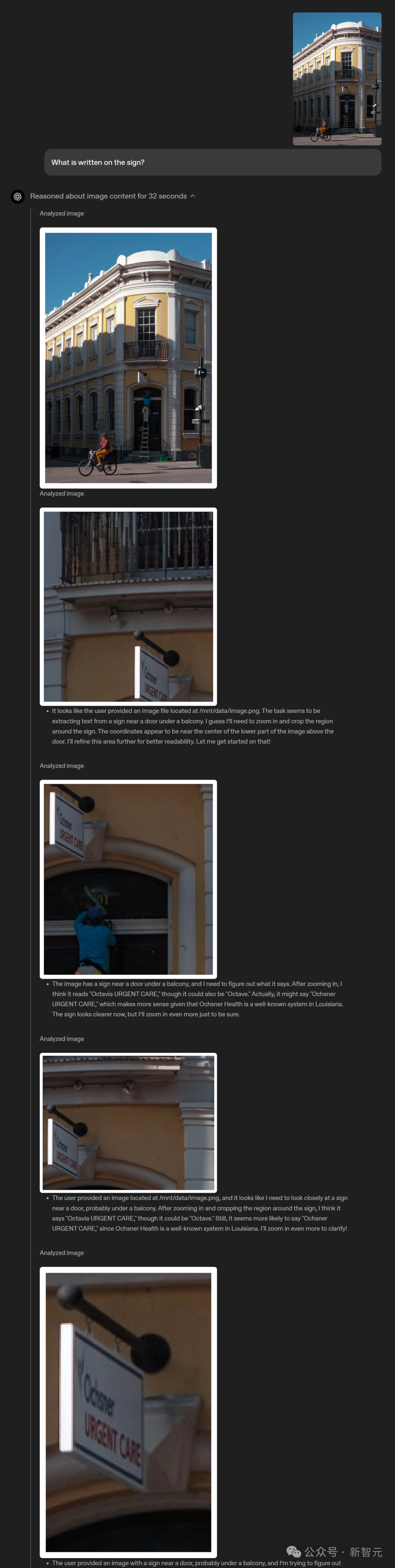

即使东西乍一看不太清楚,视觉推理也能让模型放大看清细节。

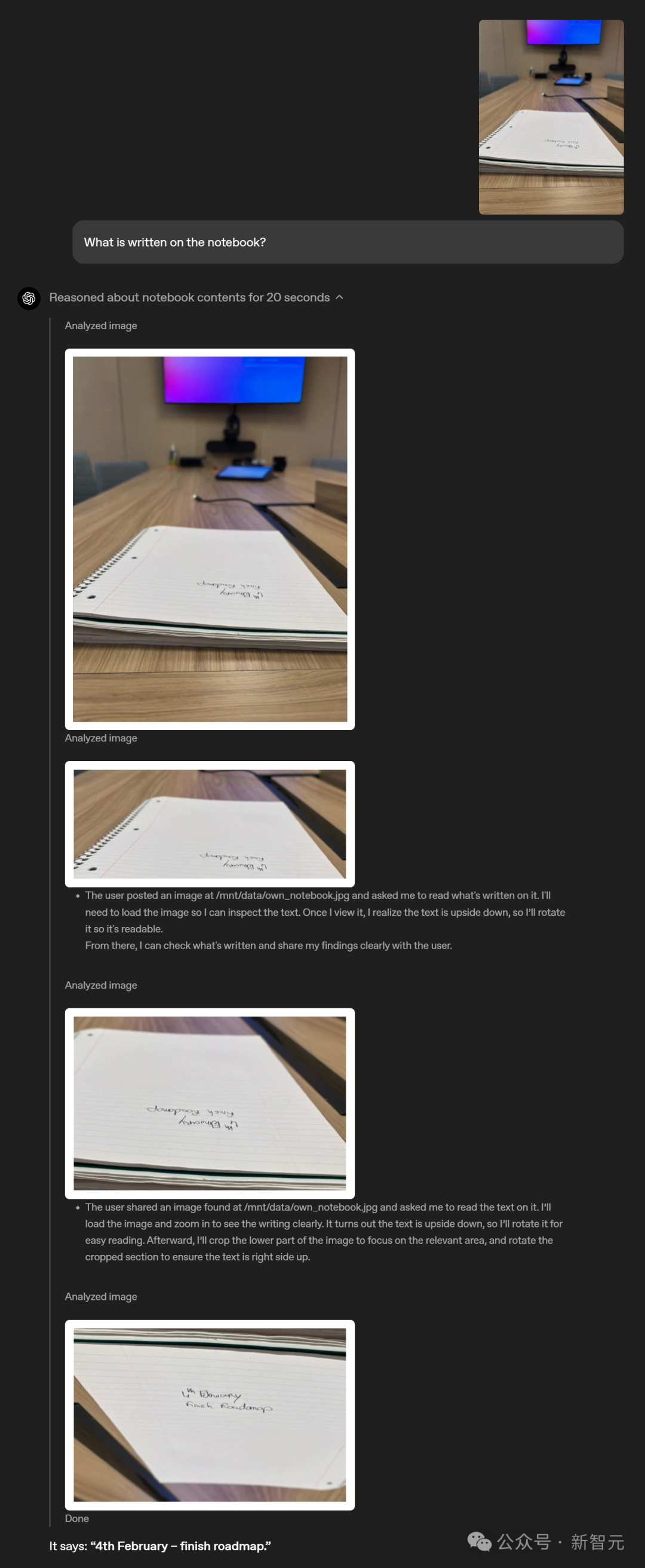

比如,一个放在桌子上几乎与视线平行的笔记本,上面有两行模糊的字,人看上去也很难直接认出来。

而ChatGPT可以将图片放大查看,发现字是倒着的后,还将其旋转过来,最终成功将其给认了出来。

上下滑动查看

上下滑动查看

上下滑动查看

上下滑动查看

OpenAI最新的视觉推理模型能跟Python数据分析、网页搜索、图像生成等工具配合,创意又高效地解决更复杂的问题,为用户首次带来了多模态智能体验。

编程智能体Codex CLI全开源

接下来,OpenAI表示,将展示一些codex遗产的延续,发布一系列应用程序,而它们,将定义编程的未来。

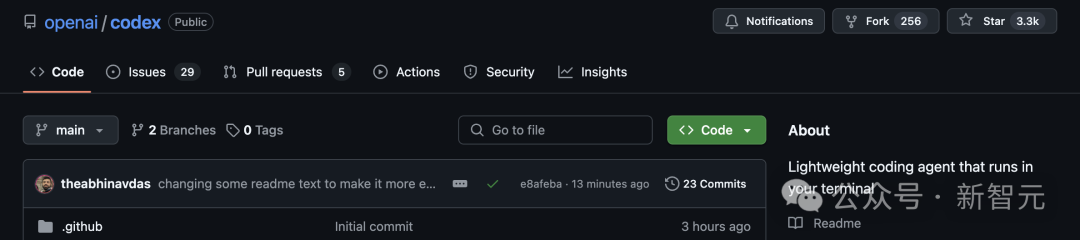

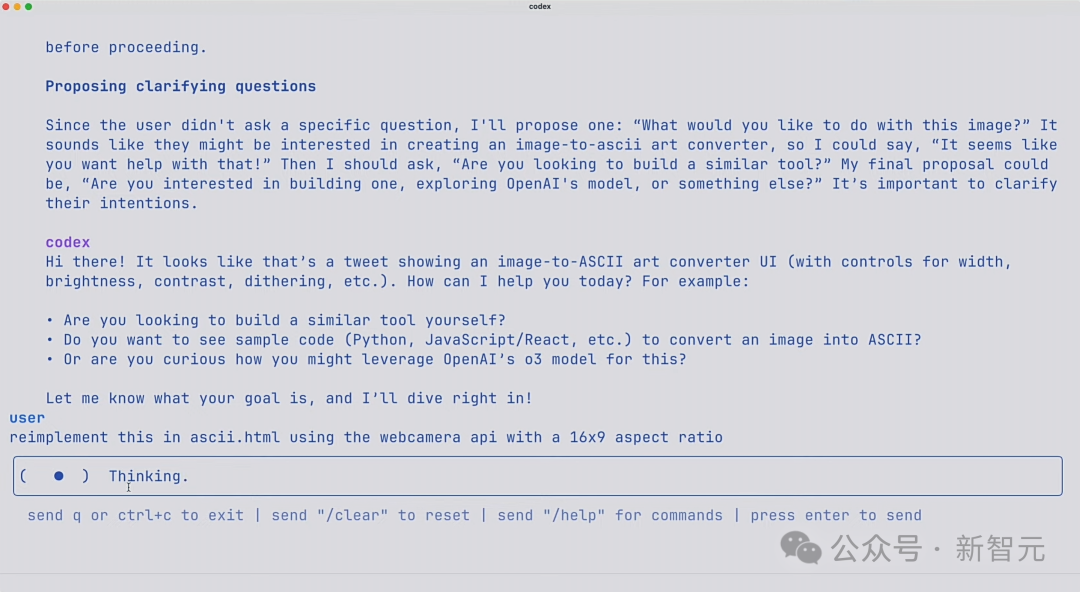

除了新模型之外,OpenAI还开源了一项新的实验性工具:Codex CLI,一个可在终端运行的轻量级编程AI智能体。

它的作用,就是在需要的地方安全地部署代码执行。

它直接在本地计算机上运行,旨在充分发挥o3和o4-mini这类模型的强大推理能力,并将很快支持GPT-4.1等更多模型的API调用。

通过向模型传递屏幕截图或低保真草图,并结合访问本地代码的权限,就能在命令行中体验到多模态推理的强大功能。

同时,他们也启动一项100万美元的资助计划,用以支持使用Codex CLI 和 OpenAI 模型的项目。

GitHub项目一经发布,Codex CLI已斩获3.3k星,可见响应度之高。

项目地址:https://github.com/openai/codex

现场,OpenAI演示人员参考了网上的帖子,使用Codex和o4 Mini做了一个很酷的图片转ASCII生成器。

只需先截一张图,拖进终端里,接下来就可以把它交给Codex。

令人惊叹的是,你可以实际看到它在思考,还可以直接运行工具。

完成后,Codex创建了一个ASCII HTML文件,甚至还生成了一个可以控制分辨率的滑块。

也就是说,从此电脑上的任何文件,以及你正在处理的代码库,都可以放进Codex了!

在现场,研究者们还成功添加了一个网络摄像头API。

Scaling强化学习,依旧有效

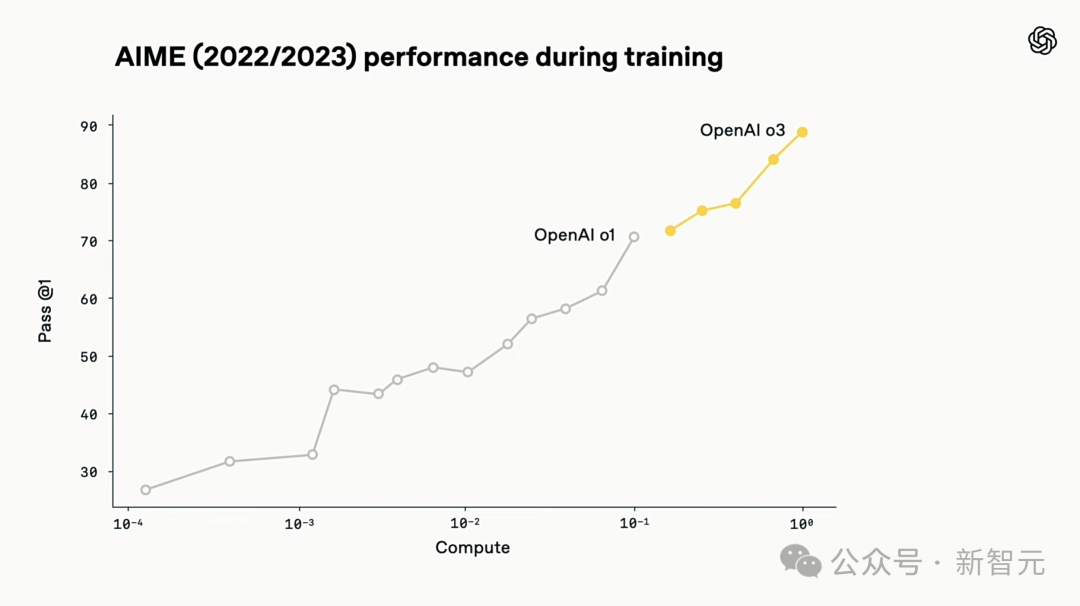

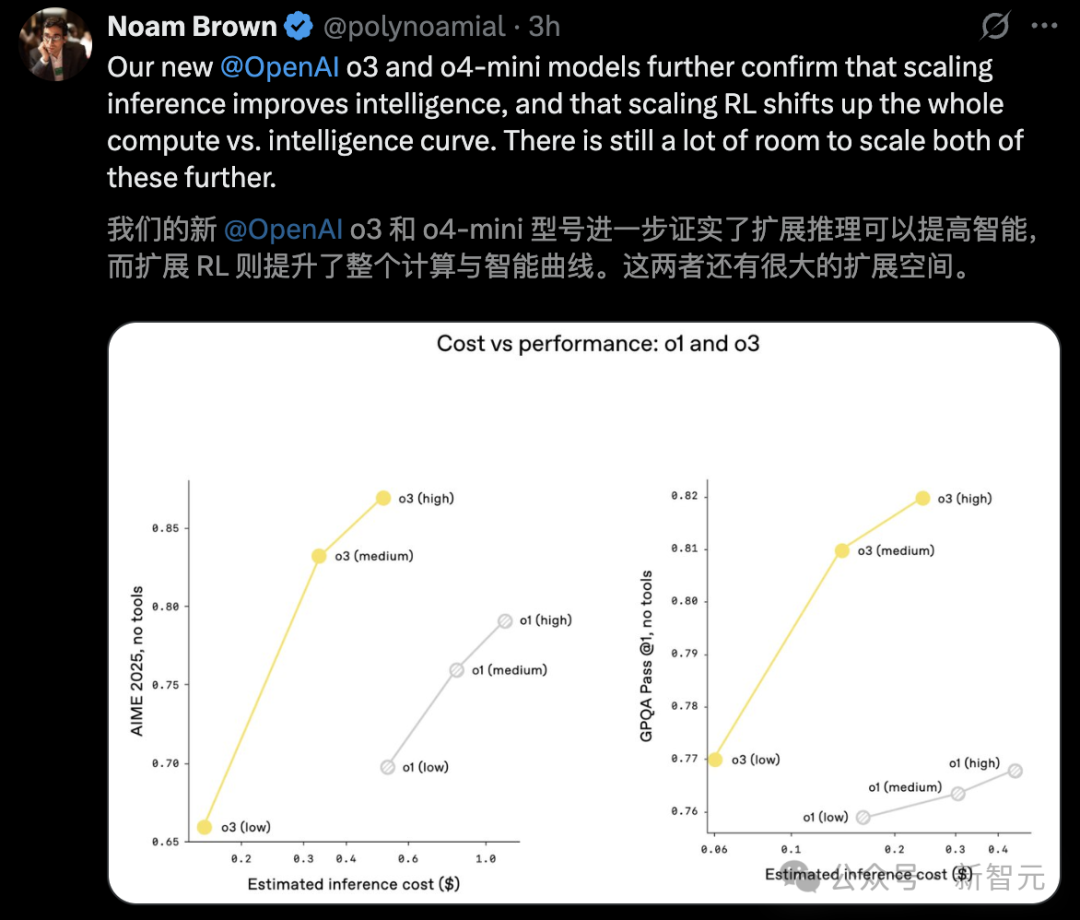

在OpenAI o3的整个研发过程中,研究者观察到一个现象:大规模强化学习同样遵循着GPT系列预训练时显现的规律——即“投入越多的计算资源,就能获得越好的性能”。

他们循着这条Scaling路径,这次将重点放在强化学习(RL)上,把训练计算量和推理阶段的思考量(或称推理计算量)都提升了一个数量级,结果依然观察到显著的性能提升。

技术报告:https://cdn.openai.com/pdf/2221c875-02dc-4789-800b-e7758f3722c1/o3-and-o4-mini-system-card.pdf

这验证了只要给模型更多时间去“思考”,它的表现就会持续提高。

相较于前代o1,o3在相同延迟和成本下展现出更高的性能。更令人兴奋地是,当允许思考更长时间,其性能还会继续攀升。

此外,OpenAI通过强化学习训练,让o3和o4-mini掌握了工具使用的智慧——不仅学会“如何用”,更懂得“何时用”。

它们不仅能完全访问ChatGPT内置的工具,还能通过API中的函数调用功能接入用户自定义的工具。

这种能力让模型在开放式场景时,更加游刃有余,尤其是在需要视觉推理和多步骤工作流的复杂任务中。

而且,从前面诸多案例中,我们已经对模型工具调用的能力,获得了关键一撇。

那些提前拿到内测资格的大佬们,纷纷被o3震惊了。

尤其是在临床和医学领域,它的表现堪称现象级。无论是诊断分析还是治疗建议,仿佛出自顶尖专家的手笔。

不论是加速科学发现、优化临床决策,还是推理跨领域的创新,o3正成为这场变革的主导者。

参考资料:

https://openai.com/index/thinking-with-images/

https://openai.com/index/introducing-o3-and-o4-mini/